Битые ссылки найти: лучшие сервисы для проверки – База знаний Timeweb Community

лучшие сервисы для проверки – База знаний Timeweb Community

У вас может быть очень крутой сайт. Качественный, с интересным контентом, с полезными товарами. Дизайном шикарным и удобным меню. Но если на нем есть битые ссылки (особенно если их много), это автоматически делает его подозрительным в глазах поисковых роботов и создает дурное впечатление о ресурсе со стороны посетителей. Такого допускать нельзя. Ваш прекрасный сайт должен быть прекрасным во всем. И мы этого добьемся.

Что такое битая ссылка?

Битая ссылка — это страница на сайте, которую нельзя открыть. Ее не существует. Когда потенциальный посетитель пытается на нее попасть, то получает в ответ ошибку. Это может быть ошибка 404 Not Found или 400 Bad Request. Или без кода вовсе: Timeout, Empty, Reset. Зависит от настроек конкретного ресурса. Оболочка разная, а смысл один и тот же. Сервер говорит, что искомой страницы здесь нет.

Такие ссылки еще изредка называют «мертвыми». Они возникают по нескольким распространенным причинам:

- В адресе страницы допущена ошибка.

Неправильно написано слово или не хватает какого-то символа. Или не настроены алиасы.

Неправильно написано слово или не хватает какого-то символа. Или не настроены алиасы. - Структуру сайта недавно кардинально поменяли, не настроив при этом перенаправление со старых ссылок.

- Ссылки на сторонний контент на странице удалили или каким-либо образом «сломали».

- В коде сайта затесались ошибки. В HTML или в JavaScript. Может быть, это сбой в CMS.

Комьюнити теперь в Телеграм

Подпишитесь и будьте в курсе последних IT-новостей

ПодписатьсяЧем опасны битые ссылки?

Есть две неподтвержденные теории и один солидный факт, подтверждающие серьезную угрозу со стороны битых ссылок.

Первая теория такая. Считается, что поисковые роботы Google и Яндекс не любят битые ссылки. Заприметив оные, поисковики решат, что сайт уже давно бросили или сделали так криво, что и стыдно его людям показывать. В связи с этим, позиции ресурса в Google и Яндекс заметно «просядут». Но никто еще не доказал, что это так.

Вторая теория. Якобы битые ссылки расходуют краулинговый бюджет — объем страниц, который поисковики сканируют за определенный период времени. Здесь вмешался представитель Google и сказал, что появление 404 ошибки никак не повлияет на краулинговый бюджет.

А вот что реально важно, так это отношение посетителей к сайту с битыми ссылками. На таких долго не задерживаются. Обычно 404 Not Found говорит о том, что надо бы перейти на главную страницу и воспользоваться поиском. Но всем плевать. Человек просто вернется в Google и будет искать ресурс с рабочими ссылками. Все. Вы потеряли своего посетителя.

Из-за этого вырастет доля отказов. А это не только упущенная аудитория, но и проблемы с ранжированием. Поисковик простит вам битую ссылку, но не простит визитер, который провел на сайте всего секунду и неожиданно убежал.

Читайте также

Как разыскать все битые ссылки на сайте?

Никто не будет сидеть и тыкать во все ссылки на сайте, чтобы найти битые. Тем более, если такие есть на чужих ресурсах. Поиском мертвых страниц занимаются специальные веб-сервисы и приложения. Кому что удобнее.

Тем более, если такие есть на чужих ресурсах. Поиском мертвых страниц занимаются специальные веб-сервисы и приложения. Кому что удобнее.

Я бы советовал не останавливать выбор на чем-то одном. Бывает так, что один сервис отображает неполную информацию. Это как с антивирусами. В тандеме находят больше угроз, чем по одиночке.

Google Search Console

Официальная панель управления Google отлично справляется с поиском битых ссылок. Так что можно отлавливать 404-е с помощью нее. Надо только подтвердить свои права на домен, а потом открыть пункт меню «Покрытие».

Яндекс.Вебмастер

Аналогичная функция есть в Яндексе. В их Вебмастере есть раздел «Ссылки», где можно взглянуть на все поломанные. Только вот здесь есть сложности с экспортом отчета. Раньше не было удобного способа вытащить все данные об ошибках, чтобы потом их устранить. Сейчас можно скачать TSV-файл с 10 000 битых ссылок. Кому-то даже этого будет мало.

Xenu

Это старая программа, но отчеты из нее многие до сих пор считают эталонными. Xenu предоставляет информацию бесплатно, поэтому можно попробовать самостоятельно и без финансовых потерь.

Xenu предоставляет информацию бесплатно, поэтому можно попробовать самостоятельно и без финансовых потерь.

- Поддерживает страницы с шифрованием.

- Работает быстрее большинства аналогов.

- Может обнаружить перенаправления.

- Позволяет делать повторные проверки.

Broken Link Checker

Это даже не отдельная программа, а плагин для WordPress. Дико популярный и полезный. Из плюсов можно выделить то, что он бесплатный и встраивается в WordPress. А из минусов — то, что он не всегда работает корректно и сложно настраивается. Часто приходится запускать модуль по несколько раз, чтобы был какой-то прок. Но другие дополнения к WordPress подобного рода оказываются еще хуже.

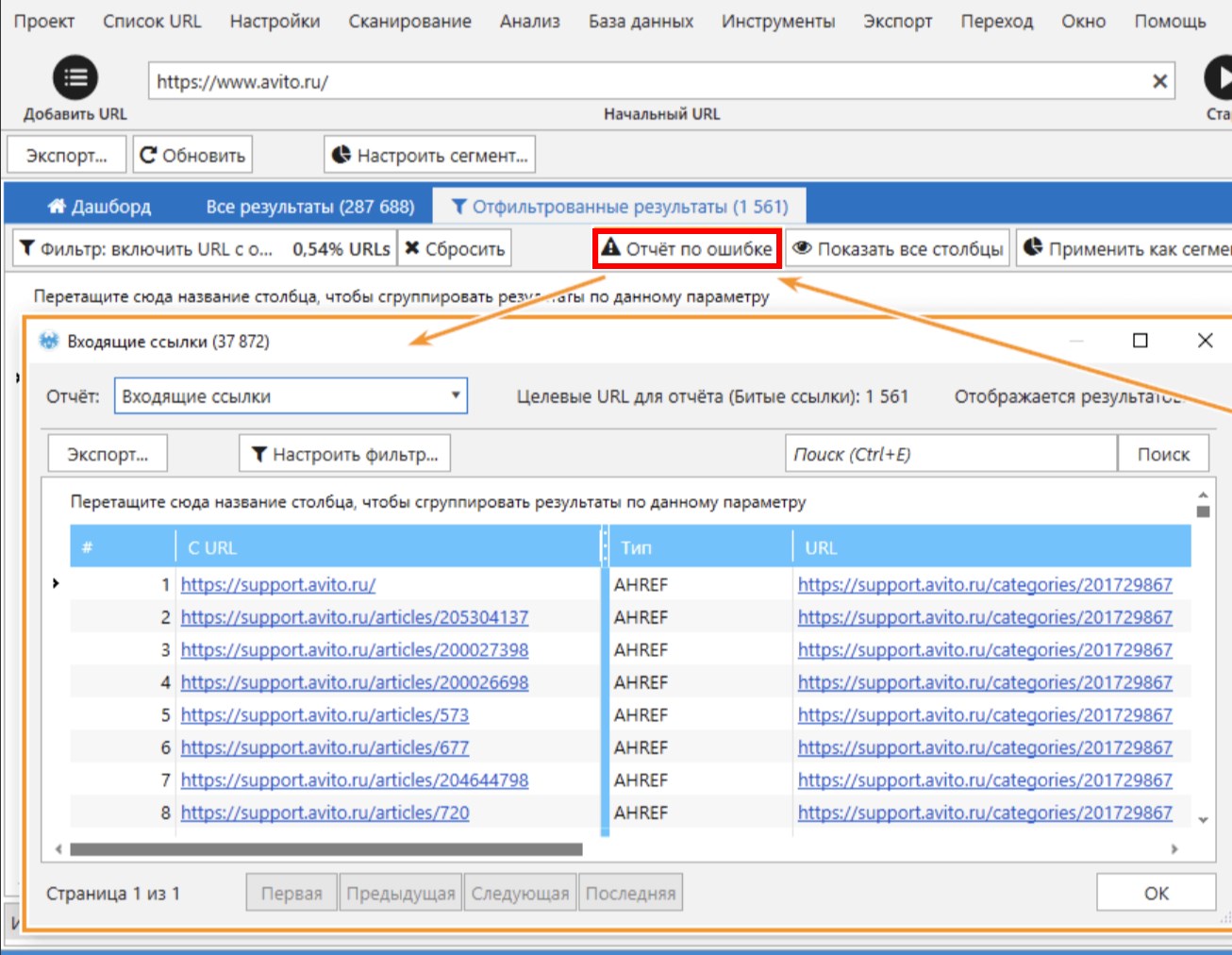

Netpeak Spider

Это дорогой и сложный инструмент для скрупулезного SEO-аудита. Он справляется с поиском сломанных страниц, но создавался для решения более широкого круга задач. Скорее всего, его покупка себя полностью не оправдает. Но функциональность хвалят, да.

Dead Link Checker

Платный онлайн-сервис для поиска ошибок 404 на ресурсе. Работает по подписке. То есть платите 10$ в месяц и получаете возможность отсканировать до 50 000 ссылок. Когда есть бесплатные альтернативы, кажется, что это не самый лучший выбор. Но я его не тестировал. Возможно, он творит какие-то чудеса и находит то, что не способны найти конкуренты.

Есть еще с десяток подобных приложений и сайтов, но они так себе. Либо работают чересчур медленно, либо стоят неадекватно дорого.

Нашел все битые ссылки, что дальше?

То, что нашли, уже хорошо. Только теперь надо их исправить. Будем действовать по следующей схеме действий:

- Разберем все ссылки.

- Категоризируем их.

- И исправим все ошибки.

Анализируем ссылки

Сначала надо организовать данные, полученные из сервисов по поиску битых ссылок. Надо понять, почему те или иные ссылки поломаны. Например, если дело в опечатке, то проще всего исправить эту самую опечатку в коде сайта.

Поэтому для начала можно создать такую простенькую табличку:

| Мертвая ссылка | Количество посещений | Редирект сюда |

| kakaya-to-statya.net | 17 | kakaya-to-statya.blog.net |

| sayt-s-opechatkay.ru | 12 | — |

| sayt-s-opecahtloy-2.ru | 1 | — |

На ней сразу будет видно ссылки, которым нужен редирект, ссылки, для которых стоит заморочиться с исправлением опечаток, и те, о которых можно забыть.

Но это, конечно, исключительно пример. Вы можете организовать полученную информацию, как вздумается.

Исправляем опечатки

Опечатки бывают двух типов. Те, что допустили вы как владелец сайта. И те, что допускают посетители, надумавшие зайти к вам вручную, указав адрес страницы (страшные люди). Какие опечатки стоит исправлять и так понятно. Те, что допустили сами.

Но есть еще один момент. Если по ссылке с опечаткой пытаются пройти регулярно, то имеет смысл настроить перенаправление на правильную страницу. Или сделать вариант с опечаткой рабочей альтернативой для самых настойчивых.

Настраиваем редирект

Теперь займемся ссылками, которые по-вашему мнению нуждаются в перенаправлении.

Тут и пригодится таблица, которую я описал выше. Наглядно показано, что и куда должно переехать.

Расскажу, как можно сделать 301 редирект в CMS WordPress и с помощью файла .htaccess

WordPress

- Открываем вкладку «Инструменты»

- Переходим в подпункт «Плагины».

- Кликаем по поисковому полю.

- Ищем плагин Redirection и устанавливаем его.

В поисковике будут и другие плагины, с помощью которых можно настроить редирект. Можете попробовать их. Это уже дело вкуса.

- Потом снова открываем вкладку «Инструменты».

- Переходим к настройкам плагина «Перенаправления».

- Нажимаем на Add new redirection.

- Указываем Source URL (ссылку, с которой надо перенаправить).

- А потом Target URL (куда надо перенаправить).

- И сохраняем заданные параметры.

Ну и так придется повторять до тех пор, пока все ссылки, нуждающиеся в перенаправлении, не получат его. Эти задачи нередко достаются верстальщикам на аутсорсе или «разнорабочим» с UpWork и других бирж.

Как сделать массовый редирект

При переезде на новый домен вручную делать редирект всех битых ссылок — это нерациональный адский труд. Поэтому проще воспользоваться массовым редиректом. Делаем следующее:

- Открываем сайт для генерации файла .

htaccess с настроенным перенаправлением.

htaccess с настроенным перенаправлением. - Ставим галочки напротив пунктов Mass Redirect to another Domain и 301 Redirect URLs.

- Напротив первого вписываем название сайта.

- Напротив второго домен, с которого нужно перенаправить пользователей, и домен, на которой надо перенаправить.

- Нажимаем на кнопку Generate .htaccess в нижней части страницы.

- Потом копируем сгенерированный код и вставляем его в файл .htaccess на сервере.

Впрочем, так можно сгенерировать код для любого типа перенаправлений.

Что делать с битыми ссылками на чужих сайтах?

Теперь вы знаете, что делать со страницами, которые убили сами и к которым у нас есть доступ. Проблематичнее дела обстоят с чужими сайтами, где есть ссылки на ваш ресурс. Они тоже подвержены опечаткам и переезду. Тоже будeт ошибка. Но дело поправимое.

Попросим владельца сайта поменять ссылку

Это, наверное, до боли очевидное решение. Просто постучите владельцам сайта, на котором лежит битая ссылка на ваш ресурс. Попросите их исправить опечатку или указать в материале обновленный адрес. Если удастся с ними связаться, то больше ничего делать и не придется. Все поправят за вас. Но шансы, что вас проигнорируют ощутимо выше.

Просто постучите владельцам сайта, на котором лежит битая ссылка на ваш ресурс. Попросите их исправить опечатку или указать в материале обновленный адрес. Если удастся с ними связаться, то больше ничего делать и не придется. Все поправят за вас. Но шансы, что вас проигнорируют ощутимо выше.

Настроим редирект с битой ссылки на рабочую

Работает так же, как и в случае со своими ссылками. Просто настройте редирект, чтобы пользователь оказался в нужном месте. Для этого не надо ни с кем связываться и ждать ответа. Настраиваем перенаправление удобным способом и радуемся.

Заново создаем пропавшую страницу

Если уже успели удалить страницу, на которую ведет битая ссылка, то можно создать ее заново. Добавьте туда аналогичный контент. Или тот же, что был раньше. Это может пригодиться, если с чужой страницы приходит большое число посетителей.

Настроим редирект на похожую страницу

Может, контент на уже несуществующей странице устарел? Подумайте, возможно, у вас есть страничка с похожей информацией. Будет хорошей идеей настроить редирект на нее. Тогда и вы ничего не теряете, и посетитель получит то, чего ждет.

Будет хорошей идеей настроить редирект на нее. Тогда и вы ничего не теряете, и посетитель получит то, чего ждет.

И бонусом делаем кастомную страничку 404

Тоже хороший вариант. Сделайте страницу с ошибкой 404 более привлекательной. Оригинальной, что ли. Добавьте картинку, анимацию. Не плоскую шутку. А самое главное, ссылку на главную страницу или на встроенный поисковик. Так вы в десятки раз повысите вероятность, что пользователь останется на вашем сайте, а не ретируется, заметив страшные черные буквы — Not Found.

Можно испробовать все описанные способы в том же порядке. Не ответил владелец чужого сайта? Пилите редирект. Не подходит вариант с редиректом? Так хотя бы сделайте нормальную страничку с ошибкой. Это уже что-то.

Выводы

Итак, еще раз:

- Битые ссылки — поломанные страницы, отзывающиеся ошибками 400 и 404.

- Они портят жизнь посетителям вашего сайта. Так что придется принимать какие-то меры.

- Их несложно найти с помощью бесконечного количества сайтов и программ, заточенных под эту задачу.

- И есть ворох путей исправления ситуации, независимо от того, почему появились проклятые битые ссылки.

Думаю, на этом и закончим. Спасибо.

что это, как найти, исправить, удалить

Поисковые системы совершенствуют алгоритмы ранжирования и стараются выводить в результатах поиска наиболее качественные ресурсы, отвечающие запросам пользователей. Соответственно, владельцы сайтов вкладывают много сил, чтобы именно их ресурсы занимали наивысшие позиции. Давайте представим, что вы ищете беговые кроссовки из последней коллекции известного бренда. Вы кликаете по нужной ссылке в результатах поиска и попадаете не на страницу магазина с желаемым товаром, а на экран с печальной надписью «404 Not Found», «Страница не найдена», «Нет такой страницы» и все в таком духе.

Страница 404 на примере Google

Такая ситуация может случиться и при переходе по внутренним ссылкам сайта. Давайте разберемся, почему так происходит и как с этим бороться.

Что такое битые ссылки

Битая ссылка – это гиперссылка на страницу, адрес которой был изменен или она была удалена с сайта. Иными словами, по данному адресу страницы больше нет, и при запросе к серверу он возвращает код ответа 4xx Client Error: чаще всего «404 Not Found» и в редких случаях – «410 Not Found» (окончательное удаление адреса из индекса поисковых систем).

На несуществующие страницы могут вести ссылки на самом сайте (внутренние битые ссылки) или размещенные на сторонних ресурсах (внешние битые ссылки). Одна из базовых задач по оптимизации веб-ресурса заключается в регулярной проверке на наличие битых ссылок и их устранение.

Как появляются битые ссылки

Причинами появления ссылок на несуществующие адреса являются:

- удаление контента из-за его неактуальности;

- изменение URL-адреса;

- ошибки в настройке веб-сервера;

- технические ошибки на сайте;

-

специальный/случайный ввод в адресную строку браузера несуществующих адресов.

Рассмотрим их подробнее.

Удаление неактуального контента

Часто возникают ситуации, когда какие-то товары, услуги, а иногда и целые разделы сайта становятся неактуальными: например, в случае обновления ассортимента. Многие владельцы сайтов просто удаляют такие страницы. При этом они забывают, что на них могут вести внутренние или внешние ссылки. После удаления страниц они автоматически станут нерабочими, притом что часть этих страниц могла бы ранжироваться в поисковых системах на хороших позициях.

В итоге пользователь перейдет по такой гиперссылке и увидит экран с ошибкой:

Хорошо, когда страница 404 содержит дополнительное пояснение о том, что страница была перемещена или удалена

Поэтому важно следить, чтобы внутри сайта не оставалось нерабочих ссылок. А при удалении по возможности заранее настраивать 301-й редирект на актуальную или максимально близкую по содержанию страницу.

301 Редирект — это способ постоянного перенаправления поисковых систем и посетителей сайта на адрес, который отличается от изначально запрашиваемого.

Изменение адреса/структуры

Контент-менеджеры сайтов часто не имеют технических навыков. Из-за этого возникают ситуации, когда они пытаются изменить заголовок страницы или название ссылки на страницу из меню. Из-за особенностей движка сайта или случайной ошибки меняется URL-адрес страницы. Это означает, что по старому адресу страница стала недоступной и все ссылки на нее автоматически будут отдавать 404-ю ошибку.

Например, была страница с адресом https://site.ru/novosti/novost-1/, а после правок заголовка контенщиком адрес изменился на https://site.ru/novosti/samaya-svezhaya-novost-1/.

Другая ситуация – изменение адреса из-за смены родительского раздела. Она происходит, когда вы меняете структуру, переносите страницу из одного раздела в другой. Например, на сайте в разделе «Обувь» изначально было деление по типу обуви: ботинки, кроссовки, туфли и т. д., а потом уже на мужские, женские, детские. Соответственно, товар имеет привязку:

Например, на сайте в разделе «Обувь» изначально было деление по типу обуви: ботинки, кроссовки, туфли и т. д., а потом уже на мужские, женские, детские. Соответственно, товар имеет привязку:

https://site.ru/obuv/krossovki/muzhskie/tovar1/

Вы решили сделать сначала деление по полу, а потом уже по типу обуви. Следовательно, адрес товара в разделе приобретет вид https://site.ru/obuv/muzhskaya/krossovki/tovar1/

Или же решили добавить дополнительные подкатегории по сезону: https://site.ru/obuv/krossovki/muzhskie/zimnie/tovar1/

Во всех этих случаях происходит одно и то же: по изначальному адресу страница перестает существовать, все ссылки на нее становятся битыми.

При изменении структуры сайта или исправлении адреса страницы не забывайте обязательно настраивать 301 редирект со старого адреса на новый, а внутренние ссылки сайта заменять на актуальные.

Технические ошибки на стороне сервера

К появлению 404-х ошибок на сайте могут приводить и некорректные настройки веб-сервера. Например, когда движок сайта использует ЧПУ (человекоподобный URL), а сервер не настроен на переадресацию входящих запросов. Или когда при переходе сайта на защищенный протокол не было настроено перенаправление с http на https. Также причиной ошибок может служить кэширование страниц на стороне сервера перед выдачей клиенту.

Например, когда движок сайта использует ЧПУ (человекоподобный URL), а сервер не настроен на переадресацию входящих запросов. Или когда при переходе сайта на защищенный протокол не было настроено перенаправление с http на https. Также причиной ошибок может служить кэширование страниц на стороне сервера перед выдачей клиенту.

Случайные ошибки и человеческий фактор

Никто не застрахован от ошибок. Достаточно опечатки в одну букву, чтобы получить нерабочую гиперссылку. Поэтому каждый раз после обновления контента важно проверять работоспособность перелинковки.

Программы для проверки битых ссылок на сайте

Как часто нужно проводить поиск битых ссылок и с помощью чего это делать? Мы рекомендуем регулярные проверки, не реже 1 раза в месяц. Если контент вашего ресурса обновляется часто, проверки можно проводить более регулярно: например, для новостных сайтов раз в неделю.

Рассмотрим наиболее популярные программы для поиска битых ссылок:

-

Screaming Frog SEO Spider Tool.

Программа имеет широкий спектр настроек и анализирует много параметров, в том числе показывает, на каких страницах и какие ссылки битые. Подходит для анализа не очень больших сайтов, т.к. даже платная версия имеет ограничение по количеству сканируемых URL-адресов. В бесплатном варианте вы сможете проверить лишь 500 УРЛов.

Программа имеет широкий спектр настроек и анализирует много параметров, в том числе показывает, на каких страницах и какие ссылки битые. Подходит для анализа не очень больших сайтов, т.к. даже платная версия имеет ограничение по количеству сканируемых URL-адресов. В бесплатном варианте вы сможете проверить лишь 500 УРЛов.

- Netpeak Spider. Также очень удобная платная программа с большим набором параметров для анализа.

- Xenu’s Link Sleuth. Программа предназначена только для операционной системы Windows и имеет свои недостатки, но является бесплатной.

- Majento SiteAnalyzer. Также бесплатная программа для анализа вашего сайта.

Онлайн сервисы проверки битых ссылок на сайте

Онлайн-сервисы — их достаточно много, но не все хорошо справляются со своей задачей. Отмечу несколько достойных вариантов:

-

Online Broken Link Checker.

Имеет бесплатную версию для проверки до 3000 URL, но с ограничениями и без возможности экспорта результатов. Коммерческая версия обладает более широкими возможностями, плюс есть возможность персональной настройки.

Имеет бесплатную версию для проверки до 3000 URL, но с ограничениями и без возможности экспорта результатов. Коммерческая версия обладает более широкими возможностями, плюс есть возможность персональной настройки.

- Deadlinkchecker. Сервис дает проверить бесплатно до 2001-й ссылки.

Проверка битых ссылок в «Яндекс.Вебмастере» и «Google Search Console»

Нельзя не сказать про отслеживание внутренних и внешних битых ссылок на сайте с помощью сервисов «Яндекс» и Google для вебмастеров. В панелях «Яндекс.Вебмастер» и Google Search Console вы сможете увидеть страницы с 404-й ошибкой, которые были исключены из индекса, проанализировать, что явилось причиной их появления и принять решение о необходимости их исправления.

Так это выглядит в «Яндекс.Вебмастере»:

Проверяем 404-е страницы в разделе «Страницы в поиске» меню «Индексирование»

А вот так в Google Search Console:

Проверяем 404-е страницы в разделе «Покрытие» меню «Индекс»

Читайте также:

Отличия SEO под Яндекс и Google

Как исправить битые ссылки

Для исправления битых ссылок рекомендуется следующее:

-

Обязательная замена внутренних ссылок на работающие или их удаление.

- Настройка 301-го редиректа с несуществующего адреса на актуальную страницу или максимально близкую по содержанию. Этот вариант рекомендован, если удаленная/перенесенная страница находилась в продвижении, приносила трафик или на нее идет ссылочный вес, который вы хотели бы сохранить и перенаправить на другой адрес.

При настройке 301 редиректа, последовательные переадресации не должны иметь более 3 переадресаций — это снижает передаваемый вес и замедляет скорость загрузки страниц.

Не забывайте проводить регулярные проверки на работоспособность внутренних ссылок, это повышает доверие к ресурсу ваших посетителей и поисковых систем.

Опасны ли битые ссылки и нужно ли с ними бороться?

Влияют ли битые ссылки на ранжирование интернет-ресурса? Напрямую – нет, потому что не существует такого фактора ранжирования, когда за подобные ссылки вы однозначно получите понижение позиций. Однако это не значит, что битые ссылки на сайте никак не скажутся на результатах вашего продвижения.

Однако это не значит, что битые ссылки на сайте никак не скажутся на результатах вашего продвижения.

Читайте также:

Алгоритм Google Penguin: как выйти из-под фильтра и не попасть под санкции

Битые ссылки можно сравнить с дверью, за которой пользователь натыкается на кирпичную стену. Это явно не добавляет ему расположения к сайту. А что если таких ссылок достаточно много и посетитель за одно посещение сталкивается с несколькими из них или ваша страница 404 ничего об это не говорит, а представлена в стандартном варианте?

Для рядового пользователя написанное будет ничем не лучше иероглифов по понятности

После такого большинство посетителей просто закроет вкладку и покинет сайт раз и навсегда, так как вы не открыли перед ним другие «двери». Упущенный клиент, упущенная выгода, прерванная сессия повлекут за собой ухудшение поведенческих факторов. А поведенческие факторы, в свою очередь, имеют весомое значение для ранжирования интернет-ресурса в поисковых системах.

А поведенческие факторы, в свою очередь, имеют весомое значение для ранжирования интернет-ресурса в поисковых системах.

Оформление страницы 404-ой ошибки в стиле сайта (с наличием меню, выводом дополнительных блоков или ссылок для привлечения и удержания) поможет не потерять потенциального клиента.

Страница 404 сайта kokoc.com: визуальная и текстовая часть максимально дружелюбно сообщают пользователю о том, случилось и как решить проблемы

Часто задаваемые вопросы — Проверка мертвых ссылок

Вот некоторые распространенные вопросы и ответы на них.Описание возможностей Dead Link Checker можно найти здесь.

Щелкните здесь для получения списка кодов ошибок и их значений.

Если у вас есть вопрос, на который здесь нет ответа, вы можете связаться с нами по адресу:

[email protected]

В: Что такое мертвые/битые ссылки?

Мертвые или неработающие ссылки — это ссылки на веб-странице, которые не ведут пользователя туда, куда предполагал автор. Это может быть связано с тем, что ссылка была неправильно настроена автором сайта,

или из-за того, что целевой веб-страницы больше не существует, или из-за какой-либо другой проблемы с доступом к месту назначения (например, сервер не отвечает). Когда

щелчок по неработающей ссылке, код ошибки (например, 404 Not Found или 500 Server Error) обычно возвращается сервером или происходит тайм-аут, если сервер не существует или не возвращает никакой информации в течение

заданный промежуток времени.

Это может быть связано с тем, что ссылка была неправильно настроена автором сайта,

или из-за того, что целевой веб-страницы больше не существует, или из-за какой-либо другой проблемы с доступом к месту назначения (например, сервер не отвечает). Когда

щелчок по неработающей ссылке, код ошибки (например, 404 Not Found или 500 Server Error) обычно возвращается сервером или происходит тайм-аут, если сервер не существует или не возвращает никакой информации в течение

заданный промежуток времени.

Неработающие ссылки являются источником раздражения для пользователей и снижают рейтинг вашего сайта в результатах поиска. Сайты с более низким рейтингом получают меньше посетителей. Использовать deadlinkchecker.com, чтобы найти неработающие ссылки на вашем сайте, чтобы их можно было исправить, чтобы восстановить рейтинг сайта и привлечь больше веб-трафика.

В: Эта услуга бесплатна? Интерактивная версия этого сервиса бесплатна. Вы можете ввести URL-адрес веб-сайта, и он будет просканирован на наличие мертвых ссылок. Если вы вошли в систему с действительным адресом электронной почты, вы

может запросить отправку отчета по электронной почте после завершения сканирования, и вы можете указать несколько веб-сайтов для сканирования за одну операцию. Если вы делаете небольшой ежемесячный платеж

Чтобы подписаться на нашу автоматическую проверку, вы можете настроить ежедневное, еженедельное или ежемесячное расписание для автоматического сканирования ряда сайтов без каких-либо дополнительных действий.

Отчеты будут отправлены вам по электронной почте с подробной информацией о любых мертвых ссылках, обнаруженных на ваших веб-страницах.

Вы можете ввести URL-адрес веб-сайта, и он будет просканирован на наличие мертвых ссылок. Если вы вошли в систему с действительным адресом электронной почты, вы

может запросить отправку отчета по электронной почте после завершения сканирования, и вы можете указать несколько веб-сайтов для сканирования за одну операцию. Если вы делаете небольшой ежемесячный платеж

Чтобы подписаться на нашу автоматическую проверку, вы можете настроить ежедневное, еженедельное или ежемесячное расписание для автоматического сканирования ряда сайтов без каких-либо дополнительных действий.

Отчеты будут отправлены вам по электронной почте с подробной информацией о любых мертвых ссылках, обнаруженных на ваших веб-страницах.

SEO расшифровывается как поисковая оптимизация. Поисковые системы, такие как Google, Bing и т. д., упорядочивают свои результаты по ряду критериев, включая воспринимаемое качество

сайт индексируется. SEO предназначено для того, чтобы сайт занимал как можно более высокие позиции в результатах поисковой системы. Удаляя мертвые ссылки со своих веб-страниц, вы можете сигнализировать

поисковых систем, что сайт является активно поддерживаемым и надежным источником информации.

Удаляя мертвые ссылки со своих веб-страниц, вы можете сигнализировать

поисковых систем, что сайт является активно поддерживаемым и надежным источником информации.

Некоторые распространенные коды состояния сервера:

- 302 — страница перемещена на новое место

- 403 — запрещено

- 404 — страница не найдена

- 500 — внутренняя ошибка сервера

Дополнительная информация можно найти здесь.

В: Как запланировать сканирование сайта? Предполагая, что вы подписались на службу автоматической проверки и вошли в систему DeadLinkChecker.com, используя свой адрес электронной почты, вы можете

настроить сканирование по расписанию, щелкнув пункт меню «автоматическая проверка». При нажатии на кнопку «Добавить новое сканирование» появится небольшое окно, в котором вы можете

введите URL-адрес веб-сайта для сканирования, когда должно произойти следующее сканирование, как часто следует сканировать сайт и глубину сканирования. Щелчок

кнопка «Сейчас» запланирует запуск сканирования как можно скорее после того, как вы нажмете «Создать».

Щелчок

кнопка «Сейчас» запланирует запуск сканирования как можно скорее после того, как вы нажмете «Создать».

Когда сканирование запланировано, вы сможете проверить его статус или отредактировать детали сканирования. После запуска сканирования вы будете

отправил по электронной почте отчет с подробной информацией о любых найденных мертвых ссылках.

Чтобы исправить неверную ссылку, необходимо определить, почему ссылка помечена как неверная. Если это ссылка на несуществующую страницу (ошибка 404), то, скорее всего, ссылка была

неправильно набран в исходном HTML-коде (в этом случае вам необходимо его отредактировать) или целевая страница была временно или окончательно удалена или переименована. Если пункт назначения больше не существует

тогда вам либо нужно сделать ссылку на другую страницу, либо полностью удалить ссылку. В любом случае, если вы хотите изменить

ссылку, то вам нужно будет иметь возможность редактировать HTML-код веб-сайта или иметь доступ к кому-то, кто может сделать это за вас.

Нет, к сожалению, невозможно использовать средство проверки мертвых ссылок для сканирования страниц, защищенных паролем. Для этого наш сервер должен знать и хранить имя пользователя и пароль. сведения о сканируемом сайте, что может представлять угрозу безопасности.

В: Могу ли я ограничить сканирование подкаталогом моего сайта? Да — если вы начинаете сканирование со страницы в подкаталоге, то все ссылки, найденные на этой странице, будут проверены на существование, но только страницы в этом подкаталоге (или его потомке) будут проверены.

отсканировано для дальнейших ссылок.

Например, начиная с http://www.example.com/news/index.html, будут проверяться ссылки на такие страницы, как http://www.example.com/weather.html, но эта страница не будет сканироваться на наличие

больше ссылок, так как он не находится в подкаталоге новостей/. Однако страница http://www.example/com/news/current/story1.html будет просканирована на наличие ссылок, так как она находится в подкаталоге news/.

Обратите внимание, что это функция только автоматической проверки.

В корне большинства веб-сайтов находится файл robots.txt, например http://www.microsoft.com/robots.txt. Этот файл используется, чтобы сообщить

любая система, которая сканирует сайт (например, средство проверки ссылок или сканер сайта поисковой системы), какие страницы или папки не следует сканировать или индексировать. Файл robots.txt также можно использовать для указания местоположения

карта сайта и уменьшить скорость, с которой автоматические системы запрашивают страницы с сайта (используя директиву ‘crawl-delay’). Обратите внимание, что сканер не обязан следовать инструкциям в файле robots.txt.

это просто просьба вести себя определенным образом, но хорошо воспитанные сканеры попытаются подчиниться директивам. Dead Link Checker следует директивам «запретить» и «задержка сканирования», где это возможно. Используемый пользовательский агент

от Dead Link Checker — «www. deadlinkchecker.com». Для получения дополнительной информации о robots.txt посетите http://www.robotstxt.org/.

deadlinkchecker.com». Для получения дополнительной информации о robots.txt посетите http://www.robotstxt.org/.

Этого можно добиться двумя способами. Если вы можете редактировать файл robots.txt на сервере веб-сайта, вы можете добавить директиву, запрещающую проверке ссылок доступ к определенным страницам или ко всем страницам в определенном подкаталоге. Например, чтобы исключить

папку shoppingbasket/ (и все ее потомки), добавьте в robots.txt следующее:

Агент пользователя: www.deadlinkchecker.com Запретить: /корзина покупок/В качестве альтернативы, при использовании автоматической проверки в редакторе запланированного сканирования есть «расширенный» раздел, где вы можете указать список строк, которые будут использоваться для предотвращения проверки определенных URL-адресов. URL-адреса, содержащие любые строк, указанных в этом разделе, не будут проверены на наличие ошибок.

В: Не все страницы моего сайта были отсканированы, почему?

В: Не все страницы моего сайта были отсканированы, почему?Средство проверки мертвых ссылок проверяет ссылки на исходной странице, предоставленной ему, и, если какие-либо из этих ссылок находятся на том же веб-сайте, оно также проверяет связанные страницы на наличие мертвых ссылок и так далее. Глубина этого сканирования ограничена 10 для полного сканирования, поэтому любые ссылки, которые доступны только при прохождении большего количества шагов, не будут проверяться. Кроме того, страницы, на которые нет входящих ссылок, не будут обнаружены. Еще одно соображение заключается в том, что изменение субдомена рассматривается как изменение веб-сайта, поэтому ссылки на страницах этих доменов не проверяются (даже если они указывают на исходный домен). Например, при сканировании сайта http://www.example.com, ссылка на http://test.example.com будет проверена, но содержимое этой страницы не будет дополнительно проверено на наличие ссылок.

Ссылки также могут не сканироваться, если они запрещены в файле robots. txt сайта. Кроме того, Auto Checker будет игнорировать дочерние ссылки на связанных страницах.

с использованием атрибута rel=nofollow: сама ссылка будет проверена, но не будет сканироваться на наличие дополнительных ссылок. Страницы, содержащие тег, также не будут

проверьте наличие дополнительных ссылок в Auto Checker. Эту обработку ссылок или страниц «nofollow» можно переопределить в расширенном разделе сканирования.

всплывающее диалоговое окно настроек с помощью флажка «Переопределить директивы nofollow».

txt сайта. Кроме того, Auto Checker будет игнорировать дочерние ссылки на связанных страницах.

с использованием атрибута rel=nofollow: сама ссылка будет проверена, но не будет сканироваться на наличие дополнительных ссылок. Страницы, содержащие тег, также не будут

проверьте наличие дополнительных ссылок в Auto Checker. Эту обработку ссылок или страниц «nofollow» можно переопределить в расширенном разделе сканирования.

всплывающее диалоговое окно настроек с помощью флажка «Переопределить директивы nofollow».

В некоторых случаях средство проверки мертвых ссылок может не получить доступ к странице, доступной из вашего браузера.

Наш сервер находится в США, поэтому, если есть проблема с доступом к вашему сайту оттуда, или если ваш сайт

обслуживает различный контент в зависимости (например) от географического местоположения отправителя запроса, его пользовательского агента или IP-адреса, тогда вы можете увидеть сообщения об ошибках.

Некоторые сайты допускают доступ к чему-либо, кроме стандартного веб-браузера, и возвращают такие коды ошибок, как

как 404 (не найдено) или 403 (запрещено) для DeadLinkChecker.com

Некоторые веб-браузеры автоматически исправляют URL-адреса, которые на самом деле недействительны. Например, URL-адреса

не может содержать символ обратной косой черты ‘\’. Chrome и IE, кажется, молча преобразуют его в косую черту «/», но

в других браузерах нет. Средство проверки неработающих ссылок будет помечать такие URL-адреса как ошибки.

Иногда страницы временно недоступны, возможно, из-за проблем с загрузкой сервера. Dead Link Checker повторит попытку

ссылки после паузы, но если он не может получить доступ к странице, он будет помечен как плохая ссылка, даже если это возможно

чтобы перейти на страницу позже.

Сканирование Auto-Checker можно настроить так, чтобы оно игнорировало URL-адреса, которые, как вы знаете, являются действительными — щелкните ссылку «Дополнительно». в нижней части поля редактирования «Сканирование по расписанию». Вы также можете настроить время ожидания DeadLinkChecker до

решение о том, что страница не отвечает.

в нижней части поля редактирования «Сканирование по расписанию». Вы также можете настроить время ожидания DeadLinkChecker до

решение о том, что страница не отвечает.

Средство проверки неработающих ссылок — это онлайн-инструмент, который не будет работать в интрасети, потому что веб-страницы должны быть видны нашему серверу, который является внешним по отношению к вашей интрасети.

В: Будет ли инструмент работать на динамических (ASP/JSP/PHP/Rails) сайтах?Средство проверки мертвых ссылок будет работать на динамических страницах. Однако он проверяет любой заданный URL-адрес только один раз в сеансе сканирования, поэтому, если содержимое активной страницы изменяется от одного вызова к другому, тогда только ссылки, найденные при первом столкновении. будет обработан.

В: В чем разница между услугами Site Checker, Multi-Site Checker, Auto-Checker и Auto-Checker Premium и Professional? Site Checker — это бесплатный инструмент, который позволяет сканировать один веб-сайт на наличие мертвых ссылок. Multi-Site Checker также можно использовать бесплатно, но для этого требуется адрес электронной почты.

в качестве имени для входа. Затем вы можете сканировать несколько сайтов за один раз, и отчет автоматически отправляется вам по электронной почте в конце сканирования. Auto-Checker — наш начальный уровень

абонентское обслуживание. За небольшую ежемесячную плату вы можете автоматически сканировать до пяти сайтов по регулярному расписанию, при этом никаких дополнительных действий на вашем устройстве не требуется.

часть. Отчет будет отправлен вам по электронной почте после каждого сканирования, а также доступен в Интернете. Auto-Checker Premium и Professional позволяют проверять большее количество сайтов с большим количеством ссылок.

на каждом сайте.

Multi-Site Checker также можно использовать бесплатно, но для этого требуется адрес электронной почты.

в качестве имени для входа. Затем вы можете сканировать несколько сайтов за один раз, и отчет автоматически отправляется вам по электронной почте в конце сканирования. Auto-Checker — наш начальный уровень

абонентское обслуживание. За небольшую ежемесячную плату вы можете автоматически сканировать до пяти сайтов по регулярному расписанию, при этом никаких дополнительных действий на вашем устройстве не требуется.

часть. Отчет будет отправлен вам по электронной почте после каждого сканирования, а также доступен в Интернете. Auto-Checker Premium и Professional позволяют проверять большее количество сайтов с большим количеством ссылок.

на каждом сайте.

Средство проверки мертвых ссылок оптимизировано для максимально быстрого сканирования веб-сайтов, при этом скорость сканирования автоматически настраивается для уменьшения количества ошибок сервера. Однако некоторые серверы могут испытывать трудности, если страницы запрашиваются слишком быстро или запросы

может интерпретироваться как атака типа «отказ в обслуживании». Вы можете снизить скорость запроса страниц, изменив файл robots.txt на своем сервере, включив в него

секция:

Однако некоторые серверы могут испытывать трудности, если страницы запрашиваются слишком быстро или запросы

может интерпретироваться как атака типа «отказ в обслуживании». Вы можете снизить скорость запроса страниц, изменив файл robots.txt на своем сервере, включив в него

секция:

Агент пользователя: www.deadlinkchecker.com Задержка сканирования: 1Это ограничит количество запросов страниц примерно до одного в секунду. Сканирование будет значительно замедлено, но нагрузка на сервер будет пропорционально снижена.

В качестве альтернативы при использовании функции автоматической проверки вы можете получить доступ к «расширенным» настройкам в редакторе запланированного сканирования и ввести значение «Интервал», чтобы указать минимальная продолжительность между последовательными запросами страниц на сканируемом веб-сайте. В: Как средство проверки мертвых ссылок идентифицирует себя при сканировании веб-сайта?

Средство проверки мертвых ссылок использует строку пользовательского агента, начинающуюся с «www. deadlinkchecker.com», при запросе веб-страниц.

deadlinkchecker.com», при запросе веб-страниц.

IP-адрес сервера — 74.208.42.172 (до марта 2021 года — 82.165.25.77)

При использовании автоматической проверки вы можете посетить страницу автоматической проверки и просмотреть список созданных вами расписаний проверки. Детали все выполняемые проверки перечислены ниже этого раздела — вы можете увидеть статистику проверки, URL-адрес недавно проверенной ссылки и кнопки которые позволяют прервать сканирование или запросить промежуточный отчет об ошибке.

В: Могу ли я уменьшить количество получаемых писем?При использовании автоматической проверки вы можете отредактировать «расширенные» настройки сканирования и установить флажок «подавлять электронную почту, если нет ошибок» — это остановить проверку мертвых ссылок от отправки вам электронных писем, если запланированное сканирование не обнаружило ошибок.

В: Могу ли я изменить адрес электронной почты, на который отправляются отчеты? Из соображений безопасности средство проверки мертвых ссылок отправляет отчеты по электронной почте только зарегистрированному владельцу учетной записи. Вы можете изменить адрес электронной почты

адрес вашей учетной записи, когда вы вошли в систему, щелкнув значок настроек в правом верхнем углу. В качестве альтернативы следует

можно настроить программное обеспечение электронной почты для пересылки сообщения электронной почты с отчетом третьей стороне в зависимости от отправителя и/или строки темы.

Вы можете изменить адрес электронной почты

адрес вашей учетной записи, когда вы вошли в систему, щелкнув значок настроек в правом верхнем углу. В качестве альтернативы следует

можно настроить программное обеспечение электронной почты для пересылки сообщения электронной почты с отчетом третьей стороне в зависимости от отправителя и/или строки темы.

Вы можете настроить Google Analytics для фильтрации всех запросов с IP-адреса средства проверки неработающих ссылок (см. «Как идентифицирует себя средство проверки неработающих ссылок?»). Для инструкции по настройке Google Analytics смотрите здесь.

Вопрос. Считаются ли страницы с разными строками запроса разными страницами? Веб-страницы, созданные сервером, могут изменять свое содержимое в зависимости от переданных им параметров, поэтому средство проверки неработающих ссылок рассматривает страницы с разными строками запроса как

отдельные страницы, которые проверяются отдельно.

Отчеты, сгенерированные подписной службой Auto-Check, также можно загрузить в виде файла CSV, который можно сохранить на свой компьютер и импортировать. в Excel и т. д. для дальнейшего анализа. Ссылка для загрузки показана в нижней части онлайн-отчета.

Q: Что такое петля перенаправления? Когда запрашивается URL-адрес, сервер может ответить кодом состояния перенаправления (301 или 302), указывающим новое местоположение, которое должно быть

запрошенный для ресурса.

Если это новое местоположение совпадает с исходным запросом или если оно, в свою очередь, перенаправляет на исходный URL-адрес, то возникает петля перенаправления.

существует — запросы будут циклически повторяться бесконечно, никогда не возвращая запрошенную информацию. Dead Link Checker сообщает об этой ситуации

как цикл перенаправления. Большинство браузеров выдают аналогичное сообщение об ошибке после выполнения ряда перенаправлений.

Примечание: Некоторые веб-сайты или серверы ведут себя иначе, если файлы cookie отключены. Проверка мертвых ссылок Проверка сайта и множественная проверка не распространяют файлы cookie при сканировании сайта, если средство проверки неработающих ссылок сообщает о петле перенаправления, но кажется, что ссылка работает правильно в браузере, возможно, посещение ссылки с отключенными файлами cookie вызовет ошибку. Автоматическая проверка распространяется куки только для внешних ссылок. Вы можете узнать, как отключить или включить файлы cookie на www.whatarecookies.com/enable.asp

Вопрос. Как оптимизировать сканирование Auto-Checker?Перед запуском сканирования Auto-Checker необходимо выполнить несколько шагов. Выполнение этих шагов поможет оптимизировать использование вашей квоты ссылок, минимизируйте нагрузку на сервер и убедитесь, что вы видите результаты сканирования как можно быстрее.

•

Убедитесь, что электронные письма с адреса report_generator@deadlinkchecker. com не будут отклонены вашей почтовой программой. Ваши отчеты о сканировании обычно содержат много ссылок,

и иногда это может привести к срабатыванию детекторов спама, которые затем отклонят электронное письмо. Иногда это приводит к тому, что они отправляются в папку со спамом,

но если электронные письма возвращаются нам, это также может помешать отправке последующих электронных писем на вашу учетную запись.

com не будут отклонены вашей почтовой программой. Ваши отчеты о сканировании обычно содержат много ссылок,

и иногда это может привести к срабатыванию детекторов спама, которые затем отклонят электронное письмо. Иногда это приводит к тому, что они отправляются в папку со спамом,

но если электронные письма возвращаются нам, это также может помешать отправке последующих электронных писем на вашу учетную запись.

•

Используйте функцию «игнорировать» в настройках сканирования, чтобы запретить сканеру проверять ненужные URL-адреса на вашем сайте. Поле «игнорировать»

позволяет ввести список текстовых фрагментов, и сканер будет игнорировать URL-адреса, содержащие любой из них. Например, если есть

ссылку на каждой из страниц вашего сайта, чтобы добавить товар в корзину, то вам обычно не нужно проверять эти ссылки, поэтому вы можете отфильтровать их

добавив /cart/ или /checkout/ или что-то подобное в список игнорирования — в зависимости от того, как устроен ваш сайт. Точно так же вы можете захотеть

игнорировать URL-адреса, содержащие, например, /login или /search — проверьте свой веб-сайт на наличие таких URL-адресов перед началом сканирования.

Точно так же вы можете захотеть

игнорировать URL-адреса, содержащие, например, /login или /search — проверьте свой веб-сайт на наличие таких URL-адресов перед началом сканирования.

• Убедитесь, что ваш сервер не интерпретирует сканирование как атаку, которая может привести к тому, что серверу проверки ссылок будет отказано в доступе к вашему сайту. Если в этом случае вы обычно увидите большое количество непредвиденных ошибок, обычно (но не всегда) 403 Forbidden, 503 Service Unreachable или 400 Bad Request. Если возможно, внесите в белый список IP-адрес нашего сервера (74.208.42.172), чтобы сканирование всегда было разрешено.

•

На сайтах-каталогах или сайтах, содержащих большие списки элементов, часто есть опции для просмотра элементов страница за страницей с различными фильтрами.

ограничивать или сортировать показанные элементы, например, по цвету или по производителю, или по тому и другому. Если эти параметры фильтра добавляются к URL-адресу с помощью ‘?’ параметры

тогда средство проверки ссылок будет рассматривать каждую уникальную комбинацию терминов фильтра как новый URL-адрес. Это может привести к потенциально огромному количеству

различных комбинаций, даже если существует вполне управляемое количество просматриваемых элементов каталога. Например, сайт со списком автомобилей.

могут иметь варианты выбора по производителю, стилю, цвету, возрасту и цене с использованием URL-адреса, такого как

Если эти параметры фильтра добавляются к URL-адресу с помощью ‘?’ параметры

тогда средство проверки ссылок будет рассматривать каждую уникальную комбинацию терминов фильтра как новый URL-адрес. Это может привести к потенциально огромному количеству

различных комбинаций, даже если существует вполне управляемое количество просматриваемых элементов каталога. Например, сайт со списком автомобилей.

могут иметь варианты выбора по производителю, стилю, цвету, возрасту и цене с использованием URL-адреса, такого как

findmeacar.com/list?manufacturer=ford-bmw-mercedes&style=coupe&color=red-green-black&age=3&price=10000-20000Если есть 10 разных производителей на выбор, 9 стилей, 15 цветов, 8 возрастных групп и 5 ценовых диапазонов, и если можно выбрать любой или все эти варианты, то это приведет к более чем 140 триллионам различных комбинаций! Это явно растратит всю вашу квоту на ссылки, не дав ничего полезного. Даже если в каждой категории можно сделать только один выбор (или ни одного), это приведет к более чем 95000 комбинаций.

В таких случаях лучший вариант

чтобы добавить все фильтры в список игнорирования:

В таких случаях лучший вариант

чтобы добавить все фильтры в список игнорирования:производитель=Тогда сканер не пропадет ресурсы, сканирующие различные комбинации одних и тех же элементов, но, надеюсь, все же смогут найти все элементы каталога по отдельности, просматривая список постранично.

стиль=

цвет=

возраст=

цена=

• В общем, рекомендуется следить за новым сканированием по мере его выполнения — следить за URL-адресами, которые проверяются на убедитесь, что нет пропущенных параметров фильтра и что все URL-адреса кажутся разумными. Если вам нужно отказаться от сканирования, вы можете нажать кнопку кнопку «Завершить сканирование», измените настройки «игнорировать» и перезапустите сканирование, чтобы повторить попытку.

МУЛЬТИПРОВЕРКА

Multi Check позволяет запускать средство проверки мертвых ссылок на нескольких веб-сайтах за один раз. Затем отчет автоматически отправляется вам по электронной почте.

Затем отчет автоматически отправляется вам по электронной почте.АВТОПРОВЕРКА

Наша самая популярная услуга — Auto Check, которая запускает проверку неработающих ссылок на вашем веб-сайте (-ах) на регулярно и автоматически отправляет вам отчеты по электронной почте.Планы подписки — средство проверки мертвых ссылок

Гость Войти Создать аккаунт

| Предпочтительная валюта: | $USD €EUR фунтов стерлингов | ||

| * Устройство автоматической проверки — стандартное | * Автоматическая проверка — Премиум | * Auto Checker — Professional | |

|---|---|---|---|

| Проверить сайт | |||

| Проверить список сайтов, отчет по электронной почте | |||

| Автоматическая регулярная проверка сайтов, отчетов по электронной почте | |||

| Максимальное количество веб-сайтов | 1-5 | 100 | 200 | Максимальное количество ссылок в месяц | 50 000 | 500,000 | 1,000,000 |

| Ежемесячный платеж | $9. 95/месяц 95/месяц | $39,95/месяц | $79,90/месяц |

| Годовой платеж | $110/год — ЭКОНОМИЯ 7,5% | $440/год — ЭКОНОМИЯ 8% | $880/год — ЭКОНОМИЯ 8% |

| * Чтобы получить доступ к многосайтовой проверке или автоматической проверке, сначала войдите в систему или создайте бесплатную учетную запись. | |||

- Отличное предложение — менее 10 долларов в месяц.

- Меньше хлопот — особенно если вам нужно регулярно отслеживать несколько веб-сайтов.

- Выбор частоты сканирования — ежедневно, еженедельно или ежемесячно.

- Standard — проверяйте до 5 веб-сайтов в месяц и до 50 000 ссылок за 9,95 долларов США в месяц или разовый платеж в размере 110 долларов США в год.

Неправильно написано слово или не хватает какого-то символа. Или не настроены алиасы.

Неправильно написано слово или не хватает какого-то символа. Или не настроены алиасы.

Об авторе