Переоптимизация: Переоптимизация сайта — Devaka SEO Блог

Переоптимизация сайта — Devaka SEO Блог

21.9К просмотров

Данная статья написана по мотивам доклада «Переоптимизированность сайтов», озвученного автором на конференции Optimization.by в Минске. С её помощью хотелось бы побудить вебмастеров к созданию качественных сайтов, оптимизаторов к здравому смыслу и всех остальных к внимательному отношению к своему контенту.

Что такое оптимизация?

Если рассмотреть значение оптимизации в информатике, то под этим термином понимают модификацию системы с целью повышения её эффективности. Другими словами, оптимизируя сайт, мы стремимся увеличить его эффективность. При этом, метриками эффективности могут выступать совершенно различные показатели, в зависимости от типа сайта и его целей.

Если определенная модификация системы (в данном случае сайта) приближает к цели, то это можно назвать оптимизацией.

Проводя аналогию с украшениями на лице в качестве своеобразных его модификаций с целью получения успеха у противоположного пола или при вступлении в престижный ВУЗ, оптимизация будет выглядеть следующим образом:

Определенная красота в различных частях сайта (заголовке, контенте, коде) также способна приблизить нас к цели (от улучшения позиций в поиске до повышения конверсии посетителей).

Что такое переоптимизация?

Переоптимизация есть превышение меры. В контексте сайта это будет информационная перенасыщенность (например, в имени домена, адресе страницы, в контенте, ссылках или html-коде). Если продолжить аналогию с украшениями, то переоптимизацию можно отобразить примерно так:

Причина переоптимизированности часто заложена в неверном определении метрик эффективности сайта. Но что плохого в превышении меры?

Имитация. В данном случае релевантности.

При переоптимизации сайт, на самом деле, не релевантент запросам, под который его оптимизируют, он просто имитирует эту релевантность.

Снижение конверсии.

Любое превышение меры снижает конверсию, так как заголовки и контент становятся нечитабельными (не только на сайте, но и в результатах поиска). Соответственно, поисковых запросов много – переходов на сайт мало, трафик есть – продаж или подписок нет!

Привлечение санкций. Со стороны поисковых систем.

Переоптимизация часто сравнима с переспамом (перенасыщенностью контента ключевыми словами), поисковые системы отслеживают эти сигналы и стараются не показывать такие сайты высоко в поиске. Отдельные сигналы вовсе ведут к бану (исключению из индекса).

Простыни с текстом и ключевиками для Яндекса уже неактуальны. Некоторые вебмастера, в последнее время, могли заметить резкое снижение позиций сайта и сообщения от службы поддержки, уведомляющие о переоптимизированности текстов.

Под фильтр Google Panda также, в первую очередь, попадают переспамленные тексты, потом уже копипаст (дубли) и другой низкокачественный контент.

Примеры

Рассмотрим несколько примеров переоптимизации сайта для каждого из отдельных его элементов.

Заголовок страницы TITLE

Выше представлен самый простой пример переоптимизации, где через запятую в заголовке TITLE перечисляются необходимые ключевые слова.

Ещё один заголовок TITLE и мета-теги description и keywords

Подобные заголовки составляются исключительно для поисковых систем, без учета того, что на них будут смотреть пользователи.

Другой пример переоптимизированности мета-тегов

[кликните на изображение для увеличения]

Оптимизатор, в данном случае, посчитал поисковые системы тугодумными и решил лишний раз напомнить, чему посвящен сайт – матрасам и их продаже.

<h2>Спам</h2> — Пример переспама заголовков контента.

Подобные заголовки сильно снижают доверие посетителя к сайту и, соответственно, конверсию. Поисковые системы, также как и пользователи, любят сайты, которым можно доверять.

Обратите также внимание, что в ноябре Яндекс ввел новую формулу ранжирования для коммерческих запросов, где помимо качества контента учитывается качество транзакции, куда неотьемлемыми факторами входят интерфейс и доверие к сайту. Переоптимизация любого вида в ущерб юзабилити сильно вредит коммерческим сайтам, несмотря на то, что упомянутая выше формула ранжирования пока работает для московского региона.

Пример переспама контента

[кликните на изображение для увеличения]

Сложно представить себе, кто из читателей приведенного на скриншоте текста купит в данном магазине товары Adidas 🙂

Вложенность тегов

Помимо переспама контента ключевыми словами за переоптимизацию принимается и определенная вложенность html-тегов с целью повышения веса нужных слов на странице. Это могут быть следующие варианты:

— <strong><b>ключевое слово</b></strong>

— <em><i>ключевое слово</i></em>

— <a><em>ключевая фраза</em></a>

— <h3><b>ключ</b></h3>

Чаще всего переоптимизированность является сознательным процессом, поэтому неизбежно влечет санкции. Избегайте подобную вложенность тегов, а для применения стилей к заголовкам и ссылкам используйте CSS.

Скрытие контента

Скрытие контента от посетителей, в ряде случаев, свидетельствует о том, что он предназначен для поисоквых систем. Некоторые из приемов скрытия контента определяются поисковыми алгоритмами автоматически, другие могут стать причиной жалобы от конкурентов или найдены в результате проверки асессором, что опять же, неизбежно ведет к санкциям.

— Display: none

— Overflow: auto(scroll)

— <noscript>Спам</noscript>

— <noindex> (чрезмерное использование)

Атрибуты ALT и TITLE

В атрибутах ALT и TITLE также часто используют перечисления ключевых слов. Текст из ALT в большинстве случаев не виден посетителям, поэтому на конверсию может и не повлиять, но зато он хорошо виден поисковым системам.

Адресная строка

На примере выше повторение слова “купить” в адресной строке можно было бы посчитать за ошибку работы движка сайта, если не обратить внимание на остальной контент.

Доменное имя

Такие домены, хоть и находятся в индексе, но это дело времени, а также зависит от контента на сайте. Но некоторые из показанных доменов заранее говорят, для чего они были созданы. Будет ли у вас доверие к подобным сайтам? Расплатитесь ли вы за купленные двери кредиткой на этих ресурсах?

Переоптимизация ссылок

Ссылки также являются текстовым контентом и их переоптимизация влечет к наложению различных фильтров. Если ссылки покупаются, а позиции не растут, а иногда потихоньку снижаются, то имеет место переспам анкор-листа. Одинаковые ключевые слова со всех внешних ссылок ведут к неучету большинства из них. На внутренние ссылки сайта также следует обращать внимание, избегая перечисление ключевых слов (например, через запятую) в них.

Если сравнивать пере- и недо- оптимизацию, то при одинаково низкой их эффективности они будут отличаться возвратом инвестиций (инвестиции в данном случае это время, силы и денежные средства).

ROI = Эффективность / Затраты

При переоптимизированности сайта ROI всегда ниже, поэтому, выгодней недооптимизировать сайт, чем переоптимизировать его.

Итоги

Выявить переоптимизацию очень просто, так как она создавалась сознательно. Если же отсутствует оптимизатор, который прежде работал с сайтом, то необходимо пересмотреть тексты, ссылки и html-код. Главный фактор, указывающий на то, что сайт переоптимизирован — снижается его эффективность. Можно использовать веб-аналитику, находя на сайте низкоконверсионные страницы.

После определения переспамленных страниц уменьшите их информационную насыщенность ключевыми словами, удалите скрытые элементы, снимите купленные ссылки, модифицируйте сайт для людей.

При использовании сверх-оптимизации система теряет эффективность: затраты увеличиваются, конверсия посетителя снижается, падает доверие к сайту, а также это влечёт санкции от поисковых систем (Яндекс, Google, прежде всего).

Как только ваш бизнес будет направлен на людей, поисковые системы пересмотрят своё отношение к сайту и его эффективность значительно увеличится. Ориентируйтесь на людей, недооптимизация всегда лучше переоптимизированного сайта!

Работа инструмента Переоптимизация. Нюансы диагностики

Для диагностики наличия пост-фильтров в Яндексе используется методика сравнения релевантности продвигаемого сайта по поисковому запросу с конкурентами в выдаче. А именно:

- Определяется текущая позиция сайта по запросу в указанном регионе.

- Берётся 5 конкурентов, которые находятся выше продвигаемого сайта по запросу.

- С помощью операторов расширенно поиска происходит сравнение релевантности продвигаемого сайта с конкурентами в выдаче.

Подробней о методике проверки и самих текстовых фильтрах можно посмотреть в нашем обзорном видео и прочитать в статье по текстовым фильтрам от «Пиксель Плюс».

После внесения изменений в документ фильтр всё равно диагностируется. Почему?

Как следует из описания методики, приведенного выше, диагностика строится на базе анализа выдачи Яндекса по нужному поисковому запросу в заданном регионе. Таким образом, если вы внесли какие-либо изменения в документ, то санкции отделом антиспама Яндекса могут быть сняты только после:

- Переиндексации документа.

- Пересчёта факторов антиспама (часто, в день текстового апдейта).

- Обновления выдачи поисковой системы.

Специалисты сервиса «Пиксель Тулс» рекомендуют осуществлять проверку наличия/факта снятия пост-фильтров через несколько часов после апдейта выдачи, а также после 2-3 текстовых апдейтов после внесения изменений в документ.

Поддержка Яндекса отрицает наличие санкций, почему?

Дело в том, что служба поддержки поисковой системы уполномочена подтверждать лишь наличие хостовых санкций (применяемых для домена целиком). В новой версии панели вебмастера Яндекса, наличие санкций данного типа (хостовых) выводится во вкладке «Диагностика» → «Нарушения».

Прочие же типы санкций, такие как:

- Переоптимизация (для документа).

- Переспам (для запроса).

- Аффилирование (для группы сайтов).

- И ряд других.

Служба поддержки Яндекса не подтверждает, что не делает их наличие менее значимым для SEO-специалиста.

Какие ещё фильтры можно диагностировать инструментом?

Аналогичной методикой (с помощью инструмента) можно диагностировать:

- Наличие фильтра Переспам (по одному запросу для заданного документа).

- Включение проекта в процесс рандомизации выдачи (алгоритм Многорукого бандита / Multi-Armed Bandits).

- Прочие пост-фильтры, которые применяются к сайту или документу.

В каких случаях проверка не производится?

Проверка на наличие фильтра на документе не производится, если указанный сайт занимает в выдаче позицию выше 6 (с 1 по 5 место) и ниже 100 (с 101 и далее).

В случае нахождения запроса в ТОП-5 будет выведено сообщение об отсутствии фильтра, а в случае отсутствия документа в ТОП-100 оповещение о невозможности произвести проверку.

Проверка дала разный результат в течение дня, почему?

К сожалению, Яндекс периодически отдает разные результаты ответа на один и тот же запрос пользователя (с тем же регионом). Это может быть связано как с проведением тестирования, так и прочими факторами (между двумя проверками мог произойти апдейт, измениться пороги применения пост-фильтров и так далее, правда, это значительно менее вероятные события).

Для правильной диагностики мы настоятельно рекомендуем опираться на результаты анализа по нескольким поисковым запросам для одного документа. Это сводит вероятность ошибки к минимуму.

На документе обнаружено наличие текстового пост-фильтра, что делать?

Наличие текстового пост-фильтра на паре запрос-документ (Переспам) или целиком на документе (Переоптимизация / Новый фильтр) негативно сказывается на позициях сайта. Требуется приложить усилия для снятия фильтра. Для этого, рекомендуется скорректировать в сторону понижения ряд факторов документа, которые анализируются антиспам-отделом Яндекса.

В первую очередь, следует обратить внимание на такие факторы как:

- Длина текста.

- Число вхождений частотных слов в текст документа (не обязательно слов из продвигаемых запросов).

- Число вхождений частотных слов в исходный код документа (в том числе атрибуты alt и title тега img, meta-теги, title).

- Число и расположение заголовков и тегов акцентов: h2-h6, b, strong, em, i.

- Вхождения частотных биграмм и триграмм.

- Орфографические и пунктуационные ошибки.

- Разбивка текста на фрагменты.

Рекомендации по снятию переоптимизации

В экспертном инструменте «Расширенная проверка на переоптимизацию» — формируются рекомендации по необходимым изменениям документа в процентном, численном и общем виде. В бесплатном инструменте «Проверка на переоптимизацию» — рекомендации недоступны.

Важно учесть, что рекомендации формируются на основе анализа сохраненной копии документа в Яндексе (так называемая «сохраненка»).

Подробней с методикой, вы можете ознакомиться в презентации ниже.

Задайте вопрос или оставьте комментарий

Перейти к инструменту «Проверка на переоптимизацию»Другие вопросы нашего FAQ

Переоптимизация сайта и 13 ошибок, которые приводят к фильтру — Сосновский.ру

Привет, друзья! До недавнего времени seo-специалисты и вебмастера при продвижении сайтов старались максимально оптимизировать внутренние факторы ранжирования. В итоге в поисковой выдаче мы получили множество ресурсов с максимальной и критичной оптимизацией.

Во-первых, в таких проектах стало сложнее ориентироваться пользователям — заточенность под поисковые системы не позволяла быстро находить нужную информацию. Во-вторых, накрутка внутренних факторов начала искажать результаты поиска, вытесняя более достойные сайты.

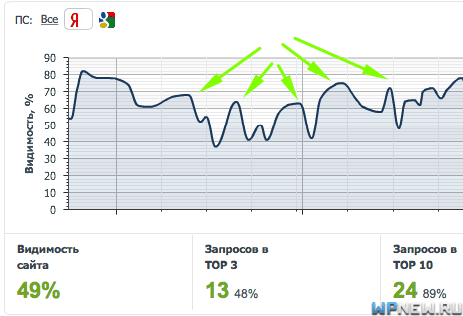

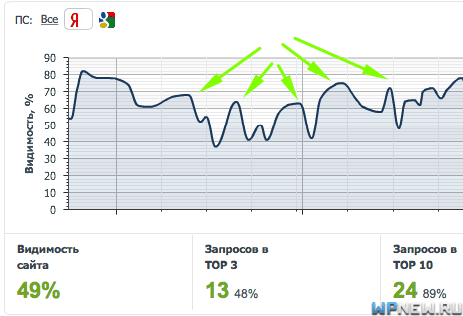

Современные поисковые алгоритмы (в частности Яндекса) с относительно недавнего времени ввели санкции за агрессивную оптимизацию, так называемый, фильтр за переоптимизацию сайта. Я не понаслышке знаком с ним: на клиентских проектах зачастую имеются те или иные переоптимизированные элементы. Данная санкция на несколько месяцев затронула и один из моих ресурсов.

Теперь все те элементы, которые способствовали росту позиций 5-7 лет назад, сейчас могут, наоборот, глубоко понизить сайт. SEO не стоит на месте, поэтому необходимо подстраиваться под современные реалии продвижения.

Некоторые моменты в переоптимизации лежат на поверхности, о некоторых вы могли даже не задумываться. Ниже я опишу все попадавшиеся мне элементы, которые могут привести к фильтру. По отдельности они могут быть безобидны, но объединившись между собой, существенно повышают переоптимизированность сайта и риск попадания под seo-санкции.

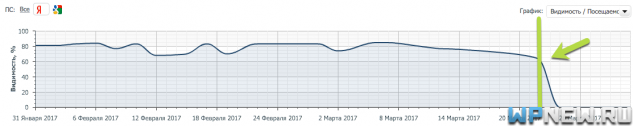

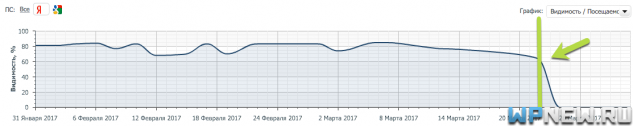

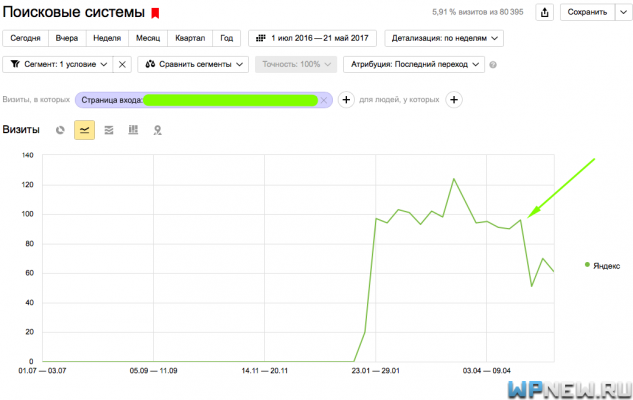

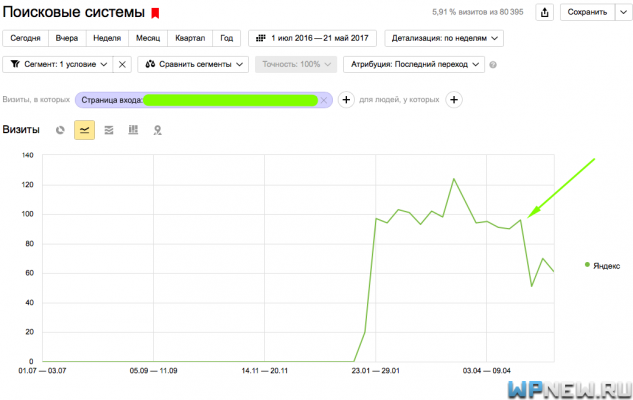

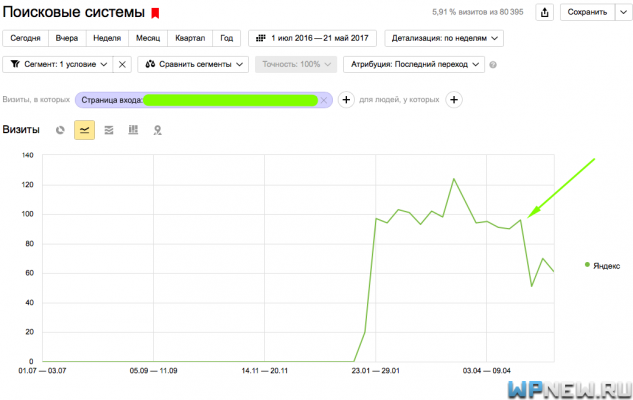

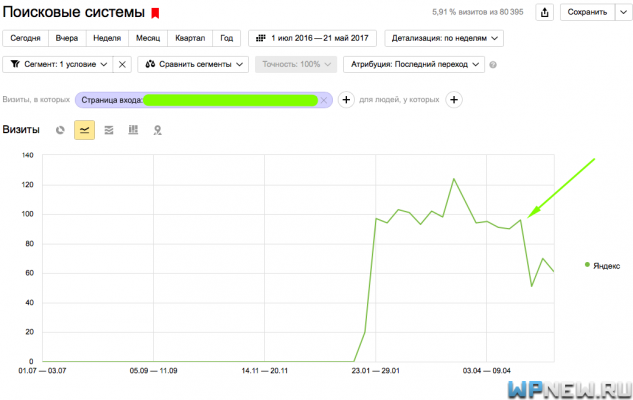

А в фильтре мало чего приятного ![]() . Вот, что случилось с трафиком с Яндекса у одного из моих ресурсов (график по месяцам).

. Вот, что случилось с трафиком с Яндекса у одного из моих ресурсов (график по месяцам).

Благо получилось восстановить бОльшую часть посещаемости за достаточно короткий период. Получать эту санкцию больше желания нет. Если у вас тоже, то придерживайтесь советов и рекомендаций, которые я опубликую в посте. Практически все они хорошо знакомы, но зачастую мало, кто ими пользуется: некоторые — из-за незнания, некоторые в силу нежелания что-то менять. А менять, как правило, нужно много ![]() . Итак, поехали.

. Итак, поехали.

1. Тег Title

Один из самых важных факторов при подсчете поисковой релевантности. В силу этого в тег стараются:

- Вписать как можно больше ключевых слов.

- Не изменять ключи, а оставлять их так, как запрашивают пользователи.

- Вставить какие-нибудь специальные символы (например, вертикальную черту «|»).

Идеальный тег title — это 1-2 лаконичные и законченные фразы/предложения (желательно до 60-70 символов), которые включают в себя несколько ключевых слов, написанных человеческим языком.

Такой title крайне неудачный. Здесь и лишний пробел (+ его отсутствие), и город без падежа, и «отзывы» в спамной конструкции.

Его лучше переделать — «Центры диетологии в Москве, отзывы пациентов». Так-то лучше ![]() .

.

2. Создание дублирующих по логике страниц

Здесь я выделяю 2 пункта:

1) Логическое дублирование страниц по запросам-синонимам — раскрутка/продвижение. Один документ оптимизируют под продвижение, а другой — под раскрутку. Если одиночные дубли ничего плохого, скорее всего, не натворят, то многочисленные логические повторения могут отразиться негативно.

2) Размножение по географической принадлежности. Например, компания, занимающаяся сервисом бытовой электроники, хочет расширить семантическое ядро и, соответственно, масштабы сайта. Ресурс из нескольких десятков страниц превращается чуть ли не в портал со следующими документами: «Ремонт компьютеров метро Теплый стан», «Ремонт холодильников станция Маяковская» (вместо станции метро можно поставить любой город, край, область и так далее). Обычно такие страницы содержат ничем не примечательный контент.

Если клиенты практикуют подобные конструкции (2-пункт), то им я предлагаю оформлять все это в виде портфолио и кейсов (Мы получили вызов на объект около станции метро такой-то. Там был поломан кондиционер такой-то, марки такой-то. Вот как мы его починили. Хотите, починим и ваш). В итоге получаем не спамное размножение страниц, а вполне полезный контент с употреблением нужных ключевых слов.

Да, подобные документы могут привлечь на проект дополнительный трафик, но чтобы его привлечение не сыграло злую шутку для остального ресурса, необходимо на подобных страницах публиковать интересный и полезный контент. Пойти по пути смекалки и выдумки, нежели спама и размножения.

3. Переспам в сквозных элементах

В основном сюда относятся:

1) Слоганы и текстовые логотипы в шапке, которые содержат в себе ключевое слово, повторяющееся на каждой странице. Вроде бы безобидная надпись, а свою лепту в общую переоптимизацию внести сможет.

2) Употребление поисковых запросов или содержащих их внутренних ссылок в подвале ресурса. По моим наблюдениям именно этот пункт мог стать главной причиной наложения фильтра в моем случае. Я понял, что содержание страниц сайта по логике подходит и другой тематике. Решил попробовать, отразится ли на посещаемости употребления главного ключа соседней ниши в футере. Как видите, отразилось ![]() . Яндекс мог подумать, что я захотел покрыть другую тематику одной строчкой в подвале. Не тут-то было.

. Яндекс мог подумать, что я захотел покрыть другую тематику одной строчкой в подвале. Не тут-то было.

3) Меню и каталоги товаров. Вернусь к сервису бытовой техники. Каталог можно оформить в виде:

Выполняем ремонт:

— Холодильников

— Кондиционеров

— Компьютеров

— и так далее.

Некоторые меню возле каждого вида техники содержат слово «ремонт». Несложно догадаться, что это плохо скажется на сайте. Похожий случай.

Итак, если слоган или текстовый логотип содержит ключевое слово, то лучше лого оформить изображением, а слоган перефразировать. Футер не должен содержать перечисление ключей и внутренних ссылок. Меню и каталоги товаров организовывать без повторения одной и той же фразы.

4. Имя файла изображения. Теги alt и title

Давным-давно к этому посту я бы скачал какое-нибудь красивое изображение (не обязательно по теме). Затем поменял бы имя файла на «pereoptimizaciya-sajta.jpg» и добавил к нему теги alt и title с содержанием «переоптимизация сайта». Теперь так делать нельзя. Изображение должно:

- В идеале быть уникальным.

- Тематичным.

- Не иметь названия файла, а также тегов alt и title, которые содержат продвигаемые ключевые слова (хотя части можно). Если, например, альт полностью дублирует основной title страницы или главный запрос («оптимизация сайта под поисковые системы»), то это плохо. Если же содержит только часть («поисковые системы», «оптимизация сайта»), то ничего страшного.

На первый взгляд, изображения не такой и важный фактор, но пренебрегать им не стоит. Мне встречалось несколько случаев, когда переспам в тегах картинок был дополнительным фактором переоптимизации или наложения фильтра.

5. Переспам выделением жирным (strong, b)

Несмотря на то, что теги strong и b различаются по своим свойствам (первый логический, а второй графический), злоупотреблять, а тем более выделять ими ключевые слова крайне не рекомендуется.

Можно сказать, что это классика в переоптимизации страниц. Тем, кто создавал контент, основываясь на трендах оптимизации 2007-2011 годов, сейчас приходится убирать выделение жирным. Выделять можно только то, на что вы хотите обратить внимание посетителя. Выделений не должно быть много.

6. Оформление контента без структуры

Современный контент не состоит только из текста, не разделенного на абзацы. Он может содержать:

- изображения;

- видео;

- отзывы;

- экспертные мнения;

- таблицы;

- маркированные и нумерованные списки;

- презентации;

- комментарии;

- цены;

- калькуляторы;

- и так далее.

Неструктурированный контент имеет больше шансов попасть под фильтр, нежели тот, который имеет множество элементов и этого списка.

7. Внутренние ссылки

Некоторые оптимизаторы хотят, чтобы их «подопытный» сайт походил на Википедию с ее огромным количеством внутренних ссылок. Признаюсь, что ранее я тоже этим «грешил» ![]() . Сравнивать ваш ресурс и главную веб-энциклопедию интернета неправильно («якобы, вон, википедИи можно, значит можно и мне») — не те весовые категории. Иначе говоря, wikipedia.org — 7-й сайт в интернете, а к вашему не будет столько доверия.

. Сравнивать ваш ресурс и главную веб-энциклопедию интернета неправильно («якобы, вон, википедИи можно, значит можно и мне») — не те весовые категории. Иначе говоря, wikipedia.org — 7-й сайт в интернете, а к вашему не будет столько доверия.

Количество внутренних ссылок должно быть таким, чтобы лаконично вписываться в объем материала. В большом количестве «внутряков» тяжело ориентироваться посетителю, а поисковые алгоритмы могут посчитать такое злоупотребление желанием искусственно повлиять на ранжирование. Главный критерий — уместность и полезность. Вставляйте такие линки, чтобы у пользователя появилось желание кликнуть на них, чтобы они глубже раскрывали основную тему или знакомили с ее ответвлениями.

1 ссылка на 1000-2000 символов — этого будет достаточно. Здесь я имею в виду информационные документы и не касаюсь индивидуальных особенностей ресурсов. Также не стоит забывать, что анкоры ссылок должны быть разнообразными, неспамными, а сами линки отправлять посетителей на различные материалы.

8. Переспам текста ключевыми словами

Зачастую даже контент, который создавался без каких-либо ориентиров на поисковые запросы, стоит проверять на переспам. Как правило, текст может быть перенасыщен словами из title, h2 (если, конечно, вы оптимизировали данные теги), а также индивидуальными фразами и выражениями, которые присущи либо авторам, либо тематикам.

Здесь получается 9 предложений и 9 раз употребляется слово «отруби». Это главный запрос материала, поэтому переоптимизация налицо.

Чтобы определить переспам ключами я обычно открываю страницу в браузере, вывожу поиск по ней (ctrl+F) и ввожу первые буквы слов из title. Они наглядно выделяются. Сразу становится понятно, что к чему.

Все любят какие-то точные цифры, поэтому предложу вам свою идеальную формулу: 1 ключ = 1 абзац. Сколько абзацев в материале, столько раз можно употребить какое-нибудь слово. Но это, конечно, не панацея, а примерный ориентир. Все очень индивидуально.

Чтобы не плодить пункты, в этот также включу употребление в тексте продвигаемых ключей в неестественной морфологии (пункт 2 первого подзаголовка) чисто для поисковых систем. Чтобы уменьшить переспам, слова можно заменять на синонимы, местоимения и перефразировать предложения. Употреблять их необходимо в человеческой форме и в корректном склонении.

9. Контент без смысловой нагрузки

Если вы заинтересовались темой переоптимизации сайта, то, скорее всего, вам это было нужно. Возможно, какой-то из ваших веб-ресурсов получил фильтр за излишнюю оптимизацию, и теперь вы ищите подобную информацию. Может быть, вы просто первый раз увидели незнакомое слово «переоптимизированность» и решили посмотреть, что оно означает.

Вот примерно такой текст можно считать контентом без смысловой нагрузки или seo-водой. Если бы он не содержал ключевые слова, то это была бы половина беды (просто бесполезные строки). Бессмысленный контент же имеет вхождения поисковых запросов, поэтому может стать звоночком или дополнительным фактором для наложения фильтра.

10. Многочисленные теги для одного элемента

Как вам подзаголовок? А хотите посмотреть его код?

<h4>

<span>

<em>

<strong>

10. Многочисленные теги для одного элемента

</strong>

</em>

</span>

</h4>

Вы можете подумать, что это вымысел, но будете ошибаться. Некоторые продвиженцы доходят до фанатизма: подзаголовки (и/или другие элементы), которые к тому же состоят или включают в себя ключевые слова, обрамляют всевозможными тегами (еще ссылки не хватает ![]() ). Некоторые могут делать это не специально, желая просто красиво выделить подзаголовок.

). Некоторые могут делать это не специально, желая просто красиво выделить подзаголовок.

Подзаголовки и поисковые запросы в тексте таким образом выделять не стоит. Всю красоту (выделение жирным, зеленый цвет, наклон) выводить в style.css, а логические теги типа strong — удалять.

11. Description и keywords

Еще со школьной скамьи с основ поисковой оптимизации всем известны эти мета-теги. Принято считать, что description и keywords не влияют на ранжирование. На страницах хелпа Яндекса есть следующая запись:

<meta name=»Keywords» content=»…»/> — может учитываться при определении соответствия страницы поисковым запросам;

Польза description заключается в возможности показа содержания тега в сниппете поисковой выдачи как Яндекса (реже), так и Google (чаще). Keywords возможно, вероятно, может быть учитывается только отечественным поисковиком. Другими словами, их влияния сейчас практически нет.

Несмотря на все выше перечисленное, есть мнение, что спамные конструкции в этих тегах также могут стать одним из элементов переоптимизации на сайте. Признаюсь, я заполняю и description, и keywords ![]() .

.

Не то, чтобы я уделяю данным тегам большое внимание. Это либо просто привычка, либо желание максимально представить опубликованную страницу.

На мой взгляд, есть вероятность того, что если переоптимизировать description и/или keywords, то это может незначительно, но сказаться на общей переоптимизации страницы/сайта. Если и заполняете данные теги, то делайте это качественно:

- description — описание документа (оптимально 160-170 символов), с вхождением основного ключа (можно несколько, но гармонично). Не содержит простое перечисление запросов. Желательно не кусок из готового контента, а уникальный текст.

- keywords — перечисление 2-4 разных ключевых слов, характеризующих продвигаемую страницу («переоптимизация сайта, фильтр за переоптимизированность, ошибки оптимизации»). Не стоит вписывать сюда несколько фраз, которые отличаются только одним словом.

12. Подзаголовки

Подзаголовки тоже являются популярным элементом, которым злоупотребляют при оптимизации. Сюда стараются добавить ключевые слова зачастую небрежным образом. Недавно попадались такие подзаголовки, в которых повторялся один и тот же ключ:

- Куда поехать на Крит

- ||-||-|| с ребенком

- ||-||-|| на машине

- ||-||-|| в первый раз

- ||-||-|| молодежи

Явный переспам (причем первый дублирует h2). При составлении подзаголовков необходимо соблюдать следующие правила:

- Разумное количество: не больше 1 на 1000-1500 символов.

- Отсутствие переспама ключевыми словами и спамными конструкциями. Одно и то же слово используется не чаще, чем в 30% подзаголовков. Конечно, если у вас 2 подзаголовка, то можно использовать и чаще

.

. - Соблюдение логической вложенности: h3 «старше» h4 и так далее.

- Лаконичные, информативные, тематичные фразы, иногда содержащие продвигаемые поисковые запросы или их части в разных формах.

- Отсутствие повторения h2.

13. Совпадение title, h2, URL и хлебных крошек

Я не случайно объединил все эти пункты в один. Например, в моем любимом wordpress, если на сайте установлены хлебные крошки и плагин автоматического транслита URL, то вы и глазом не моргнете, как везде пропишется название поста. А если оно состоит из одного только запроса, то «пиши пропало» ![]() . Получается, что ключевое слово появляется сразу во многих важных элементах, которые влияют на ранжирование документа. Это мощный звонок для поискового алгоритма. Но несложно это предотвратить. Достаточно, чтобы с тегом Title не совпадал:

. Получается, что ключевое слово появляется сразу во многих важных элементах, которые влияют на ранжирование документа. Это мощный звонок для поискового алгоритма. Но несложно это предотвратить. Достаточно, чтобы с тегом Title не совпадал:

- URL. Сейчас он также является одним из факторов релевантности, но, на мой взгляд, утратил былую силу. Сюда не обязательно добавлять все ключевые слова страницы. Хватит и короткой характеризующей документ фразы, например, «pereoptimizaciya-sajta».

- Заголовок h2. Помимо того, что разное содержание этих тегов может иметь вхождения разных запросов (что несомненно плюс), данный факт уменьшает переоптимизированность страницы. h2 может быть как лаконичным и коротким (например, для интернет-магазинов «Телевизоры Samsung»), так и развернутым и привлекательным (например, как заголовок к этому посту).

- Хлебные крошки. Сам по себе данный элемент безвреден, но в комплексе с остальными может увеличить риск наложения фильтра. В последнее время вместо употребления дублирующего заголовка (названия поста) я использую фразу «Вы здесь», «Вы тут», «Ваше место» и так далее. Главная задача хлебных крошек — ориентация посетителя. Данная конструкция прекрасно выполняет эту роль.

В общем, не пытайтесь вставить ключевые слова везде, где это возможно. Создавайте интересный и структурированный контент, который легко читать. Процент ключей на странице — пережиток прошлого. Соблюдая правила, описанные в посте, сможете быть уверенными, что ваш сайт надежно защищен от фильтра за переоптимизацию.

Если вы знаете дополнительные элементы, которые влияют на наложение санкции, то поделитесь ими в комментариях. Жду ваши мысли, вопросы и отзывы ![]() !

!

Переоптимизация сайта — блог NEWMARK

Время прочтения 21 минута

Навигация по статье

Что такое переоптимизация сайта

Переоптимизация сайта – серьезное препятствие для продвижения ресурса и работы SEO-специалиста. Если уже какое-то время существующий сайт внезапно проседает в выдаче или же молодой ресурс упорно не продвигается вверх, возможно, он попал под фильтр в связи с этой проблемой.

Итак, что мы знаем о «правильном» продвижении — оптимизации сайта? (в рамках ПС)

Оптимизация сайта — это комплекс мер и усилий, результатом которого является повышение ранжирования ресурса в поисковых системах и увеличение трафика.

Если что-то пошло не так, можно столкнуться с двумя проблемами:

- Недооптимизацией (ее мы рассматривать не будем, никаких фильтров за нее сайт не получит).

- Переоптимизацией ресурса и санкциями от ПС.

В рамках этой статьи нас интересует последнее. Таким образом:

Переоптимизация — это превышение допустимых границ при продвижении проекта, которое дает противоположенный ожидаемому результат.

Виды переоптимизации и как ее избежать

В мета-тегах

Спамные title и description встречаются довольно-таки редко, но их все еще можно найти. Главный признак переоптимизации в meta – у вас начинают болеть глаза от количества одинаковых слов в маленьком тексте сниппета или вовсе получается бессмыслица.

Плохой пример заполнения тегов мета:

В случае выше страдает мета-тег «описание», оно составлено неудачно.

Теперь посмотрим, как может выглядеть хороший сниппет:

Скажем прямо, нужно очень «постараться», чтобы попасть под фильтр из-за метатегов, ибо в некоторых случаях даже в высококонкурентных тематиках очень хорошо продвигаются сайты с 2 вхождениями одного и того же ключа в title или в description.

Если вы хотите узнать примерный (!) количественный ответ на вопрос «сколько раз можно использовать основной интент в метатегах», то — до 2-3 раз.

Но лучше обратить внимание на конкурентов в вашей нише.

Несколько лет назад была актуальной тема переоптимизации meta keywords, но сейчас этот тег не приоритетен и его не обязательно использовать. Гугл официально отказались от учета keywords при ранжировании, а вот Яндекс — нет (подробнее).

Выделим общие принципы заполнения Кейвордс:

- пишите только те запросы, которые продвигаются на этой странице, соблюдайте релевантность.

- количество запросов — 1-5.

- использование повторяющихся фраз в разных словоформах

Текстовая переоптимизация.

Заголовки h2-h6

Перейдем к внутренней части страницы. Очень часто переоптимизацию можно встретить в текстах о какой-либо категории товара, в которую стремятся поставить все ключи во всех словоформах, и не по одному разу.

Самый важный заголовок страницы – h2. Не стоит его делать идентичными тегу Title. В нем может содержаться ключ в разбавленном виде либо более низкочастотный ключ с «хвостом».

Остальные заголовки должны выглядеть естественно для человека, неправильно делать заголовки с одним и тем же содержимым.

Как не надо делать:

Текст

Можно переоптимизировать текст либо слишком часто используя ключевые фразы, либо ставя излишние теги:

— заголовки, где они объективно не нужны, или ставя несколько h2;

— теги с семантической окраской – strong и другие;

— теги, визуально выделяющие текст, без семантической окраски – I, b и т.д.

Либо можно сочетать оба эти подхода.

Пример переоптимизированного текста:

Пример текста «без перебора»:

По количеству вхождений интента в текст сложно дать конкретные рекомендации. Кто-то может посоветовать два вхождения в абзац, кто-то 1 на статью до 2 к символов. На наш взгляд, существует определенный диапазон – и в него нужно вписать свой ресурс, чтобы он не был ПЕРЕ и НЕДО оптимизированным.

Чтобы узнать примерный диапазон плотности ключей своей ниши, вы можете вручную проанализировать тексты конкурентов по наиболее важным запросам либо воспользоваться профессиональными сео инструментами сео-оптимизатора, например, Серпстат, Ahrefs и др.

Сервисы для бесплатной проверки текста на плотность Ключевых Фраз:

1. МираТекст — https://miratext.ru/seo_analiz_text

Здесь вы получите не только результаты в цифрах но и рекомендации по улучшению статьи, например, уменьшить количество тех или иных ключевых фраз.

2. Сервис от Текст.ру — https://text.ru/seo/unauthorized

В результате проверки вы получите список КФ на странице, разбитых по группам и по частоте. В каждую группу слов можно зайти, нажав на «+», и посмотреть из каких словосочетаний она состоит.

3. Адвего — SEO-анализ текста — https://advego.com/text/seo/

После проверки по Адвего, вам тоже дадут рекомендации по уменьшению количества тех или иных слов, если их избыточно много.

Другие рекомендации

Не размещайте:

— скрытый текст.

— невидимый текст, например в блоке со свойством display:none.

Внешняя переоптимизация.

Закупка некачественных ссылок может привести к печальным последствиям.

При выборе площадки для размещения наибольшее значение имеет:

- Качество сайта-донора.

Сайт-донор должен быть незаспамленный (как по количеству ссылок так и по отношению входящих к исходящим), с нормальными показателями ТИЦ (без резкого падения) и качественным внешним обликом. - Тематичность

Не берите ссылки от сайта про автомобили, если вам нужно продавать крем для обуви. Тематика сайта реципиента — вашего — должна быть близкой к донору, иначе ПС увидят неестественность ссылки. - Гео

Здесь все понятно, выбирайте площадки своей географической зоны, в зависимости от области вашего продвижения – страна, город, города.

И также, добавим, что не стоит переспамливать анкорными текстами ссылок. Например 20 раз подряд брать ссылки «купить пылесосы в москве». Чередуйте анкорные и безанкорные варианты.

Текстовые фильтры от Яндекс : «Новый» , Переспам , Переоптимизация.

Исторически первым появился «Переспам» — 2010 год, спустя год – «Переоптимизация» и уже в 2014 – «Новый» или «Севальневский» фильтр.

Важно отметить, что несмотря на общую цель — борьбу с переоптимизацией и SEO-текстами, эти алгоритмы имеют разную логику и последствия.

Как определить, какой текстовый фильтр на вашем ресурсе? — Используйте сервис для проверки онлайн или попробуйте узнать это с помощью таблицы:

| Это Переспам | Это Переоптимизация | Это «Новый» |

|---|---|---|

|

Резко просел один продвигаемый запрос (часто более конкурентный) на 15-35 позиций. Возможно, произошла смена релевантной страницы в выдаче, но старая страница по-прежнему находится в индексе. |

Резко просела вся группа поисковых запросов, продвигаемых на один документ. Падение составило от 5 до 20 пунктов. По ряду запросов, могла смениться наиболее релевантная страница в выдаче, но сама страница находится в индексе. |

Страницы сайтов независимо от тематики начинают терять позиции сотнями – вплоть до абсолютного исчезновения из поисковой выдачи. |

|

Позиция сайта резко улучшается при небольшой модификации продвигаемого запроса: с базового [продвижение сайтов самостоятельно] на [продвижение сайта самостоятельно] или на [сайтов продвижение самостоятельно]. |

Позиции продвигаемого сайта не сильно изменяются при модификации запросов (скажем, изменении окончания), которые ведут на один и тот же документ. |

Проседание обычно происходит не постранично, а кластерами (группами страниц). Хотя может случиться и такое, что пострадает всего одна страница. Изменения падежей ничего не дают. |

|

Документ был и продолжает оставаться на приемлемых позициях по некоторым запросам, ведущим на него. На него продолжает поступать нормальный трафик из выдачи Яндекса, но позиция по основному запросу существенно ухудшилась в один текстовый АП. |

Документ существенно потерял во входящем на него трафике. Просел вниз первой или на 2-3 страницу выдачи из ТОП-10 (в зависимости от начальной позиции). |

Документ выпал из поисковой выдачи, может находиться за топ-100. |

Как видим, самые тяжелые последствия дает «Новый».

Как проверить сайт на переоптимизацию онлайн.

В этом вам помогут следующие сервисы:

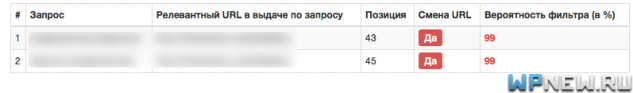

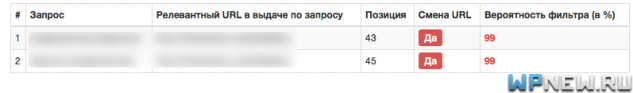

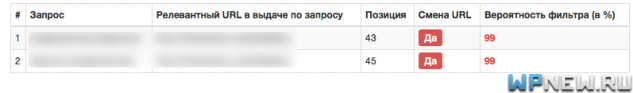

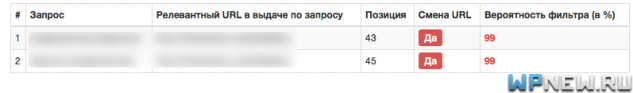

1. На сегодня самый известный SEO-инструмент для выявления этой проблемы — https://arsenkin.ru/tools/filter/ . Выполняет проверку сразу на несколько фильтров от Яндекс: Переспам, Переоптимизация и Новый фильтр. В специальное поле вы можете ввести до 10 фраз. После проверки вы увидите такую таблицу:

Сервис удобен, позволяет легко зарегистрироваться с помощью почты или через социальные сети/Гугл. Для бесплатного использования выбирайте подписку FREE — до 100 проверок в день в поисковой системе Яндекс.

Есть и другие полезные фишки.

2. Еще один популярный инструмент для онлайн-проверки сайта на переоптимизацию — http://coolakov.ru/tools/new_filter/. Он не показывает проценты вероятности наложения фильтра, а показывает результат в виде «Да» или «Нет». Также сервис выдает «вероятную позицию» в ТОПе проверяемого ресурса – при условии, что фильтр будет снят. Можно проверять до 10 словосочетаний за раз. В отличие от других инструментов, не требуется регистрация.

3. Инструмент от Пиксель Плюс — https://tools.pixelplus.ru/tools/reoptimization. Для бесплатной версии доступно до 250 проверок за день, но можно вводить только по одной фразе за раз, а не по 10, как в предыдущих сервисах. Если сайта нет в топ 100, выдает ошибку и результаты невозможно увидеть.

Результат анализа – процентная вероятность наличия санкций на странице.

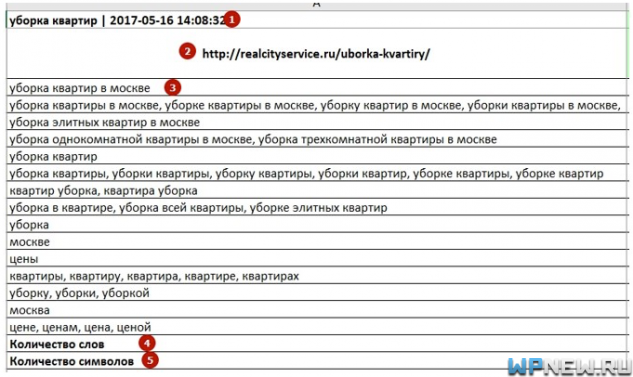

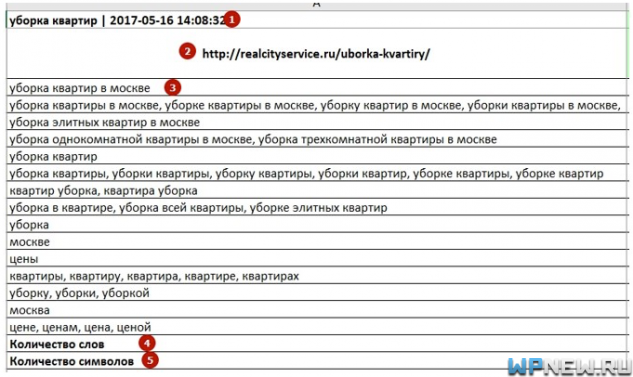

Платная проверка на этом же сервисе — https://tools.pixelplus.ru/tools/reoptimization-advanced дает рекомендации такого вида:

Подводя итог, скажем, что полезно, в случае сомнений использовать все три инструмента и если данные у двух или трех сходятся – наверное это истина.

Обратите внимание, что и после исправления текстов и т.д. фильтр еще будет «прощупываться» поскольку санкции снимаются после:

- Переобхода документа;

- Текстового апдейта Яндекс;

- Обновления SERP — выдачи;

Чем грозит переоптимизация сайта и как ее избежать

Переоптимизация сайта – чем она опасна и как с ней бороться

Прежде чем рассказать Вам, как определить, что сайт переоптимизирован, давайте убедимся в хотя бы примерно одинаковом понимании исходного понятия оптимизации.

Если говорить в общем, то – это модификация какой-либо системы с целью соответствия определенным требованиям.

Если же сузить тему до поискового продвижения, то Вас в первую очередь должно интересовать, как оптимизировать сайт – то есть, какие внести в него изменения, чтобы удовлетворить основные требования поисковиков и попасть в ТОП выдачи.

Вот на этом этапе обычно и совершаются ошибки, из-за которых поисковые системы не дают возможности продвинуться высоко, если сайт переоптимизирован.

В любой сфере переоптимизация – это превышение допустимой меры.

В SEO это означает перенасыщение содержимого веб-сайта элементами, на которые обращают внимание поисковики при ранжировании результатов выдачи.

В этой статье мы подробно рассмотрим как неумелая внутренняя оптимизация сайта может стать на пути его продвижения.

Почему не всем удается правильно оптимизировать сайт

В большинстве случаев, если кто-то жалуется на проблемы с ухудшением позиций в поисковой выдаче, проводя анализ сайта на переоптимизацию, можно выяснить, что его продвижение состоит в основном из имитации релевантности – чем больше ключевых слов, тем (по мнению горе-оптимизаторов) страница будет релевантнее и тем быстрее поисковик поднимет ее в ТОП.

На самом деле это совершенно неправильный подход.

Если лет 10 назад переоптимизация сайта еще срабатывала, то сейчас, в эру сверхумных алгоритмов поисковых систем, таким образом можно только навредить своему веб-ресурсу.

Проследите сами логическую цепочку – переспам ключевиками означает ухудшение читабельности текстов и снижение полезности для посетителей. Это приводит к ухудшению поведенческих факторов и уменьшению количества полезного трафика. Как следствие – значительное ухудшение конверсии и падение позиций в поисковиках.

Кстати, переспам и переоптимизация сайта часто используются как взаимозаменяемые понятия, но это не одно и то же. Переспам является всего лишь одной из многих разновидностей переоптимизации сайта, о которых мы сейчас подробно расскажем.

Основные признаки того, что сайт переоптимизирован

Проводя анализ сайта на переоптимизацию, нужно помнить, что довольно часто, кроме заспамленного текста (об этом читайте в материале «Оптимизация текста») проблемой также являются:

- Переоптимизированный title. Является одним из признаков неумелых попыток манипулирования процессом ранжирования. Чтобы заполнить title действительно нужно использовать ключевой запрос, но лишь основной и всего один раз.

- Переоптимизация мета тегов. Часто, пытаясь повлиять на отображаемый в результатах поиска сниппет сайта, в мета теге description прописываются все возможные ключи. Но, кроме того, что поисковики в таких случаях выбирают описание страничек из текстового содержимого, это также дает им понять, что Вы являетесь нарушителем правил и какие у Вас цели.

- Переоптимизация заголовков. Основной заголовок страницы сайта (h2) не должен содержать больше одного ключа, который, к слову, употребляется в разбавленном виде. В остальных подзаголовках лучше использовать второстепенные ключевики.

- Переоптимизация url также не принесет ничего хорошего, так как у Google, например, есть алгоритм EMD, которым понижает позиции страниц за адреса с чрезмерным употреблением ключевых запросов.

- Переоптимизация футера. Обычно футер (блок внизу веб-сайта) используется для предоставления пользователям информации о владельце веб-ресурса, контактной информации, годы существования.

Иногда в нем размещают ссылки. Если их присутствие обоснованно (например, для улучшения навигации по веб-сайту), все хорошо. Но если наблюдается переизбыток ссылок с явно неуместными анкорами, это говорит о неумелой попытке заработать на продаже сквозных ссылок в футере и жестоко наказывается при выявлении.

- Переоптимизация ссылок может наблюдаться при неправильно организованной перелинковке внутри веб-ресурса. Например, на каждой страничке размещается по 100 и более ссылок (через каждые несколько слов). Это явление крайне нежелательно, поскольку также будет означать, что сайт переоптимизирован.

Какими могут быть последствия переоптимизации сайта

Кроме вполне логичного частичного падения позиций по некоторым запросам, существует большая вероятность, что если сайт переоптимизирован, на него будут наложены фильтры поисковых систем.

Например, фильтр Яндекса за переоптимизацию сайта «Ты спамный» – понижает позиции (от 30 пунктов и больше) по ключевым запросам, которыми перенасыщен веб-ресурс. Если сайт переоптимизирован и был в этом уличен с последующим наложением санкций, для их отмены нужно переработать тексты, в частности, на предмет снижения частоты ключевых слов.

Также довольно легко схлопотать фильтр Google за переоптимизацию – «Панда», для которого важнейшим сигналом является заспамленность текстов ключевиками, а потом уже и другие признаки переоптимизации сайта и некачественности контента (например, дублирование).

Выбираться из-под него можно довольно долго. Лишь полное устранение причин, по которым он был наложен, и ведение вежливой переписки с техподдержкой Google помогут исправить сложившуюся ситуацию.

Лучший вариант – не допускать, чтобы сайт был переоптимизирован

Если Вы заранее знаете, как оптимизировать сайт, это поможет избежать неприятного знакомства с фильтрами поисковых систем.

Разобравшись со всеми причинами, по которым случается переоптимизация сайта, у Вас появится возможность не только определять момент, когда сайт уже переоптимизирован, но и, что еще важнее, предупреждать возникновение подобных ситуаций.

Если по итогу ознакомления с материалом у Вас появились вопросы, давайте начнем беседу в блоке комментариев!

как избавиться и вернуть трафик

Привет! На прошлом уроке я рассказал вам, как выявить и проверить переспам и переоптимизацию страниц на сайте. В этом же уроке продолжим, расскажу, что нужно делать со всем этим и как бороться.

Как избавиться от переоптимизации страниц сайта

Вот типичная картина переоптимизированности страницы:

Забегая вперед, хочу сказать, что это резкое падение страницы связано с внедрением алгоритма “Баден-Баден”. Про алгоритм Яндекса “Баден-Баден” мы еще поговорим в ближайшем уроке, но по сути “Баден-Баден” был внедрен для борьбы с переоптимизацией.

Если посмотреть, позиции, то ярко выражено резкое падение (обращайте внимание только на позиции по Яндексу):

Невооруженным глазом можно наблюдать резкий обвал всех запросов на странице . И тут, я полагаю, всем понятно, что Яндексу явно что-то перестало нравиться и это надо исправлять, чтобы снова попасть в ТОП.

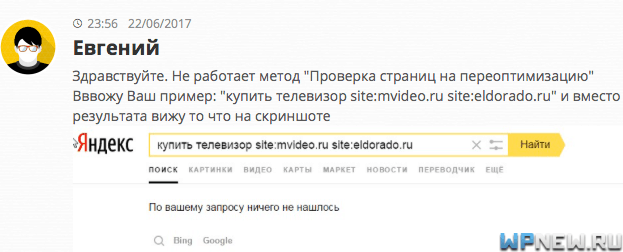

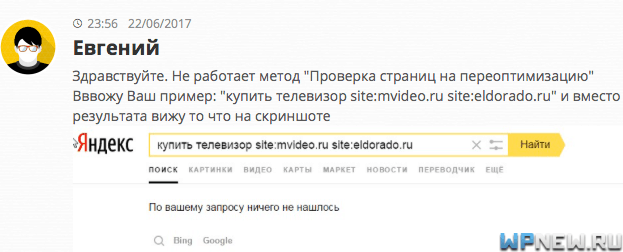

К сожалению, в данном случае Пиксель Тулс (напомню, на прошлом уроке мы искали подобные страницы с помощью данного инструмента) показал, что на странице нет переоптимизации. Попробовал вручную с помощью операторов site посмотреть, что выдаст Яндекс, в итоге ничего. Тоже самое уже отметили в комментариях к прошлой статье:

Стоило мне написать прошлый урок, как Яндекс сразу же убрал возможность проверить переоптимизацию таким способом. Возможно “Яндексоиды” читают мой блог? xD

По ходу Пиксель Тулс тоже делал выводы о переоптимизации с помощью данного операторов, потому что эта страница тоже никак не отображается переоптмизированной.

Вообще, если переоптимизация обнаружена Pixel Tools в экспертной функции, то сервис еще даст рекомендации что делать, что-то в этом роде:

![]()

![]()

Но, к сожалению, в данном случае Пиксель Тулс отобразил страницу так, как будто на ней нет переоптимизации и поэтому список правок не получил. Чуть ниже я показал, как можно другими способами найти то, что стоит подправить.

Вот еще очень хороший сервис проверки на переоптимизацию от Arsenkin (бесплатно), вот он показал, что вероятность фильтра 99%, а это уже намного ближе к правде. 🙂

Жаль только вот рекомендации не дает по корректировке страниц.

Как избавиться от переспама в запросах

Вот, например, в съемщике позиций я четко вижу, как у меня просел запрос. Причем остальные запросы этой страницы находятся в ТОПе.

После того, как нашли переспамленный запрос, нужно понять что с ним делать. Конечно, можно на глаз изучить страницу и постараться понять, что не так с запросом и где находится переспам (а иногда и “недоспам”). Но это не всегда легко заметить (я исключаю явные случаи, когда ключи чуть ли не в каждом предложении).

Например, был случай: как-то создавалась страница по низкоконкурентному запросу. Статья была лучшая в рунете на момент публикации по всем параметрам, но по истечении месяца основной запрос так и не попал даже в ТОП-100. Конечно, это насторожило, изучая страницу, показалось что все-таки много выделений было жирным (хотя жирным ключевые слова не выделяли, а просто фразы по смыслу и для удобства в визуальном восприятии). Была переоптимизация.

Просто убрали эти выделения жирным, и вуаля, через пару недель страница залетела на 7-ую позицию по основному запросу, а после прочно закрепилась в ТОП-3 надолго (за счет поведенческих факторов), даже когда конкуренция по запросу сильно выросла. Вообще, я рекомендую не делать много всяких выделений в тексте, даже если это не ключевые слова. Если прям очень надо, лучше обойтись CSS, без излишнего использования тегов strong, i и др.

Но, к сожалению, не всегда на глаз удается найти проблему на странице. Для дополнительной помощи можно воспользоваться сторонними сервисами.

К примеру, можно воспользоваться сервисом Seolib.

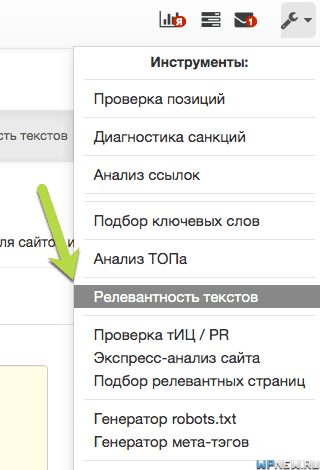

- Во вкладке “Инструменты” находим раздел “Релевантность текстов”:

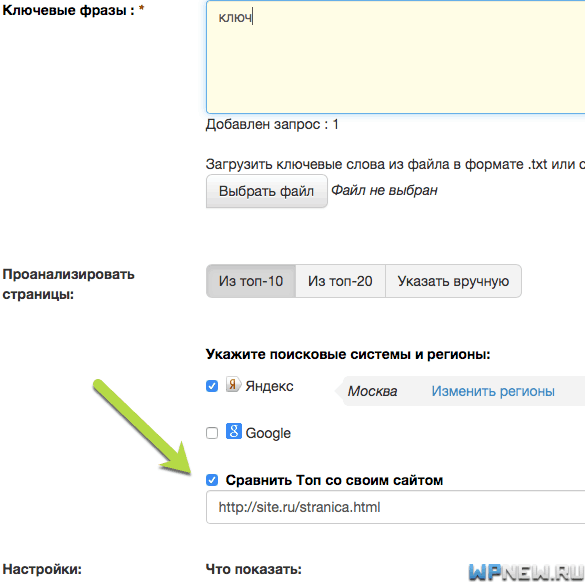

- Вбиваем ключевое слово и обязательно ставим галочку напротив “Сравнить ТОП со своим сайтом”, указываем наш целевой URL:

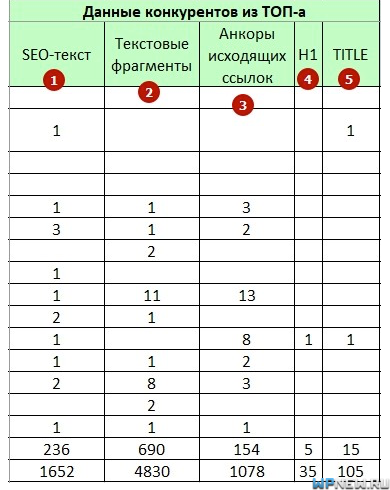

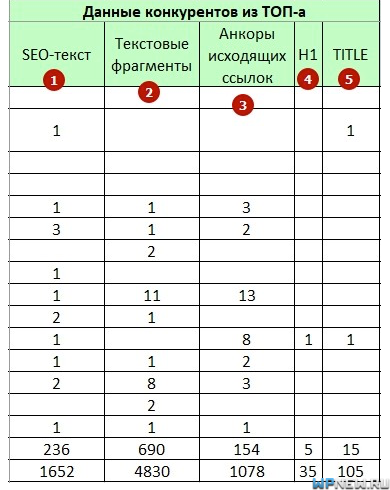

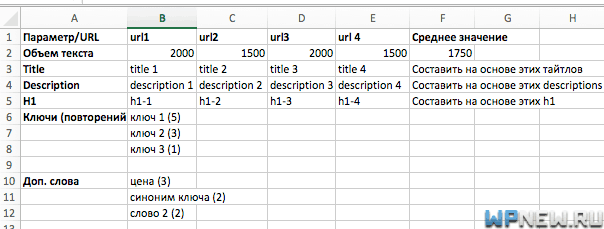

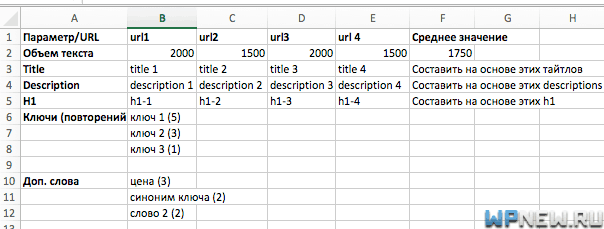

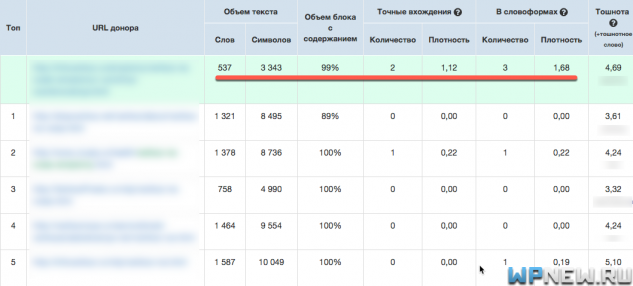

- На выходе мы получаем таблицу в виде сравнение ТОПовых страниц с нашими, вот что получилось:

- Обратите внимание на подчеркнутое красным. Видно, что по контенту у нас объем текста маловат, я бы добавил текста побольше. Количество точных вхождений запроса – слишком много, да и количество вхождений в словоформах (ключевые слова в разных падежах) – аналогично, перебор. Мы, по сути получили список рекомендаций того, что нужно сделать со страницей, чтобы избавиться от переспама. Там же отображаются наши “переборы”/”недоборы” по ключам в Title, Description, заголовках h и др.

Помимо SEOlib есть еще очень много других инструменты, например текстовой анализатор от Just Magic. Очень качественный с технической точки зрения, но вот “человечности” сервису явно не хватает. Чтобы пользоваться данным сервисом вам нужно будет не один раз прочитать документацию, причем очень внимательно. На выходе получите, что-то вроде этого:

Также, подобное есть и в Rush Analytics (про кластеризацию запросов с помощью Rush Analytics я уже рассказывал). Вот полная инструкция, как пользоваться текстовым анализатором. На выходе получится файл, но уже более понятный простому “смертному” 🙂 :

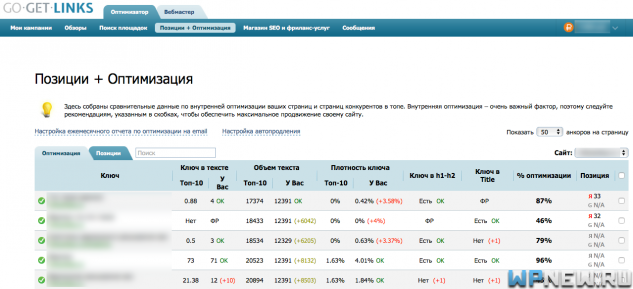

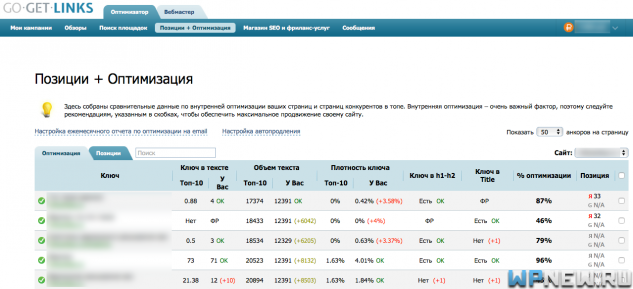

Помимо этих сервисов, есть еще функционал в GoGetLinks, который мне тоже нравится. Выглядит он таким образом:

Поиск причин переоптимизации вручную

Если же вдруг у вас нет возможности/желания пользоваться подобными сервисами или хотите получить более точные данные, можно все это дело сделать вручную (данный ручной метод мы до сих пор применяем для очень важных запросов). Алгоритм следующий:

- Берем наш самый основной запрос, вбиваем его в нашем регионе в браузере в режиме инкогнито.

- Выписываем ТОП-10 URL в таблицу.

- Берем тексты с этих сайтов, прогоняем их с помощью SEO анализа текстов в Адвего.

- “Выдергиваем” метатеги и заголовки h2 у сайтов, обязательно обращаем внимание на количество повторений ключевых слов, наличия точного/разбавленного вхождения, длину.

- Заполняем следующие данные в таблицу: объем контента, какие фразы встречаются чаще (берем во внимание не только основные ключи, но и дополнительные, расширяющие семантику статьи), количество повторений.

- Если у вас интернет-магазин, рекомендую еще обязательно обращать внимание на то, как выводятся список товаров на страницах “листингах” (категории, метки и пр.), какие ключи используются в них, сколько товаров выводятся и т.д.

- Найти средние значения. Причем, если в таблице из 10 url будут пара страниц, которые сильно выбиваются из средних значений других сайтов, то такие урлы лучше исключить из анализа сильноискаженного параметра.

Получится что-то вроде этого:

Заключение

Вы должны понимать, что если бы мы не мониторили позиции, то с такой легкостью не нашли бы переспам и переоптимизацию. Мы просто потеряли бы трафик, который конвертируется в деньги. Поэтому, я настоятельно рекомендую регулярно производить съем позиций сайта.

Текстовые анализаторы хороши, но не стоит слепо все делать по их указаниям. Их стоит рассматривать как дополнительный инструмент, который дает подсказку. Заморачиваться, чтобы все на 100% было как в их рекомендациях – не стоит. Пробовали, экспериментировали. Куча потраченного времени и денег, от обычных SEO-оптимизированных текстов разницы в позициях нет. И помните, что сайты в ТОПе постоянно меняются.

Ну вот и все. Вы делаете необходимые правки, которые требуются для того, чтобы убрать переспам и/или переоптимизацию и молитесь ждете изменений. Как правильно и когда лучше оценить изменения на сайте/страницах я расскажу уже в одном из самых ближайших уроков. Оставайтесь на связи! 🙂

Как выявить и проверить переспам и переоптимизацию страниц сайта

Привет! Часто все мы сталкиваемся с ситуацией, когда какие-то конкретные страницы ну никак не хотят залезать в ТОП. К примеру, видимость сайта в целом хорошая, но определенные запросы или страницы постоянно “болтаются” где-то внизу. Я не говорю про случаи, когда весь сайт без трафика и позиций, об этой ситуации мы еще поговорим отдельно в ближайшем уроке. Ну и конечно откинем тот случай, когда контент – неуникальный.

Страница может быть слабо оптимизированной, в результате чего не попасть в ТОП, что делать в этом случае я уже говорил: вот урок про оптимизацию страниц в видеоформате, а вот урок в виде текста про SEO оптимизацию страниц. Но помимо “недооптимизации” может быть и переоптимизация.

Пессимизированными могут быть:

- конкретный запрос на странице – это переспам;

- вся страница целиком – это переоптимизация.

В первом случае проседает только конкретный запрос, и он обычно понижаются примерно на 20 позиций. Во втором вся группа запросов, то есть падает трафик на всей странице. Про переоптимизацию всего сайта мы еще поговорим совсем скоро, сегодня я хочу разобрать пессимизированные конкретные URL/запросы.

Как найти пессимизацию страниц/запросов на сайте

Конечно, можно попробовать на глаз определить переоптимизрованные страницы, но, к сожалению, это не всегда получается. Я сам несколько раз так обжигался: вроде бы думаешь, что тут перебор ключевых слов, убираешь тут, убираешь там. Ждешь с нетерпением несколько апдейтов и бац! Страница улетает прямо на самое “дно”. К сожалению, такое тоже бывает и глаз далеко не всегда верный инструмент.

Поиск запросов

Я всегда рекомендовал и рекомендую снимать регулярно позиции сайта, не так важно каким способом, важна регулярность (к слову, мы пользуемся Топвизором, раньше чаще пользовались Allpositions). Но вы должны учитывать, что позиции очень сильно скачут, есть такое понятие как рандомизация выдачи и не стоит делать выводы только по одному-двум апдейтам. Рекомендую снимать позиции каждый день, чтобы видеть полную картину, ну или хотя бы в дни апдейта Яндекса, но точно не реже. И вообще, в нынешнее время колебания позиций в Яндексе – это абсолютно нормальное явление, все уже к этому привыкли. Вот пример скачков позиций:

Если позиции скачут довольно сильно то верх, то вниз, динамику лучше отследить в верхних точках “волн”, то есть сравнивать положительный апдейт с положительным, отрицательный с отрицательным. Тогда будет видна динамика, общее настроение наших позиций и куда они стремятся:

Теперь понимаете, наверное, почему я рекомендую снимать позиции часто. Представьте, вы снимаете позиции раз в месяц, в прошлом месяце сняли во время пика “волны”, а в этом в тот день, когда позиции оказались на низшей точке. Вы можете ошибочно начать рвать волосы. Не надо. Жалко их. 🙂 Это как раз могло бы произойти, если мы бы не владели достаточно полной информацией. Ну и не надо после первого неудачного апдейта бегом идти все исправлять. Нужно немного выждать.

Вот пример графика видимости сайта нашего клиента, который продвигается у нас почти 2 года, угадайте в какие дни все мы начинали паниковать? 🙂

Если мы поддались бы панике и начали бы на сайте предпринимать срочные меры по исправлению чего-то там, скорей всего было бы не так все классно, как сейчас. Повторюсь, в моменты обвала, если у вас нет никаких уведомлений в панели вебмастеров о наложенных фильтрах, не нужно сразу что-то предпринимать. Лучше выждать 2-3 апдейта и только потом приступать к каким-то телодвижениям.

Поиск страниц

Также, если изначально документ на сайт добавлялся переоптимизированным, то скорей всего вы не увидите скачков позиций на этих группах, страница изначально будет болтаться где-то в конце. Если после 3-4 апдейтов хорошо оптимизированная страница так и не вылезла ориентировочно ТОП-30-50, то скорей всего там есть переоптимизация (опять же порог разный для разных тематик с разным уровнем конкуренции).

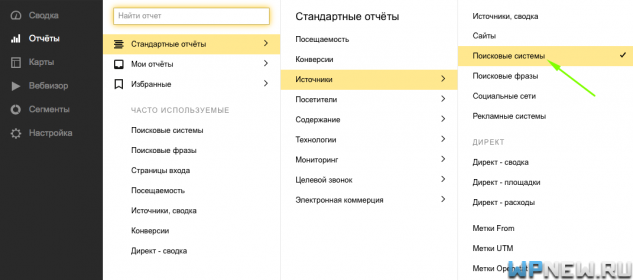

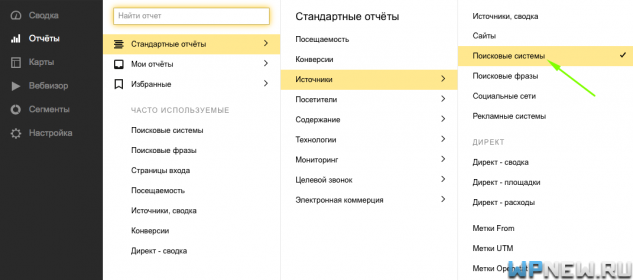

В съемщиках позиций находим запросы, которые просели и сохраняем себе их релевантный URL. Дальше переходим в Яндекс Метрику, во вкладку Отчеты -> Стандартные отчеты -> Источники -> Поисковые системы:

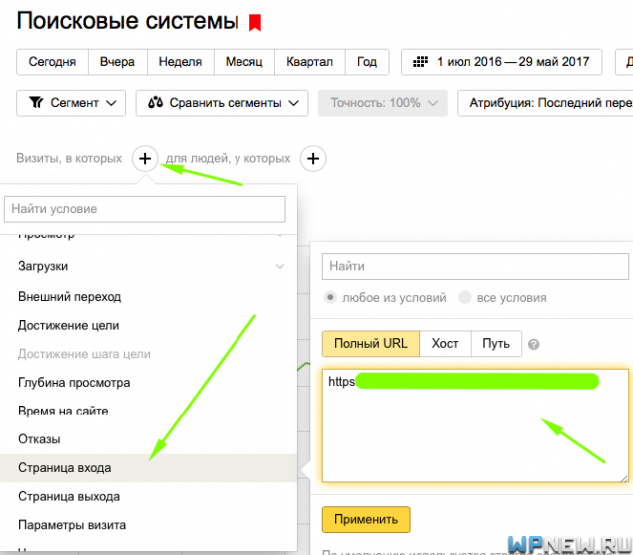

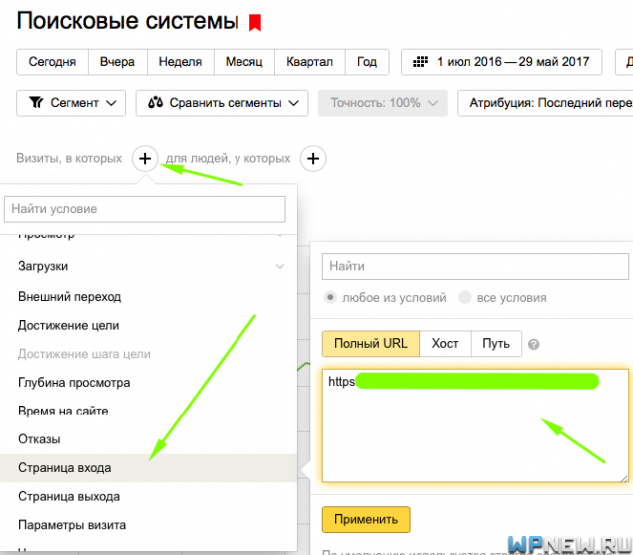

Оставляем график только от Яндекса и сегментируем по странице входа. Для этого нажимаем на “Визиты, в которых” -> Поведение -> Страница входа и там прописываем URL, где у нас просели позиции:

И мы увидим изменения трафика с Яндекса на данную страницу:

Вы сами на графике видите, как упал трафик с Яндекса на страницу. Примечание: конечно, если у вас запрос сезонный, то этот метод не совсем подойдет. Ну или если только вы сравните все относительно сезонности запроса.

Также может быть такое, что на всем сайте позиции в целом растут, но на нескольких страницах произошла просадка. Может быть даже такое, что просела сильно трафикогенерирующая страница, поэтому в целом динамика посещаемости сайта – отрицательная, но по факту общая видимость сайта увеличилась: больше страниц начали приближаться к ТОПу. Просто одна страница портит общую статистику, а это вообще не критично, если это выявить, скорректировать ее и заново вернуть в ТОП. К сожалению, многие не изучают такие вещи, не разбираются почему падает трафик и т.д.

Подобная просадка как на графике выше может быть как в следствии правок на сайте/на странице, так и в результате обновлений алгоритмов поисковиков. Они постоянно что-то “подкручивают”, чтобы результат выдачи по их мнению был “чище”. Найдя такие URL, произведя определенные действия, о которых я расскажу в следующем уроке, можно вернуть трафик или даже увеличить его.

Также может быть, что вместо продвигаемой страницы, которая изначально должна была быть в ТОПе по группе запросов, вылезла нерелевантная страница – это также верный признак переоптимизации (ну или снова может быть недостаточно оптимизации). Чтобы увидеть такие страницы обязательно нужно прописывать целевые URL запросам в съемщиках позиций, чтобы видеть та ли страница у нас вылезла в поиске. Прописывать целевые урлы проще простого, главное не лениться, вот на примере Топвизора (слева от запроса тыкаем на “черточку” и все):

В случае, если вылезла не та страница по нужным запросам, мы увидим заметное уведомление, что что-то не так:

Если “вылезла” не та страница, то, во-первых, из-за того, что она не предназначалась этим запросам, вряд ли она попадет в ТОП. Во-вторых, даже если по каким-то причинам попала в ТОП-10 или ТОП-20, скорей всего поведенческие факторы на этой странице окажутся плохими, и страница “откатится” вниз, ну и дополнительно конверсия на странице будет никакой.

В результате у нас появился список предполагаемых пессимизированных страниц или страниц, имеющие заспамленные запросы. Теперь мы можем дополнительно проверить, есть ли на них переспам или переоптимизация. Ну и также бывает, что съема позиций не производилось и информации, полученной выше, нет.

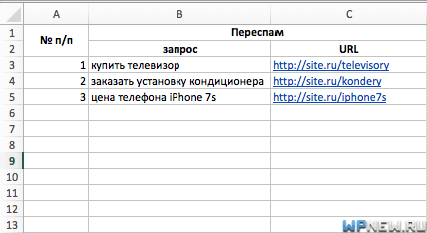

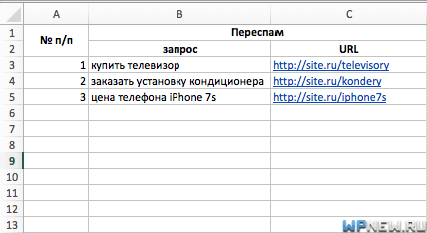

Получится 2 файла. Один с переспамом:

Второй с переоптимизацией:

Напоминаю, переспам – пессимизируется только запрос, переоптимизация – вся страница.

Нахождение запросов с переспамом

Если проседает только запрос (или он изначально находится на плохой позиции), можно проверить его на переспам. Для этого попробуйте поменять словоформу запроса (то есть использовать ключ в другом падеже, к примеру) или поменять порядок слов в запросе (пример: “купить телевизор” => “телевизор купить” или “купить телевизоры”). Если позиции сильно изменяются (к примеру, на 12 позиций) в положительную сторону, значит сильновероятно, что первоначальный запрос словил переспам.

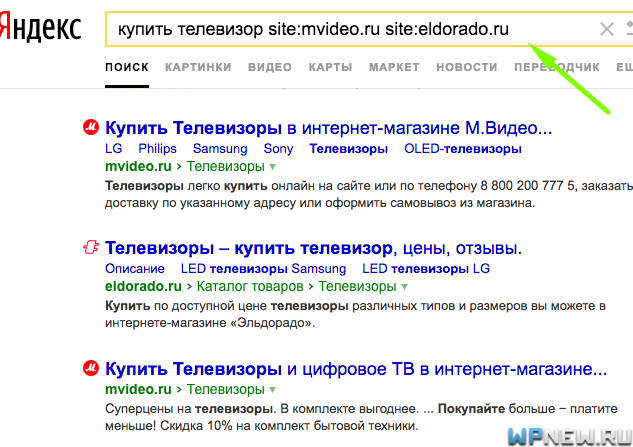

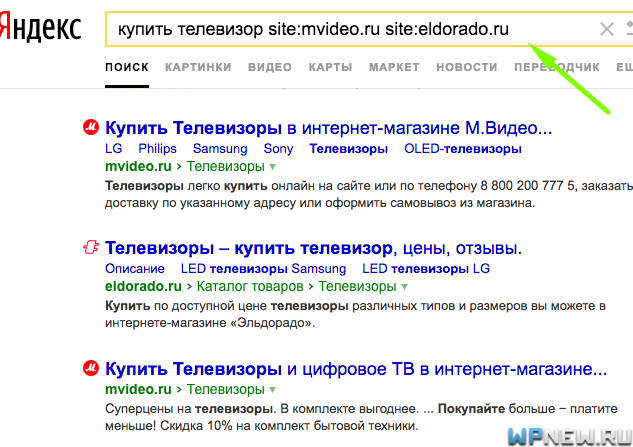

Проверка страниц на переоптимизацию

Теперь по второму файлу, нужно проверить URL на переоптимизацию. Находим сайт, который на ненамного выше вашего сайта (на несколько пунктов) и вбиваем в Яндекс следующее:

поисковый запрос site:vashsite.ru site:sravnivaemyj-sajt.ru

Если мы в итоге оказались выше данного сайта (хотя в обычной выдаче были ниже), то сильновероятно, что на нашей странице присутствует переоптимизация.

Проверка страниц на переоптимизацию автоматическим методом

Конечно, можно проверять ручками все это дело, но можно пойти другим путем. Совершенно бесплатно можно проверять документы на переоптимизацию в “Пиксель Тулс”. Он все сделает сам. Очень удобно.

Примечание: Пиксель Тулс не будет проверять страницу на переоптимизацию, если проверяемый запрос находится в ТОП-5 или за ТОП-100.

![]()

Для примера выше я взял как раз запрос, относящийся к странице, где и произошла просадка с Яндекса:

Очень нужная информация по данному URL – не так ли?

Еще один сервис, который подсказывает страница переоптимизирована или нет – это сервис Арсенкина.

Заключение

Если находить подобные проблемы на сайте, их можно точечно устранять и влиять суммарно на весь трафик. Более того, бывают “шаблонные случаи”, когда ты находишь переоптимизацию и, скорректировав ее, не одна страница “вылезает”, а целая пачка, на которые влиял один и тот же фактор.

Ну а о том, что же делать, если все-таки вы обнаружили переспам или переоптимизацию на страницах сайта, я рассказал в следующем уроке, который уже опубликовал. Чтобы не пропустить следующие уроки, подпишитесь на бесплатную рассылку уроков (она расположена чуть ниже или в сайдбаре) и вы первыми будете в курсе всех свежих постов.

Остались вопросы? Пишите в комментариях, отвечу всем, впрочем как и всегда. 🙂

Ну и мне было бы очень приятно, если вы понажимаете на социальные кнопки ниже и поделитесь с друзьями в социальных сетях данным постом. 😉

Удачи!

PPT — Proactive Re-Optimation PowerPoint Presentation, скачать бесплатно

Proactive Re-optimisation Совместная работа с Шивнатхом Бабу и Дэвидом ДеВиттом Педро Бизарро

В чем проблема? Иногда оптимизаторы запросов к базе данных выбирают планы выполнения, которые являются неоптимальными по порядку величины.

Как возникает проблема (1) • Статистика может быть устаревшей • Статистика может отсутствовать • Статистические данные оцениваются на основе по • другой (возможно, оценочной) статистике • допущениям (независимость, единообразие и т.д.) • значениям по умолчанию Ошибки в оценках

Как возникает проблема (2) • Ошибки в оценочных размерах промежуточных таблиц экспоненциально растут [IC91] • Функции затрат не гладкие. Стоимость Память Небольшие ошибки могут стать большими ошибками [IC91] Иоаннидис и Христодулакис.О распространении ошибок в размере результатов соединения. SIGMOD’91

Дорожная карта • Введение • Повторная оптимизация (и ее ограничения) • Проактивная повторная оптимизация • Ограничивающие рамки • Надежные и переключаемые планы • Случайные выборки • Экспериментальные результаты • Выводы

Повторная оптимизация : Текущий подход, например, [KD98, I + 99, M + 04] • Используйте обычные оптимизаторы • Добавьте операторы проверки в план, чтобы: • проверить наличие значительных расхождений между расчетными и наблюдаемыми значениями • проверить, когда план становится неоптимальным • Подход «Выполнение и реагирование» • Повторная оптимизация срабатывания триггера в случае неудачной проверки [KD98] Кабра и ДеВитт.Эффективная повторная оптимизация промежуточных запросов для неоптимальных планов выполнения запросов. SIGMOD’98 [I + 99] Айвз и др. Адаптивная система выполнения запросов для интеграции данных. SIGMOD’99. [MR + 04] Markl, et al. Надежная обработка запросов за счет прогрессивной оптимизации. SIGMOD’04

Традиционный оптимизатор выбирает план P: Ре-оптимизатор выбирает тот же план P и добавляет проверки INLJ INLJ CHECK TT INLJ INLJ CHECK RSRS Повторная оптимизация: текущий подход (продолжение)

Re- Главное ограничение оптимизации • Оптимизатор выбирает план, не зная о возможных будущих повторных оптимизациях • I.д., оптимизация не предполагает повторной оптимизации • Что может пойти не так? Можем ли мы сделать лучше?

P1 Пример запроса: σ (R) S P1: P2: Стоимость HHJ HHJ P2 σ (R) S σ (R) S Размер σ (R) Расчетный размер σ (R) Ограничения повторной оптимизации • Повторная оптимизация стоит дорого (можно избежать ее, используя надежные планы) • Может быть потеряна частичная работа • Если начать с P1 и повторно оптимизировать до P2, повторное сканирование на R P1 рискованно! P2 надежен.

Повторная оптимизация Повторная оптимизация Повторная оптимизация INLJ HHJ HHJ HHJ TTT σ (R) INLJ HHJ HHJ HHJ σ (R) σ (R) SSSS σ (R) T Ограничения повторной оптимизации (2) • Ограниченная информация, собираемая во время выполнения • Операторы проверки обнаруживают только момент повторной оптимизации • E.g: Слишком долго, чтобы найти хороший план

Дорожная карта • Введение • Повторная оптимизация (и ее ограничения) • Упреждающая повторная оптимизация • Граничные рамки • Надежные и переключаемые планы • Случайные выборки • Экспериментальные результаты • Выводы

В двух словах проактивную повторную оптимизацию Если СУБД знает, что повторная оптимизация может произойти: постарайтесь этого избежать! Выберите надежные (и переключаемые) планы Соберите статистику для будущей повторной оптимизации Планируйте это!

Использование ограничивающих рамок Использование надежных планов и переключаемых планов Расширенный сбор статистики времени выполнения Строительные блоки упреждающей повторной оптимизации Интервалы вокруг оценок для представления неопределенности Близкие к оптимальным в ограничивающей рамке Набор планов, каждый из которых близок к оптимальному в часть ограничивающего прямоугольника Для более быстрого обнаружения субоптимальности и предотвращения повторной оптимизации

1.Вычислить ограничивающих прямоугольников для оценок Нет, повторно оптимизировать оценку в рамках ограничивающего прямоугольника? Да, использовать надежный или переключаемый план 3. Выполнить запрос; Сбор точных статистических оценок Оценки времени выполнения Упреждающая повторная оптимизация Архитектура Оптимизация ЗАПРОС 2. Используйте ограничивающие рамки для выбора надежных или переключаемых планов КАТАЛОГ Выполнение

Дорожная карта • Введение • Повторная оптимизация (и ее ограничения) • Проактивная повторная оптимизация • Граничные рамки • Надежные и переключаемые планы • Случайные выборки • Экспериментальные результаты • Выводы

Граничные рамки: представление неопределенности • Интервал вокруг оценки: • широкий, если оптимизатор не уверен в оценке • узкий, если оптимизатор уверен в оценке • Неопределенность измеряется по способу оценки статистики [KD98], e.g .: • Гистограмма -> очень достоверно • Умножение избирательностей -> неопределенно • Предположение по умолчанию -> очень неопределенное • И т.д. [KD98] Кабра и ДеВитт. Эффективная повторная оптимизация промежуточных запросов для неоптимальных планов выполнения запросов. SIGMOD’98

Запрос: σ (R) S Граничные рамки: представление неопределенности • Интервал вокруг оценки: • широкий, если оптимизатор не уверен в оценке • узкий, если оптимизатор уверен в оценке Оценка | S | Ограничивающая рамка наивысшая оценка низкая Расчетная | σ (R) | низкая оценка высокая

Граничные рамки: стоимость плана и сокращение • Стоимость — вычисляет три стоимости для каждого дерева плана: (2-тусклая ограничивающая рамка с использованием оценок мощности из подпланов) • Сокращение • Для каждого подмножества соединений и интересно заказ найдите 3 плана: • BestLow план с наименьшим значением CLow • BestEst план с наименьшим значением CEst • BestHigh план с наименьшей стоимостью CHigh? | S | CHigh, стоимость здесь CEst, стоимость здесь CLow, стоимость здесь HHJ high est.σ (R) низкий S | σ (R) | низкая оценка высокая

Дорожная карта • Введение • Повторная оптимизация (и ее ограничения) • Упреждающая повторная оптимизация • Граничные рамки • Надежные и переключаемые планы • Случайные выборки • Экспериментальные результаты • Выводы

В конце Перечисления планов существует три начальных плана: Четыре случая: исходные точки являются одним и тем же планом Одно из начальных значений является надежным Из них может быть создан переключаемый план Нет единого плана, не надежного, не переключаемого Запрос: σ (R) S P1 : P2: P1 Стоимость HHJ HHJ σ (R) S σ (R) S P2 Размер σ (R) Граничная рамка для σ (R) оценка низкой оценочной высокой стоимости в пределах 20% от лучших во всех 3 точках ограничивающей рамки Выбор планов BestEst = P1 BestHigh = P2 BestLow = P1

E.g .: INLJ Hash3 Hash4 Поиск индекса при T сканирование T сканирование T Hash2 Hash2 Hash2 сканирование R сканирование S сканирование R сканирование S сканирование R сканирование S переключаемые планы • Цель: избежать повторной оптимизации, но по-прежнему использовать лучший план в ограничивающей рамке • Как : Определите переключаемые планы, чтобы разрешить позднее принятие решения о привязке • Планы можно переключать, если: • Иметь другого корневого оператора • Иметь тот же подплан, что и один из входов в корень • Иметь ту же базовую таблицу, что и другой вход

решение о поздней привязке INLJ Hash3 Hash4 Индекс Поиск при T сканирование T сканирование T Hash2 Hash2 Hash2 сканирование R сканирование S сканирование R сканирование S сканирование R сканирование S переключаемые планы • Выполнение (часть) общего подплана • Сбор оценок времени выполнения • Создать лучший план начального числа для этих оценок INLJ Hash3 Hash4 Index Seek on T Scan T Scan T? ? ?

переключатель оператор INLJ, поиск индекса на T? Hash3, оператор буфера сканирования T Hash4, сканирование T Реализация переключаемого плана • Буферизация кортежей до тех пор, пока не будет получена случайная выборка кортежа • Вычислить оценку и передать ее оператору переключения • Оператор переключения создает экземпляр правильного оператора • Минимальные накладные расходы Переключаемый план T Hash2 Scan R Scan S

Дорожная карта • Введение • Повторная оптимизация (и ее ограничения) • Упреждающая повторная оптимизация • Ограничивающие рамки • Надежные и переключаемые планы • Случайные выборки • Экспериментальные результаты • Выводы

Наблюдение за статистикой во время выполнения- Время Использование • Определите, когда проводить повторную оптимизацию • Выберите вариант плана с возможностью переключения Цели • Должен быть эффективным • Должен быть быстрым • Должен быть точным

b cdfgij Выдать знак препинания eos (30%) для родительского оператора Идея: случайный Пример префикса • Префиксный вывод операторов со случайной выборкой всего их вывода Нормальный вывод без префикса случайной выборки aabcdeefghhij Ou tput с префиксом случайной выборки • Распространение префиксов выборки снизу вверх • Реализовано для сканирования файлов, индексированного сканирования, соединений с вложенными циклами, хэш-соединения

NLJ …… Примеры префиксов внедренияRandom • Предварительно вычисленные образцы таблиц: • Для у каждой таблицы R есть другая таблица R_sample • Модифицированный оператор сканирования: • scan R_sample • испускать eos • сканировать R, пропуская кортежи в R_sample • Модифицированный оператор соединения вложенных циклов: • Передавать eos из внешнего отношения • Истинная случайная выборка соединения, если внешнее Сторона FK • См. Документ для хеш-соединения eos eos

Дорожная карта • Введение • Повторная оптимизация (и ее ограничения) • Упреждающая повторная оптимизация • Ограничивающие рамки • Надежные и переключаемые планы • Случайные выборки • Экспериментальные результаты • Выводы

Экспериментальная оценка • Создано в СУБД Predator • Реализовано три оптимизатора: • Rio, наш упреждающий ре-оптимизатор • Реактивный ре-оптимизатор • Традиционный dyna Оптимизатор программирования микрофонов • Синтетическая версия набора данных DMV от IBM • Коррелированные атрибуты • Более подробная информация в документе Наша реализация [MR + 04] [MR + 04] Markl, et al.Надежная обработка запросов за счет прогрессивной оптимизации. SIGMOD’04

Использование надежных планов Запрос σ (A) C

Использование переключаемых планов Запрос σ (A) C

3-сторонний запрос соединения (O000) σ5 (A) C

Сложность запроса Ошибки из-за коррелированных атрибутов

Выводы • Постоянно растущее количество данных, запросов и системы • Статистика будет неопределенной • Возможны ошибки оптимизатора • Перспективный подход: упреждающая повторная оптимизация • Ограничивающие рамки • Надежность и переключаемые планы • Быстрый, эффективный и точный сбор статистики во время выполнения • Дальнейшая работа: улучшение отдельных компонентов

Благодарности Дженнифер Видом за обсуждение и отзывы Гая Ломана и Фолькера Маркла за предоставление данных DMV и генератора рабочей нагрузки

Спасибо! Вопросы? Обратная связь? Посмотрите нашу демонстрацию!

Традиционный Re-Optimizer Proactive Re-opt Switch HHJ HHJ σ (O) σ (O) σ (O) Switch HHJ HHJ σ (A) C σ (A) C σ (A) C Повторная оптимизация Повторно оптимизирует Субоптимальный HHJ HHJ Оптимальный σ (O) HHJ HHJ σ (A) Субоптимальный σ (A) CC σ (O) Трехстороннее соединение: σ (A) C σ (O) Предположить ошибку в оценке σ (А)!

Частота повторной оптимизации | Элитный торговец

Вот пример, чтобы лучше объяснить мою дилемму.Рассмотрим действительно простую длинную стратегию, в которой вы покупаете, когда цена начинает расти, и продаете, когда она начинает двигаться вниз. Допустим, вы используете простую скользящую среднюю для определения тренда. То есть, если наклон скользящей средней положительный, мы открываем длинную позицию. Иначе вы ликвидируете нашу позицию.

Можно показать, что эта простая стратегия нормально работает, если мы получим ПРАВИЛЬНЫЕ ПАРАМЕТРЫ.

Параметры здесь:

(1) Размер окна скользящей средней и

(2) Пороговое значение, используемое для определения того, насколько положительный наклон достаточен, чтобы считать тренд достойным прыжка.

Легко увидеть, если окно скользящей средней или порог слишком низки, мы рискуем слишком сильно реагировать на шум. Если они будут слишком большими, то мы рискуем опоздать на вечеринку.

Независимо от того, какую стратегию вы используете (MACD, адаптивная MA), всегда необходимо принять некоторые параметрические решения.Я пытаюсь найти способ принимать эти параметрические решения как можно более научно. Один из способов сделать это — оптимизировать параметры посредством тестирования на истории.

Итак, возникает вопрос: как часто следует повторно оптимизировать эти параметры?

Я не ищу предложений по стратегии. У каждой стратегии будет эта проблема.

Цитата из sidm:.Руководство по настройке маршрутизации сегментовПривет,

Я пытаюсь разработать стратегии следования за трендом на основе скользящих средних.Я немного озадачен, когда дело доходит до повторной оптимизации. Как часто вы, ребята, повторно оптимизируете параметры своих стратегий?

С одной стороны, частая повторная оптимизация может привести к чрезмерной подгонке (слишком быстрой реакции на шум).

С другой стороны, слишком большой интервал между повторными оптимизациями может привести к тому, что параметры в конечном итоге станут устаревшими.

Можно было бы оптимизировать частоту самой повторной оптимизации, но тогда это довольно скользкая дорожка — на каком уровне вы остановитесь?

Приветствуются любые мысли / обсуждения.

Сид.

Подробнее …

— Управление трафиком маршрутизации сегментов с помощью IS-IS [Маршрутизаторы служб агрегации Cisco ASR серии 1000]

Головной узел проверяет путь LSP SR-TE на предмет возможности соединения с топологией TE. Головной узел MPLS-TE проверяет, подключены ли каналы, соответствующие SID смежности, в топологии TE.

Для вновь созданных LSP SR-TE, если головной узел обнаруживает разрыв в любом звене пути SR-TE, этот путь считается недействительным и не используется.Если у туннеля есть другие варианты пути с допустимыми путями, эти пути используются для создания экземпляра LSP туннеля.

Для туннелей TE с существующим созданным экземпляром SR-TE LSP, если головной узел обнаруживает разрыв на каком-либо канале, головной узел предполагает, что на этом канале произошел сбой. В этом случае вступает в силу местная защита от ремонта, такая как IP FRR. IGP продолжают поддерживать защищенную метку смежности и связанную пересылку после потери смежности в течение некоторого времени. Это дает головным станциям достаточно времени, чтобы перенаправить туннели на другие пути, на которые не влияет один и тот же отказ.Головной узел запускает таймер аннулирования туннеля, как только он обнаруживает сбой канала, чтобы попытаться перенаправить туннель на другие доступные варианты пути с действительными путями.

Если туннель TE настроен с другими параметрами пути, на которые сбой не влияет и которые проверены, головной узел использует один из этих параметров пути для перенаправления (и повторной оптимизации) туннеля путем создания экземпляра нового первичного LSP для туннель по незатронутому пути.