Проверить сайт на уникальность: Анализ контента сайта на уникальность (плагиат)

Проверить сайт на уникальность контента онлайн, проверить страницы сайта на уникальность

Ваши последние проверки

Для доступа к истории проверок нужно войти в систему

Новости сервиса

24.05.2021 20.09.2020 22.09.2019Проверка страниц сайта на уникальность

Для проверки отдельной страницы достаточно ввести адрес в соответствующее поле. Система выделит контент страницы, удалит навигационные элементы, не имеющие отношения к тексту, а затем проверит на уникальность.

Если нужно проверить несколько страниц и у вас есть их список, воспользуйтесь пунктом «Пакетная проверка» и вы сможете ввести весь список сразу.

Мы проверим их по очереди и вы сможете увидеть результаты каждой из проверок.

Автоматическая регулярная проверка сайта

Попробуйте нашу автоматическую регулярную проверку — добавьте страницы сайта на защиту, и мы будем мониторить их уникальность и отправлять вам отчеты на почту!

Лимиты

Нужно проверить весь сайт, а лимитов не хватает? Вы можете купить подписку и проверять значительно больше!

Автоматический подбор разделов сайта

Когда вам нужно проверить страницы определенного раздела сайта или все они имеют похожий адрес, можно воспользоваться новым функционалом сканирования сайта и не искать их вручную.

Проверка идет в два этапа. Сначала укажите адрес сайта, и мы просканируем его и покажем все разделы. Затем вы можете одним кликом проверить любой раздел!

Поиск ссылки на источник

Пользователям с подписками доступна новая функция — автоматический поиск ссылок на проверяемый сайт. Мы будем искать упоминание или активную ссылку на ваш сайт при каждой проверке.

Это позволит вам быстро принять решение о том, является ли копия плагиатом или нет.

Мы будем искать упоминание или активную ссылку на ваш сайт при каждой проверке.

Это позволит вам быстро принять решение о том, является ли копия плагиатом или нет.

Пожалуйста, сообщайте об ошибках, оставляйте отзывы и предложения.

Обратите внимание, на нашем сайте можно также проверить текст на уникальность.

Проверить текст на уникальность онлайн бесплатно

Любая научная работа (дипломная, курсовая, реферат, статья, диссертация и т.д.) перед сдачей должна пройти обязательную проверку на уникальность (подлинность) текста. Согласно требованиям Министерства Образования, студент или научный сотрудник обязан пользоваться только собственными знаниями: если работа скопирована — университет не допускает автора до защиты.

Но самостоятельное написание не является гарантией высокого процента оригинальности текста, потому что любая работа содержит ряд обязательной информации:

- теории;

- юридические законы;

- цитаты;

- распространенные речевые обороты.

Онлайн проверка текста на уникальность

Поэтому лучше проверять уникальность текста заранее — это позволит устранить все замечания еще до проверки преподавателями. В Интернете можно найти десятки платных и бесплатных антиплагиат-сервисов, но не каждому из них можно доверять. Одни программы используют устаревшие алгоритмы, другие — не предоставляют отчет, третьи — недоступны для студентов.

Поэтому мы создали свою программу для проверки уникальности текста и контента. Она полностью автоматизирована, работает круглосуточно и без регистрации. На проверку одного текста или документа требуется не более 30 секунд.

Как происходит анализ уникальности документа?

За те 30 секунд, пока идет анализ, программа для проверки уникальности статьи, проделывает огромную работу. Она сопоставляет исходный текст с миллионами других документов, которые опубликованы в интернете или хранятся в закрытых базах данных библиотек и университетов.

Для этого текст разбивается на фрагменты определенной величины — шинглы. Вот «постулат теории относительности» — это шингл из 3 слов. Программа по специальным алгоритмам ищет эту фразу в других документах. Если находит, то отмечает фрагмент как заимствованный и снижает процент уникальности. К примеру, показатель оригинальности 80% означает, что в документе содержится 80% авторского материала, а оставшиеся 20% — это плагиат.

Вот «постулат теории относительности» — это шингл из 3 слов. Программа по специальным алгоритмам ищет эту фразу в других документах. Если находит, то отмечает фрагмент как заимствованный и снижает процент уникальности. К примеру, показатель оригинальности 80% означает, что в документе содержится 80% авторского материала, а оставшиеся 20% — это плагиат.

- Загружаете работу, который нужно проверить на уникальность. Поддерживаются все основные форматы: doc, docx, odt, pdf, rtf, txt.

- Выбираете алгоритм, по которому будет осуществляться проверка. Нужно использовать ту систему, которую применяют в вашем учебном заведении. Просто уточните у преподавателя — это не тайна, такая информация является открытой.

- Если нужны дополнительные опции, отметьте их галочками. Можно поискать в файле следы технического кодирования и скрытый текст.

Это признаки того, что документ подвергался искусственному увеличению оригинальности. Если такие «улики» обнаружены, сервис позволяет их сразу же уничтожить.

Это признаки того, что документ подвергался искусственному увеличению оригинальности. Если такие «улики» обнаружены, сервис позволяет их сразу же уничтожить. - Работа отправляется на проверку. Анализ занимает примерно 30 секунд.

- Вы получаете подробный отчет, где указан процент оригинальности, а заимствованные словосочетания выделены цветом. Здесь же можно посмотреть, откуда, по мнению умного алгоритма, вы стащили фрагменты материала. Скорее всего, практически все цитаты, теории и названия законодательных актов будут отмечены как плагиат.

Antiplagius — лучший сервис определения оригинальности текста

Преимущества нашего сервиса для проверки оригинальности текста:

- В отличие от других сервисов, мы бесплатно проверяем не только большие тексты, но и документы. Работаем с текстами до 200 000 знаков и с документами до 20 Мб.

- Массовая проверка уникальности текста без регистрации. Чтобы пройти тест на уникальность, вам не нужно создавать аккаунт на сайте.

- Нам удалось учесть алгоритмы всех современных онлайн-сервисов для проверки уникальности текста, поэтому мы можем гарантировать объективность и точность полученных результатов.

- Наша программа проверки уникальности позволяет: установить процент оригинальности, увидеть заимствованные фрагменты, получить ссылки на первоисточники.

- Система работает практически мгновенно — всего 30 секунд, и отчет готов. Другие сервисы, через которые ведется массовая проверка документов, не могут похвастаться такой оперативностью. Там ваша работа попадает в длинную очередь и может стоять в ней часами.

- Мы предоставляем возможность сохранить отчет в формате pdf и поделиться результатами с друзьями в социальных сетях или используя ссылку.

А еще, вы сможете получить на нашем сайте и другие услуги:

- профессиональный анализ работы — поиск плагиата и технических ошибок;

- повышение уникальности;

- глубокая проверка в других сервисах (в том числе в закрытой для студентов системе «Антиплагиат.

ВУЗ»).

ВУЗ»).

К нам обратились уже 1 500 000 студентов, и все они получили хорошую оценку или «зачет» на защите. Мы можем помочь и вам!

Уникальность контента сайта, орфография, качество

Описание

Сервис позволяет проверить уникальность сайта, орфографию и качество текстов. Для проверки сайта необходимо зарегистрироваться и пополнить баланс на сумму из строки «Максимальная стоимость заказа», которая зависит от выбранных параметров. Реальная стоимость заказа будет зависеть от объема текстов на собранных страницах.

Подробные результаты проверки хранятся 7 дней, далее заказ переходит в архив и остается только общая информация.

Рассмотрим основные этапы проверки сайта.

Оформление заказа

Сервис может получить адреса страниц из списка адресов, карты сайта, файлов RSS или сканируя сайт пауком. Причем сбор адресов может осуществляться сразу из всех источников, пока не будет достигнут указанный лимит максимального количества страниц. Приоритет источников такой же как расположение вкладок в форме: сначала адреса берутся из списка, затем из sitemap, потом из RSS и через сканирование.

Приоритет источников такой же как расположение вкладок в форме: сначала адреса берутся из списка, затем из sitemap, потом из RSS и через сканирование.

Выбранные параметры проверки затем нельзя отредактировать, но можно создать новый заказ.

При сканировании с помощью паука можно закрывать ненужные участки страниц тегом noindex, а ненужные разделы сайта в файле robots.txt.

Отправка собранных адресов на проверку

После получения адресов страниц Вам необходимо проверить и удалить из списка ненужные и отправить заказ на проверку. Вы можете ожидать выполнения заказа во вкладке браузера или зайти позднее, так как исполнение заказа займет некоторое время. После выполнения проверки Вам на email придет уведомление о готовности.

Обработка страниц

Обработка большого количества страниц займет время, Вы можете ожидать во вкладке или дождаться уведомления о готовности на email, при этом вкладку можно закрыть.

Страницы, вернувшие ошибку или не содержащие достаточного объем текста (менее 100 символов) не будут обработаны.

Результат

Результат проверки сайта состоит из общей информации об уникальности, качестве и орфографии сайта и информации по каждой странице. Общая информация хранится даже после перевода заказа в архив. Подробная информация о каждой странице удаляется через 7 дней.Пример общей информации:

Пример информации о странице:

Переходя по ссылкам, можно ознакомиться с подробной информацией об уникальности, качестве, орфографии

Как выглядит проверка с телефона (видео)

5 сервисов для проверки контента сайта

Уникальность – один из самых важных критериев текста при поисковом продвижении. Если использовать контент, скопированный из других источников, то санкции поисковых систем отправят сайт далеко в конец выдачи. Поэтому важно перед всегда проверять текст на плагиат перед размещением. Я создал небольшую подборку из наиболее популярных сервисов проверки уникальности, где постараюсь расписать их главные преимущества и недостатки.

Если использовать контент, скопированный из других источников, то санкции поисковых систем отправят сайт далеко в конец выдачи. Поэтому важно перед всегда проверять текст на плагиат перед размещением. Я создал небольшую подборку из наиболее популярных сервисов проверки уникальности, где постараюсь расписать их главные преимущества и недостатки.

Для наглядности, глубину проверки буду субъективно оценивать по 10-ти бальной шкале. Где 1 – находит только точные копии больших фрагментов текста, 10 – для 100% уникальности приходится изобретать новые слова. Основана она исключительно на личных наблюдениях, если вы с ней не согласны, то мне будет интересно увидеть ваш личный рейтинг в комментариях.

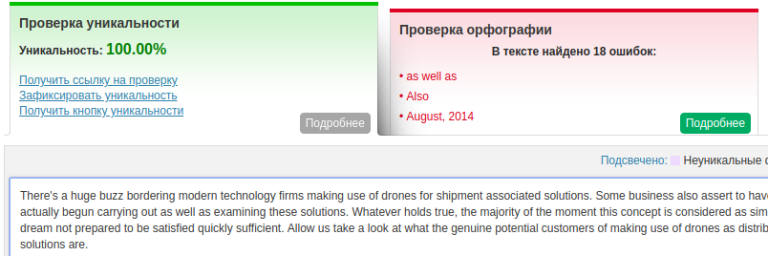

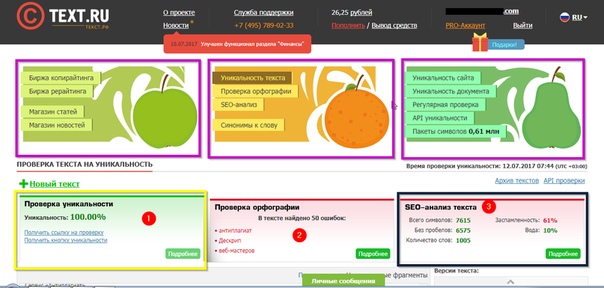

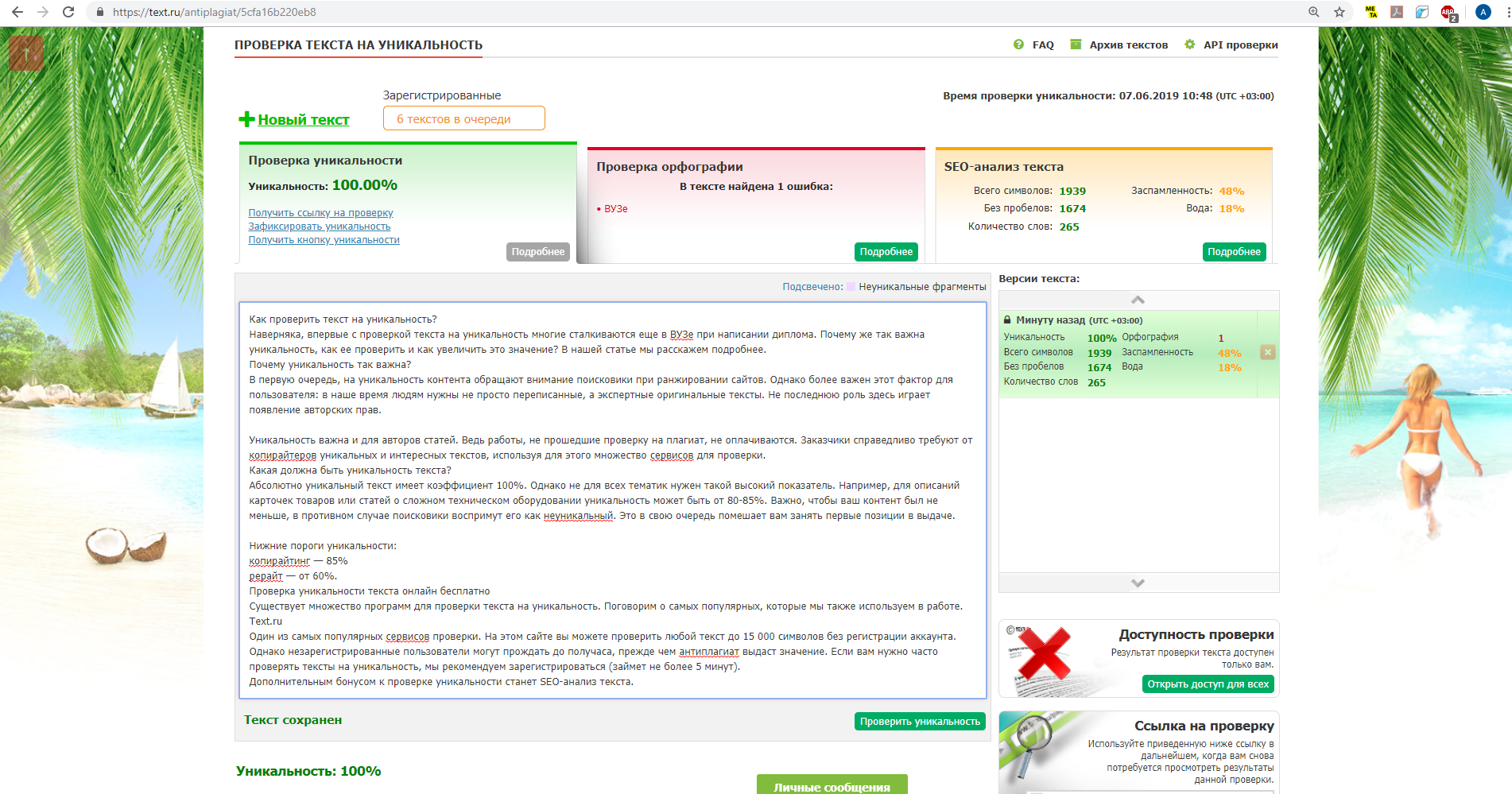

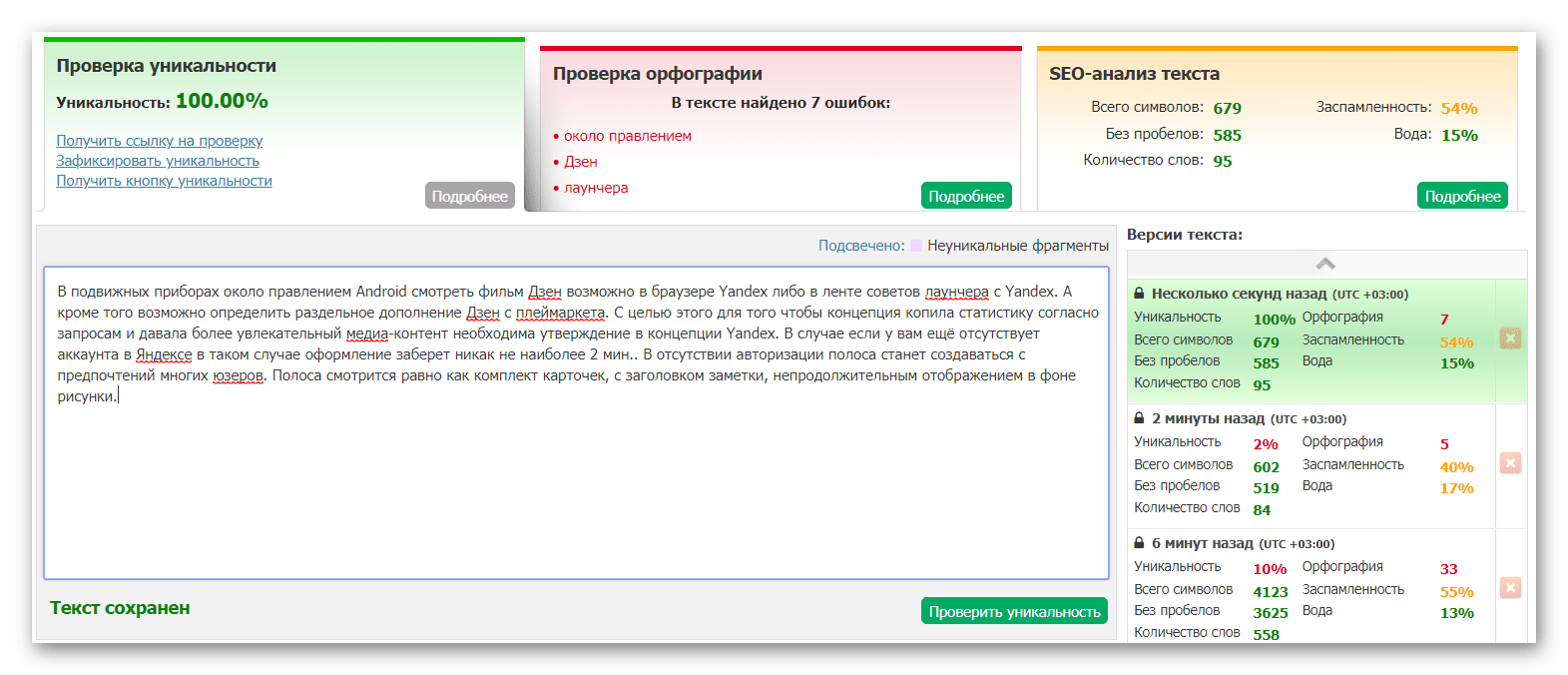

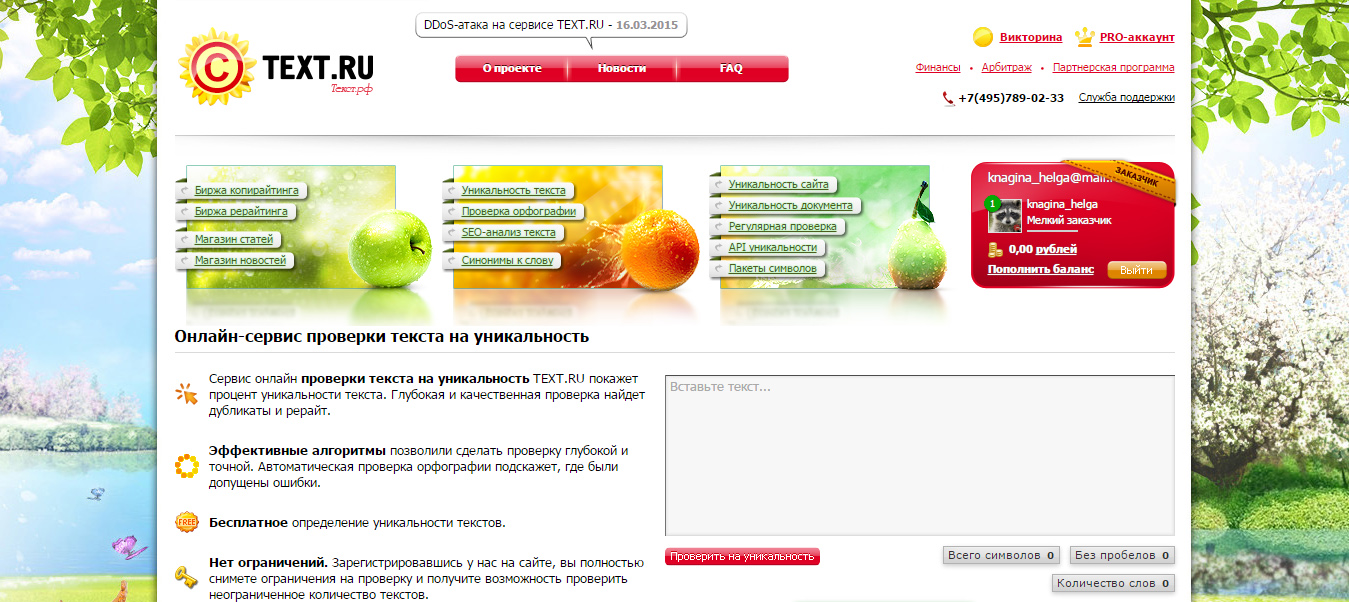

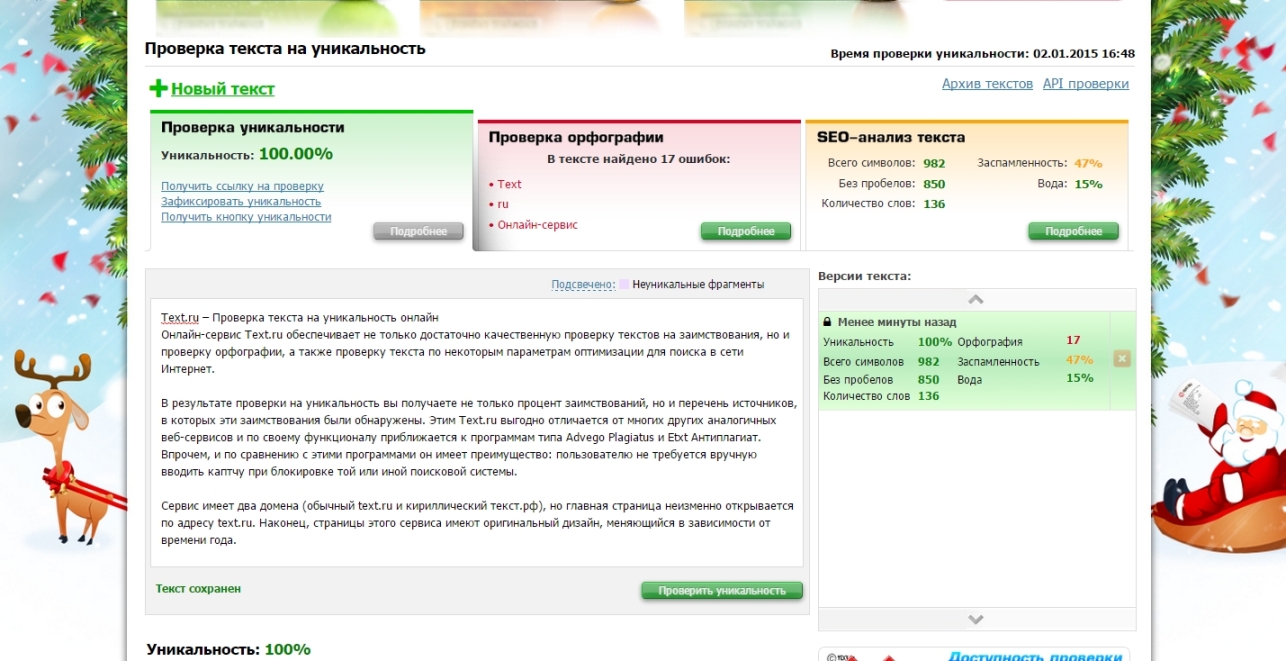

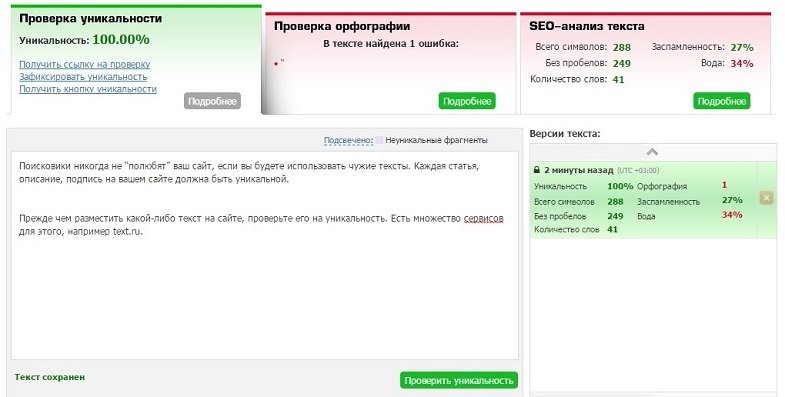

6 баллов. Онлайн-сервис, который позволяет быстро проверить текст до 15 тыс. символов. Лучше сразу пройти регистрацию, после чего вам будет доступно до 10 бесплатных проверок день. Также доступен PRO-аккаунт, который снимает ограничения по количеству текстов и значительно ускоряет работу сервиса.

Проверка качественная и занимает не слишком много времени. Поэтому сервис очень популярен среди копирайтеров. Он довольно точно выявляет поверхностный рерайт, особенно если автор пытается схитрить, например используя метод с заменой 1 слова в каждом шингле.

Также Text.ru проводит SEO-анализ текста (водность, заспамленность) и проверку орфографии.

Главный недостаток – ограниченное количество текстов, для больших объемов контента нужен PRO-аккаунт.

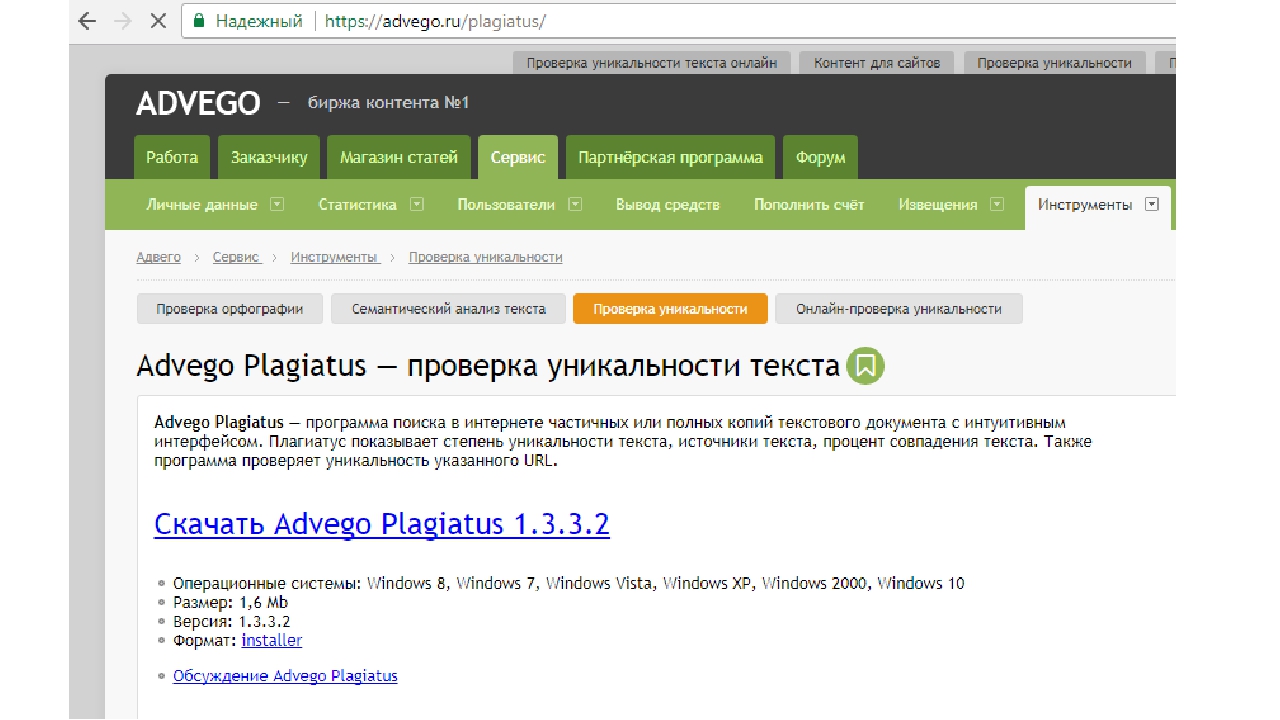

8 баллов. Сервис проверяет текст на плагиат сразу по нескольким критериям:

- повторение шинглов;

- совпадение большого количества слов и выражений во фрагментах текста;

- синонимы (заменяет некоторые слова синонимами, что позволяет выявить текст, который прогнали через уникализатор).

Также предоставляет удобные инструменты для семантического анализа (вода, классическая и академическая тошнота), этим заслужил свою популярность среди SEO-оптимизаторов.

Проверить на плагиат можно в онлайн-сервисе, а также в приложении Advego Plagiatus. Лично я считаю одной из наиболее полных и качественных проверок. Доступна настройка критериев.

Лично я считаю одной из наиболее полных и качественных проверок. Доступна настройка критериев.

Однако сервис часто излишне усерден, он находит случайные совпадения с самыми неожиданными источниками. Добиться 100% уникальности здесь вполне возможно, но будьте готовы к неожиданностям. В онлайн-сервисе бесплатный лимит – до 10 тыс символов в день.

Главный недостаток Advego в том, что корректно работает он только в рунете. Скорость проверки через приложение Advego Plagiatus также оставляет желать лучшего, а еще необходимо постоянно вводить капчу.

Комплексный интернет-маркетинг

Мы создаем систему взаимодействия различных инструментов продвижения, синергия которых приводит к отличным результатам. Мы разработаем механизм ведения Вашего бизнеса в интернете.

Получить консультацию

Наш менеджер свяжется с Вами в ближайшее время

Отправить заявку

5 баллов. Один из наиболее быстрых сервисов, в чем его главное преимущество на мой взгляд. Без регистрации вам доступно по 3 бесплатных проверки текста длиной до 10 тыс. символов. Content-Watch использует собственный уникальный алгоритм, поэтому о критериях проверки известно немного.

Без регистрации вам доступно по 3 бесплатных проверки текста длиной до 10 тыс. символов. Content-Watch использует собственный уникальный алгоритм, поэтому о критериях проверки известно немного.

Добиться 100% уникальности здесь несложно. Но не стоит считать, что Content-Watch легко обмануть. Он довольно точно определяет не только откровенный копипаст, но и рерайт низкого качества.

Сервис предоставляет очень полезный платный инструмент: регулярная проверка текстов сайта на плагиат. Таким образом вы сможете обнаружить, если кто-то позаимствует ваш контент.

7-10 баллов. Существует как онлайн-версия, так и отдельная программа, которую можно скачать и установить на ПК. В приложении можно настроить критерии и глубину проверки. Есть возможность сравнить два текста.

Без регистрации длина текста ограничена 3 тысячами символов, после – лимит вырастет до 5 тысяч. За оплату можно сразу отправить на проверку большое количество текстов, что очень удобно, если вы занимаетесь наполнением сайтов.

Читайте также

Качественный копирайтинг

При глубокой проверке на плагиат через приложение получить 100% уникальности очень сложно. Мы даже проверили эксперимент и проверили текст, полученный с помощью генератора контента от Яндекс.

Как видите, даже подобный набор слов получил только 62%.

У сервиса еще несколько серьезных недостатков. Первый – скорость, на одну статью может уйти до 20 минут. Второй – проверка на плагиат и рерайт проводится отдельно, что отбирает еще больше времени.

5 баллов. Полностью бесплатный онлайн-сервис, есть ограничения только по длине текста (10 тыс. символов). Заточен под Яндекс, что очень удобно для продвижения в этой поисковой системе. Определяет степень уникальности, заспамленность, а также процент воды.

Проверка длится недолго, очередь из текстов бывает редко, но требования к контенту здесь ниже, чем у остальных перечисленных сервисов.

Инструменты для проверки сайта

см. также:

также:

Инструменты для оптимизации сайта

Экспресс анализ сайта

SEO анализ веб страницы

Цена SEO аудита сайта

Проверка html (html валидатор)

Проверяет html код, как заданный с помощью ссылки на страницу, так и просто в виде загруженного файла или скопированного текста. Дает список замечаний с рекомендациями по их исправлению.

http://validator.w3.org/

Проверка css (css валидатор)

Проверяет стили документа или таблицу стилей, расположенную в отдельном файле.

http://jigsaw.w3.org/css-validator/

Проверка лент (feed) RSS и Atom

Проверяет правильность работы фидов RSS и Atom.

http://validator.w3.org/feed/

Проверка орфографии на веб странице

Подсвечивает ошибки на заданной URL странице.

http://webmaster.yandex.ru/spellcheck.xml

Показывает ошибки в тексте, скопированном в проверочное окно.

http://api.yandex.ru/speller/

Проверка структуры веб страницы

Показывает структуру веб страницы. Актуален для проверки html5 документов.

Неправильно отображает кириллицу (:.

http://gsnedders.html5.org/outliner/

Проверка контента на уникальность

В бесплатной версии показывает до 10 страниц в инете с частичным совпадением текста с вашей страницей.

http://www.copyscape.com

Проверяет уникальность текста введенного в форму. В бесплатной версии возможно ожидание результатов.

http://www.miratools.ru/Promo.aspx

Проверяет уникальность как введенного текста, так и текста по заданному URL, показывает уровень уникальности в процентах.

Имеет собственный алгоритм проверки.

http://content-watch.ru

Десктопные программы для проверки уникальности контента от бирж копирайтеров. Работают долго, но качественно. Etxt имеет версии для трех операционных систем: Mac, Linux и Windows.

Работают долго, но качественно. Etxt имеет версии для трех операционных систем: Mac, Linux и Windows.

http://advego.ru/plagiatus/

http://www.etxt.ru/antiplagiat/

Поиск похожих сайтов

Показывает сайты с похожим содержанием и схожей внутренней структурой.

http://similarsites.com

Проверка cms сайта

Проверяет наличие признаков наиболее известных cms.

http://2ip.ru/cms/

Проверка доступности с мобильных устройств

Оценивает возможность просмотра страницы с мобильных устройств и выдает список замечаний и ошибок.

http://validator.w3.org/mobile/

Проверка удобства сайта для телефонов от Гугл.

https://www.google.com/webmasters/tools/mobile-friendly/

Показывает скорость загрузки сайта на мобильных устройствах.

https://testmysite.withgoogle.com/intl/ru-ru

Сайт эмулятор выхода с мобильного телефона. Показывает сайт глазами выбранной модели.

Показывает сайт глазами выбранной модели.

http://www.mobilephoneemulator.com/

Проверка доступности для людей с ограниченными возможностями

Сервис проверки страницы для слабовидящих. Доступен on-linе и в виде плагина для Firefox.

http://wave.webaim.org/

Просмотр содержания сайта глазами поискового робота

Показывает текст сайта, приближенный к тому, что видит поисковый индексатор.

http://www.seo-browser.com/

Дистрибутив текстового браузер lynx для win32 систем. Перед использованием нужно отредактировать lynx.bat, указав в нем путь к директории с lynx.

http://www.fdisk.com/doslynx/lynxport.htm

Убирает все разметку и показывает текст страницы, мета теги и теги заголовков, число внешних и внутренних ссылок. Показывает превью страницы в google.

http://www.browseo.net

Проверка битых ссылок

Показывает список исходящих ссылок для URL и проверяет их отклик. Может проверять рекурсирвно, то есть переходить от одного документа к другому самостоятельно.

Может проверять рекурсирвно, то есть переходить от одного документа к другому самостоятельно.

http://validator.w3.org/checklink

Freeware инструмент для проверки битых ссылок. Для работы нужно установить его на свой компьютер. Рекурсивно сканирует сайт, делает отчеты, может быть полезен для составления карты сайта.

http://home.snafu.de/tilman/xenulink.html

Проверка перелинковки и заголовков страниц

Проверяет и показывает внутренние ссылки, заголовки страниц, наличие дублированного контента на сайте. Бесплатно позволяет сканировать сайт 1 раз в 30 дней.

http://www.siteliner.com/

Сканирует до 500 страниц сайта в бесплатной версии. Проверяет число внешних и внутренних ссылок. Выводит информацию о просканированных страницах: вложенность, коды ответа, названия, мета информацию и заголовки.

http://www.screamingfrog.co.uk/seo-spider/

Проверка ссылочной структуры и веса внутренних страниц

Программа сканирует сайт, строит матрицу внутренних ссылок,

добавляет внешние (входящие) ссылки с заданных URL и, на основании этих данных, рассчитывает

внутренние веса страниц сайта. Программа может быть использована для нахождения внешних (исходящих) ссылок для списка URL страниц сайта.

Программа может быть использована для нахождения внешних (исходящих) ссылок для списка URL страниц сайта.

http://www.design-sites.ru/utility/link-analyzer.php

Проверка HTTP заголовков и ответа сервера, видимости страниц для роботов

Проверяет коды ответа сервера, прогнозирует скорость загрузки страницы в зависимости от объема в байтах ее данных,

показывает содержимое html тега head, внутренние и внешние ссылки для страницы, содержимое страницы глазами поискового робота.

http://urivalet.com/

Проверяет коды ответа сервера. Дает возможность проверить редиректы (коды ответа 301, 302), заголовок Last-Modified и др.

http://www.rexswain.com/httpview.html

Показывает объемы и содержимое данных, передаваемых при загрузки страницы.

http://www.websiteoptimization.com/services/analyze/

Проверяет редиректы, использование атрибута canonical, мета теги, некоторые аспекты безопасности сайта. Дает рекомендации по улучшению загрузки страниц.

Дает рекомендации по улучшению загрузки страниц.

http://www.seositecheckup.com

Проверка информации о домене и об IP адресе

WHOIS-сервис центра регистрации доменов RU center. Дает информацию по IP адресам и доменам по всему миру. Иногда зависает.

https://www.nic.ru/whois/?wi=1

Служба Whois от РосНИИРОС (RIPN). Дает информацию для доменов в зоне RU и IP адресам из базы RIPE (Европа).

http://www.ripn.net:8080/nic/whois/

Определяет, где у домена хостинг и также показывает IP адрес сайта.

http://www.whoishostingthis.com

Проверка не включен ли IP адрес в черный список для рассылки email.

http://whatismyipaddress.com/blacklist-check

http://ru.smart-ip.net/spam-check/

Проверка MX записей для домена. Проверка SMTP сервера для домена. Проверка IP в черных списках для рассылки.

https://mxtoolbox. com/

com/

Поиск по базе зарегистрированных торговых марок в США.

http://tmsearch.uspto.gov/

Проверка файлов robots.txt

Проверяет доступность для индексации страниц сайта роботом Yandex.

http://webmaster.yandex.ru/robots.xml

Проверяет корректность файла robots.txt.

https://www.websiteplanet.com/webtools/robots-txt

Техосмотр сайта

Мониторинг доступности сайта. Дает возможость подключить один сайт бесплатно с минимальными опциями проверки.

http://www.siteuptime.com

Проверка скорости загрузки сайта. Посылает отчет на email. Имеет платные сервисы мониторинга доступности сайта.

http://webo.in

Проверка скорости загрузки страниц сайта.

http://www.iwebtool.com/speed_test

Видимость сайта в поисковиках

Сервис, показывающий ключевые слова для сайта, по которым он находится в ТОП 20 (первой двадцатке) выдачи Google во времени. Данные о поисковом и рекламном трафике.

Данные о поисковом и рекламном трафике.

http://www.semrush.com/

Положение в ТОП50 yandex и Google. Тиц сайта и PR главной страницы, наличие в важных каталогах, видимость в топе по ВЧ запросам.

http://pr-cy.ru/

Проверка банов и уровня доверия к сайту

Проверка трастовости сайта. Сервис, утверждающий, что он измеряет траст для Яндекса (проверить все равно никто не может :).

http://xtool.ru/

Проверка наложения фильтров Панда и Пингвин от Гугл. Сервис позволяет визуально определить падал ли сайт в даты апдейтов Панда и Пингвин.

http://feinternational.com/website-penalty-indicator/

Проверка Page Rank страниц сайта (при копировании URL в инструмент нужно стереть последнюю букву а потом написать заново).

http://www.prchecker.net/

Проверка истории развития сайта

Показывает историю развития сайта и дает возможность посмотреть скриншоты старых страниц.

http://www.archive.org/web/web.php

История позиций сайта в ТОП Google (ключевые фразы, страницы, заголовки), показателей PR, ТИЦ, Alexa Rank, числа обратных ссылок для популярных сайтов.

http://SavedHistory.com

SEO плагины для проверки сайтов

SEO Doctor — дополнение к Firefox. Показывает ссылки на странице и дает удобный интерфейс к различным SEO сервисам.

http://www.prelovac.com/vladimir/browser-addons/seo-doctor/

SeoQuake — дополнение к Firefox. Показывает важнейшие характериситки сайта: ТИЦ, PR, обратные ссылки, Alexa Rank.

Работает как с выдачей Google, так и с выдачей Yandex. Дает возможность быстрого анализа конкурентов.

http://www.seoquake.com/

IEContextHTML — дополнение к Internet Explorer. Проверяет индексацию ссылок в Yandex и Google, показывает список внешних и внутренних ссылок, позволяет импортировать данные c веб страниц.

http://www.design-sites.ru/utility/ie-context-html.php

Видимость сайта в посковиках в зависимосит от места расположения

Обновляемый список бесплатных прокси серверов, в том числе и Российских.

http://www.checker.freeproxy.ru/checker/last_checked_proxies.php

http://spys.ru/proxys/ru/

Анонимный бесплатный прокси с возможностью представиться из трех стран. Работает с поиском Google.

https://hide.me/en/proxy

Эммуляторы поиска Google в разных странах, путем задания параметров поиска.

http://searchlatte.com/

http://isearchfrom.com/

Проверка позиций в Yandex и Google

Сервис дает возможность глубокой проверки (до 500) позиции сайта по регионам в Yandex.

http://www.design-sites.ru/utility/search-xml.php

Анализ обратных ссылок

Осуществляет анализ ссылочной массы сайта, формирует срезы по различным критериям: тип ссылки, анкоры, страницы. Показывает вес обратных ссылок.

Сервис доступен только для зарегистрированных пользователей.

Показывает вес обратных ссылок.

Сервис доступен только для зарегистрированных пользователей.

http://ahrefs.com

Проверка наличая обратных ссылок на сайт

Проверяет наличие бэклинков на сайт в предложенном списке URL (до 100 страниц).

http://webmasters.ru/tools/tracker

см. также:

Инструменты для социально-направленного поиска

PlusOneChecker

Показывает число лайков (plusone) в Google+. Можно вводить сразу список проверяемых URl.

http://www.plusonechecker.net/

Facebook Graph API Explorer

При вводе в поле GET URL адреса страницы сайта (например: http://www.design-sites.ru/utility/express-analys.php) показывает число «Поделиться» и комментариев для этой страницы.

Для работы нужно быть «залогининым» в Facebook.

https://developers.facebook.com/tools/explorer

Показывает популярность в Твиттере, Google+, Facebook, LinkedIn, Pinterest, Delicious, StumbleUpon, Diggs.

http://sharedcount.com

Cool Social

Показывает популярность первой страницы сайта в Твиттере, Google+, Facebook, Delicious, StumbleUpon.

Для российских сайтов данные иногда неверные.

http://www.coolsocial.net

Social-Popularity

Показывает метрику «Поделиться» (Shares) для российских сетей: «В Контакте», «Одноклассники», «Mail.ru», «Ya.ru».

http://www.design-sites.ru/utility/social-popularity.php

Social Crawlytics

Сканирует сайт и формирует отчеты «Shares» основных зарубежных социальных сетей для этих страниц. Регистрирует пользователей через акаунт в твиттере. Отчеты можно видеть уже на следующий день.

https://socialcrawlytics.com

Проверка сайта на вирусы

Dr.Web

Проверяет заданный URL на подозрительный код, показывает подгружаемые скрипты и результаты их проверки.

http://vms.drweb.com/online/

Virus Total

Проверяет URL на вирусы 30 сканерами.

https://www.virustotal.com/#url

Alarmer

Система защиты сайта от вирусов. Ежедневно сканирует файлы сайта и присылает отчет об их изменениях по email.

http://www.design-sites.ru/alarmer.php

Проверка текста на уникальность: 7 онлайн сервисов

Контент и его уникальность в сегодняшнем SEO

Еще в далеком 1996 году Билл Гейтс предвидел, что именно уникальный контент станет залогом для успешного развития любой компании в сети Интернет. Конечно, он имел в виду не только текстовый, но и мультимедийный контент — фотографии, видеофайлы и аудиозаписи. О том, как проверять их на уникальность и уникализировать медиа-контент мы расскажем в следующих статьях, а сегодняшняя целиком и полностью посвящена обзору онлайн сервисов для проверки текстового контента на уникальность.

Зачем это нужно?

Уникальность и актуальность контента стали не просто факторами ранжирования. Алгоритмы семантического анализа от основных поисковых систем шагнули далеко вперед. Важно понимать, что простой уникальности теперь недостаточно для того, чтобы поисковик полюбил ваш текст. Основываясь на моделях LSI, Google и Яндекс постоянно совершенствуют методики оценки релевантности текста тому или иному запросу. Если говорить очень грубо, то ваш текст должен иметь собственный стиль, речь должна быть живой — изобиловать синонимами и нестандартными словосочетаниями, а тема должна быть максимально раскрыта по сравнению с конкурентами. Эпоха массового прямолинейного рерайта подходит к своему концу — добавляя что-то новое и полезное в текстовый контент, вы увеличиваете шансы на лучшее ранжирование.

Что такое неуникальный текст (плагиат)?

С точки зрения поисковой системы плагиат — это размещение уже знакомого ей текста на другом ресурсе. Вроде бы все довольно просто, но здесь важно обратить внимание на несколько факторов:

Вроде бы все довольно просто, но здесь важно обратить внимание на несколько факторов:

1. Первоисточником (автором) считается тот сайт, где робот ПС впервые обнаружил контент. Зачастую сайт, который скопировал текст с вашего ресурса, может быть проиндексирован быстрее и именно он будет считаться первоисточником. Это довольно распространенная проблема для интернет магазинов с выгрузкой товаров партнерам в реальном времени — многие ваши страницы будут проиндексированы позже, чем на партнерских ресурсах и плагиатором для ПС будет как раз ваш сайт.

2. Ничего страшного в том, что текст с вашего сайта скопировали нет, если поисковая система считает ваш ресурс первоисточником.

3. Поисковики умеют распознавать некачественный рерайт, а сервисы для проверки уникальности далеко не идеальны.

Сервисы для проверки уникальности текста онлайн

1. Content watch — очень простой и удобный сервис. В бесплатной версии позволяет проверять текст длиной до 10 тысяч символов, до 7 проверок в день. В платной версии есть возможность автоматизированных проверок с помощью API, также разработчики выпустили плагины для популярных CMS, что довольно удобно. Удобная реализация проверки текста по имени сайта с подбором страниц, однако, эта функция доступна только для зарегистрированных пользователей.

Content watch — очень простой и удобный сервис. В бесплатной версии позволяет проверять текст длиной до 10 тысяч символов, до 7 проверок в день. В платной версии есть возможность автоматизированных проверок с помощью API, также разработчики выпустили плагины для популярных CMS, что довольно удобно. Удобная реализация проверки текста по имени сайта с подбором страниц, однако, эта функция доступна только для зарегистрированных пользователей.

2. Text.ru — дизайн сайта придется по душе пользователям, которые помнят времена доступа в интернет по dial-up модему. Но при всей своей архаичности, функционал сайта идет в ногу со временем. Кроме проверки на уникальность также доступна масса полезных сервисов для анализа контента — проверка орфографии, подбор синонимов, анализ водности и заспамленности. Для проверки сайта по url или использования API придется зарегистрироваться. Сайт показывает сколько проверок в очереди перед вами, из-за чего временами на получение результата может уйти довольно внушительное время.

3. Copyscape — отличный сервис для проверки как русскоязычного, так и англоязычного контента. Работает очень шустро, очередей не замечено. Однако, просто проверить только что написанный текст у вас не получится — нужно ввести ссылку на страницу в сети, где он размещен. Данная особенность порой сводит на нет все преимущества работы сервиса. Также имеет ограничение по количеству проверок в бесплатной версии.

4. Pr-cy — без регистрации не дает поверить текст длиной более 1000 символов, временами даже на правильный ввод капчи реагирует сообщением об ошибке. Огромный минус в том, что сервис показывает только доменное имя источника заимствования, а не конкретную страницу. То есть вам еще нужно будет приложить усилия для нахождения непосредственно страницы с совпадающим контентом на том домене, что показывает pr-cy. В общем юзабилити на уровне.

5. Антиплагиат — после регистрации доступна загрузка файла с текстом, а также классическая проверка текста. Скорость проверки оставляет желать лучшего. Очень подозрительно дает 100% уникальности и не находит заимствований для тех текстов, уникальность которых была не так однозначна для остальных вышеперечисленных сервисов.

Скорость проверки оставляет желать лучшего. Очень подозрительно дает 100% уникальности и не находит заимствований для тех текстов, уникальность которых была не так однозначна для остальных вышеперечисленных сервисов.

6. Plagiarisma — до регистрации функционал крайне беден: проверка происходит только по индексу Yahoo, на каких сайтах найдены совпадения вы не увидите. После регистрации возможна проверка по индексу Google, проверка по url и загрузка файла с текстом. Даже после регистрации сохраняется ограничение по длине анализируемого текста — всего 2000 символов. По утверждению создателей, сервис поддерживает 190 языков.

7. Advego — некогда лучший и любимый многими сервис по проверке контента. Онлайн версия от advego просит раскошелиться — необходимо купить определенное количество символов, при каждой проверке с вашего баланса будет вычитаться количество символов анализируемого текста. Споры по поводу актуальности алгоритмов Advego не утихают по сей день. Тем не менее для комплексного анализа текстового контента этот сервис вполне достоин занять свое место в вашем наборе инструментов.

Тем не менее для комплексного анализа текстового контента этот сервис вполне достоин занять свое место в вашем наборе инструментов.

Резюме:

Идеальных онлайн сервисов для проверки на плагиат не существует. У опытных оптимизаторов и копирайтеров есть большие вопросы к алгоритмам работы каждого из описанных в данной статье инструментов. Мы советуем попробовать каждый и сделать ваши тексты интересными и уникальными. Желаем удачи!

Комментарии

Комментарии

Проверенные сайты антиплагиата — 5 лучших сервисов

Антиплагиат ру, без сомнения, уникальный ресурс, первый появившийся в стране онлайн сервис, который охватил все ВУЗы России. Бесспорный лидер в своей области.

На сайте антиплагиат ру, можно быстро и бесплатно проверить текст на антиплагиат, причем любого объема. Есть небольшие ограничения при работа с бесплатной версией

1) Загружать бесплатно в антиплагиат ру можно только в пдф или тхт формате

2) После каждой проверки, нельзя сразу проверить вторую работу, нужно подождать 6 минут

Подходит ли сайт антиплагиат ру студентам?

Сайт антиплагиат ру, без сомнения, это лучший сайт антиплагиата для студентов, и причин тому множество.

На начало 2021 года, 95% вузов России используют при проверке именно сайт антиплагиат ру(точнее они используют расширенную, полную версию сайта антиплагиат ру, которая называется Антиплагиат ВУЗ, но мы их будем назваться под одним названием)

Поэтому на вопрос, какой проверенный антиплагиат использовать для проверки текста на уникальность студенту – отвечаем однозначно, сайт Антиплагиат ру.

Это бесплатный сайт, без сомнения проверенный временем, и самое главное именно им пользуются преподаватели.

Основной акцент при анализе документов на уникальность, антиплагиат ру делает именно на курсовые и дипломные работы, которые выложены в открытом доступе в интернете. Это еще одни причина того, почему он показывает правильный процент.

Еще одним плюсом того, почему стоит использовать антиплагит ру студенту, это тот факт, что антиплагиат ру, показывает более высокую оригинальность, по сравнению с другими системами проверки,о которых мы расскажем дальше. Т.е проходную планку процентов, вам набрать будет проще.

Мы подготовили для вас полную инструкцию пользования сайтом Антиплагиат ру.

Подходит ли сайт Антиплагиат ру веб-мастерам и программистам?

Вот тут уже картина совершенно иная. Сайт антиплагиат ру совершенно не пригоден для работы веб-мастеров и программистов.

Все дело в том, что при проверке уникальности текста для учебных заведений, важна проверка именно по базам курсовых и дипломных работ, а веб-мастерам, эти базы интересны в последнюю очередь.

Веб-мастерам важнее проанализировать весь интернет, все текста рунета, и сделать статью для сайта уникальной во всей сети. Только так, ее можно продвинуть в поисковиках Яндекс и ГУГЛ.

А антиплагиат ру, акцент делает именно на базы курсовых и дипломных работ, и зачастую контент со страниц обычных сайтов в антиплагиат ру проскакивает, и показывает высокую оригинальность.

Одним словом, веб мастера и программисты не должны использовать при проверке своего контента, пусть даже и проверенный сайт антиплагиат ру, иначе они могут пойти по неверному пути. Дело не в репутации сайта, а в системе его анализа.

Проверить работу в Антиплагиат ВУЗ

Антиплагиат вуз, как мы уже ранее говорили, это копия сайта Антиплагиат ру. Ей пользуются преподаватели вузов, при проверке работ на уникальность.

массовая проверка уникальности списка URL-адресов (страниц сайта) между собой

BatchUniqueChecker предназначен для массовой проверки уникальности содержимого на страницах из списка URL-адресов или файла Sitemap.

Показать различия между выбранными URL-адресами

Проверка уникальности двух текстов

Настройки

Условия использования: Freeware

Основные характеристики

- Проверить уникальность содержимого в URL из списка любого размера

- Импортировать список URL-адресов из файла Sitemap.xml или добавить вручную

- Инструмент может использоваться для анализа только «значимого» текста (внутри абзацев HTML) с веб-страниц.

- Определите различия между любыми двумя выбранными URL-адресами

- Установка длины черепицы (от 1 до 10 слов на черепицу)

- Экспорт отчетов в Excel (формат CSV)

Отличия от аналогов

- Многопоточность и быстрая проверка URL

- Portable format (работает без установки с любого внутреннего или внешнего накопителя)

- Бесплатное программное обеспечение

История версий

Версия 1.3 (сборка 21), 25.02.2021:

- Исправлена некорректная работа программы с потоками

- количество ошибок проверки URL должно быть значительно меньше

Версия 1.3 (сборка 20), 07.12.2020:

- Исправлена проблема с некорректным использованием пауз между запросами к веб-страницам

- доработан и улучшен перевод

- обновленный сплиттер (визуальный делитель)

Версия 1. 2 (сборка 19), 27.10.2020:

2 (сборка 19), 27.10.2020:

- улучшенный алгоритм определения «содержательных» текстов

- мы добавили возможность перепроверки URL-адресов завершенных с ошибками

- мы добавили возможность отображать URL-адреса, наиболее близкие по уникальности к выбранному

- добавлено сравнение уникальности двух произвольных текстов (вкладка Настройки)

Версия 1.1 (сборка 16), 25.10.2020:

- мы добавили два способа получения контента для проверки уникальности: полнотекстовый поиск (PlainText) и «осмысленный» (содержательные предложения и разделы текста) Контент веб-страницы

- легче загружать благодаря поддержке User-Agent

- теперь можно отключить стоп-слова

Версия 1.0 (сборка 5), 14.10.2020:

- многопоточная проверка страниц в списке URL (до 10 потоков одновременно)

- импортировать URL-адреса из Sitemap.xml или txt-файла или вставить их вручную из буфера обмена

- сравнить любые два URL-адреса и отобразить их различия

- уникальность URL визуализируется разными цветами в таблице результатов и на графике

- экспорт результатов в Excel (CSV)

Минимальные системные требования

— 1 ГБ ОЗУ (рекомендуется 8 ГБ и больше)

— Microsoft Windows 10/8/7 / Vista / XP

— Интернет

Твиттер

<< Назад

Как проверить дублированный контент: инструменты и советы

Вы, наверное, знаете, что ваш сайт всегда должен содержать оригинальный контент. Если ваш сайт содержит дублированный контент, это огромная ошибка, которая может навредить вашему рейтингу и репутации. Плагиат или выдача чужой работы за свою без разрешения недопустимы как в Интернете, так и в автономном режиме. Дублированный контент может привести к тому, что Google оштрафует вас, понизив рейтинг вашей страницы или полностью исключив вашу веб-страницу из результатов поиска.Это вообще противоречит цели публикации контента.

Еще одна возможность, которую вы должны учитывать, заключается в том, что другие могут дублировать контент на вашем сайте и пытаться использовать его без вашего разрешения. Эти недобросовестные маркетологи могут откровенно использовать контент, который вы создали на их веб-сайтах, даже не спрашивая вас и не сообщая вам об этом, и в конечном итоге они могут превзойти вас в рейтинге поисковых систем.

Как определяется повторяющееся содержимое?

Дублированный контент — это контент, который появляется более чем в одном месте в Интернете, то есть на разных веб-сайтах.Если вы публикуете свой собственный контент более чем в одном месте, у вас будет дублированный контент. Если вы копируете чужой контент на свой сайт или они публикуют ваш на своем сайте, это дублированный контент.

Поисковым системам может быть сложно определить, какой контент более релевантен запросу в поисковой системе, когда контент слишком похож. Цель поисковых систем — предоставить пользователям наилучшие возможные результаты при поиске определенного термина. Google и другие поисковые системы могут исключить дублирующийся контент из своих поисковых запросов.

Некоторые причины дублирования содержимого

Во многих случаях использование дублированного контента не является преднамеренным или преднамеренным. Google относится к дублированному контенту как к идентичным или «в значительной степени похожим» блокам текста внутри или между доменами. Примеры не вредоносного дублированного контента включают описания товаров в магазине и версии веб-страниц только для печати.

Примеры не вредоносного дублированного контента включают описания товаров в магазине и версии веб-страниц только для печати.

Умышленное дублирование контента — другое дело. Когда один и тот же контент используется в нескольких доменах в попытке увеличить трафик или манипулировать рейтингом в поисковых системах, это может расстраивать людей, которые пытаются искать информацию и в конечном итоге получают один и тот же контент в нескольких местах.Вот почему поисковые системы делают все возможное, чтобы воспрепятствовать этой практике.

Использование Google для проверки дублированного содержания

Один из быстрых способов проверить, может ли страница считаться дублирующейся, — это скопировать около десяти слов из начала предложения и затем вставить их с кавычками в Google. На самом деле это рекомендованный Google способ проверки.

Если вы протестируете это для страницы на своем веб-сайте, вы ожидаете, что будет отображаться только ваша веб-страница и, в идеале, без других результатов.

Если другие веб-сайты отображаются не хуже вашего, Google намекает, что считает, что исходный источник — это результат, который он показывает первым. Если это не ваш веб-сайт, возможно, у вас проблема с дублированием контента.

Повторите этот процесс, протестировав несколько случайных коротких предложений текста с вашей веб-страницы в Google.

Бесплатные инструменты для проверки дублированного содержимого

Когда вы пишете свой контент, вы можете непреднамеренно сделать его слишком похожим на уже опубликованный контент.Всегда полезно дважды проверять все, что вы пишете, с помощью средств проверки на плагиат, чтобы убедиться, что ваш контент рассматривается как уникальный. Некоторые из этих инструментов доступны бесплатно.

Вот несколько хороших бесплатных инструментов, которые можно использовать для проверки дублированного контента:

Copyscape — этот инструмент может быстро сравнить написанное вами содержимое с уже опубликованным за считанные секунды. Инструмент сравнения выделит контент, который отображается как повторяющийся, и сообщит вам, какой процент вашего контента соответствует уже опубликованному контенту.

Plagspotter — этот инструмент может определять повторяющиеся страницы контента в Интернете. Это отличный инструмент для поиска плагиатов, укравших ваш контент. Это также позволяет вам еженедельно автоматически отслеживать ваши URL-адреса для выявления дублирующегося контента.

Duplichecker — этот инструмент быстро проверяет оригинальность контента, который вы планируете разместить на своем сайте. Зарегистрированные пользователи могут выполнять до 50 поисков в день.

Siteliner — это отличный инструмент, который может проверять весь ваш сайт один раз в месяц на наличие дублированного контента.Он также может проверять неработающие ссылки и определять страницы, которые наиболее заметны для поисковых систем.

Smallseotools — доступны различные инструменты SEO, в том числе средство проверки на плагиат, которое идентифицирует фрагменты идентичного контента.

И если вы хотите копнуть глубже, эти ссылки также предлагают больше инструментов по доступной цене.

Премиум-инструменты для проверки на плагиат

Премиум-программы для проверки на плагиат имеют возможность проверять дублированный контент с помощью передовых алгоритмов.Они дают вам уверенность в том, что ваша работа не будет приписана тому, кто ее не писал.

Премиум-инструменты для борьбы с плагиатом обычно предлагают отчеты, которые могут подтвердить подлинность. Будущие выводы о том, что ваша работа не является оригинальной, могут противоречить этим отчетам, которые можно сохранить в формате PDF.

Примеры дополнительных инструментов для проверки дублированного контента:

Grammarly — их премиальный инструмент предлагает как средство проверки на плагиат, так и проверку грамматики, выбора слов и структуры предложения.

Plagium — Предлагает бесплатный быстрый поиск или глубокий поиск премиум-класса.

Plagiarismcheck.org — обнаруживает точные совпадения и перефразированный текст.

Ваш контент был очищен?

Содержимое вашего веб-сайта должно быть полностью оригинальным, и указанные выше инструменты могут помочь вам убедиться, что вы случайно не сделали свой контент слишком похожим на контент, который появляется на чужом веб-сайте.

Другая причина постоянно проверять дублирующийся контент — это веб-сайты, которые намеренно крадут контент из чужого блога, чтобы использовать его самостоятельно.Обычно это делается с помощью автоматизированного программного обеспечения. Если у вас есть привычка проверять контент на своем собственном сайте, вы можете обнаружить, что часть его была очищена. Как можно ловить парсеры контента? Что делать, если вы обнаружите, что ваш контент дословно опубликован на чужом сайте?

Способы отлова скребков

Регулярное использование премиальных инструментов для борьбы с плагиатом может помочь вам найти контент, который вы написали на чужом сайте.Есть еще несколько способов отловить скопированный контент.

Обратные ссылки в WordPress могут отображаться в спаме, если вы используете Askimet. Когда ваш контент всегда включает ссылки на некоторые из ваших других сообщений, вы можете найти таким образом парсеры контента.

Воспользуйтесь инструментами для веб-мастеров и проверьте ссылки на свой сайт. Когда у вас есть большое количество ссылок с определенного сайта, вы можете обнаружить, что часть вашего контента была скопирована на их. Единственный способ быть уверенным — это посетить их сайт и проверить, какие страницы ссылаются на ваш сайт.Вы можете найти свой собственный контент на их сайте.

Используйте Google Alerts, чтобы получать уведомления, если какие-либо заголовки ваших сообщений появляются в Интернете после того, как ваш контент уже был опубликован.

Чем больше вы утвердитесь в качестве авторитета в своей нише, тем больше вы можете обнаружить, что те, кто еще не утвердил свой собственный голос или авторитет, хотят позаимствовать ваш. Это позволяет им предоставлять авторитетную информацию в своем блоге, не прилагая усилий для создания качественного контента.

Что делать с парсерами контента

Очистка содержимого неэтична. Как только вы обнаружите, что ваш контент был очищен, у вас есть несколько вариантов того, что вам следует делать.

Свяжитесь с владельцем веб-сайта, на котором опубликовано ваше содержание, и сообщите ему, что вы нашли его на его сайте. Владелец сайта может не знать, что на его сайт был добавлен украденный контент, поэтому дайте ему возможность сомневаться. Вы можете связаться с ними через их контактную форму или через любую из социальных сетей, в которых они участвуют.

Если это качественный сайт, дайте им возможность поддерживать контент в актуальном состоянии, указав вас как автора и ссылку на ваш сайт. Другой вариант — предложить написать исправленную статью в обмен на ссылку. Если это некачественный сайт, сообщите им, что вы хотите, чтобы ваш контент был немедленно удален.

Если нет очевидного способа связаться с владельцем веб-сайта, выполните поиск в Whois. Это, вероятно, позволит вам узнать, кто они, если только он не зарегистрирован в частном порядке. Если вы все еще не можете узнать, кто является владельцем сайта, вы сможете узнать, кто его размещает, с помощью бесплатного инструмента Whoishostingthis.com. Свяжитесь с хостинговой компанией и сообщите им, что владелец веб-сайта публикует контент, защищенный авторским правом. Компании, предоставляющие веб-хостинг, серьезно относятся к подобным жалобам и своевременно предлагают помощь.

Защита содержимого с помощью DMCA

Вы обладаете авторскими правами на любой исходный контент, который вы публикуете на своем сайте. Один из способов защитить себя — разместить на своем сайте значок DMCA. DMCA гласит, что они бесплатно удалят ваш контент, если ваш контент будет украден, пока он защищен одним из их значков.

DMCA помогает сдерживать воров и предлагает инструменты, которые помогут вам найти неавторизованные копии вашего контента на чужом сайте. Они быстро удалят плагиат, включая изображения и видео.

Последние мысли о повторяющемся содержании

Люди, которые выходят в Интернет за информацией, ожидают найти оригинальный и полезный контент, и именно это они должны быть в состоянии найти. По возможности следует избегать дублирования контента. Контент должен быть хорошо написан и уникален, чтобы читатели могли получить максимум удовольствия от работы в сети.

Связанные

Уникальный контент: что вы должны знать

Краткое объяснение:

Уникальный контент — это термин, относящийся к поисковой оптимизации (SEO). Это означает, что контент является оригинальным и больше нигде не дублируется. Уникальный контент играет ключевую роль в поисковом рейтинге, потому что алгоритмы поиска высоко оценивают уникальный контент и могут наказывать веб-сайты за публикацию дублированного контента.

Подробное объяснение:

Противоположность уникальному контенту — это дублированный контент.Дублированный контент — это идентичный контент, который публикуется более чем на одном веб-сайте. В то время как уникальный контент может улучшить позицию веб-сайта на страницах рейтинга поисковых систем, дублированный контент может уменьшить его. Фактически, Google может даже удалять сайты с повторяющимся содержанием из своего поискового индекса.

Люди ищут информацию в Интернете, и поисковые системы, такие как Google, хотят предоставить своим пользователям наилучшее соответствие их содержанию. Они разработали сложные алгоритмы для определения сайтов с наивысшим качеством контента, чтобы обеспечить наилучший пользовательский интерфейс для своих клиентов.Когда веб-сайты пытаются обмануть алгоритмы, дублируя контент, чтобы они могли занять более высокое место в результатах поиска, Google наказывает их.

Чтобы занять высокое место в поисковых системах, веб-сайты должны оптимизировать свой контент для SEO, используя ключевые слова и обращая внимание на качество и релевантность своего контента. Хотя у них может возникнуть соблазн попытаться обмануть алгоритм, Google и другие поисковые системы вкладывают много времени и ресурсов, чтобы убедиться, что они сопоставляют правильный контент поисковому запросу.Создавая уникальный контент, который актуален и интересен читателю, сайты имеют больше шансов подняться на вершину рейтинга.

Уникальный контент от Textbroker

Textbroker специализируется на создании уникального контента, оптимизированного для SEO, и помогает компаниям подняться на вершину рейтинга поисковых систем. На рынке авторов есть эксперты по созданию контента практически по любой теме, который компании публикуют на своих собственных веб-сайтах или в каналах социальных сетей. Предоставляя оригинальную и интересную для читателей информацию, компании могут увеличить посещаемость своих веб-сайтов и увеличить продажи.Уникальный контент имеет абсолютный приоритет в Textbroker. Компания использует Copyscape, чтобы гарантировать, что нигде больше не существует контента и что все авторы создают оригинальные статьи.

Советы по созданию уникального контента

Написать уникальный контент несложно. Следуйте этим советам, чтобы контент был оригинальным и уникальным:

- Никогда не копируйте текст откуда-нибудь. Избегайте плагиата, цитируя исследования и используя свои слова для описания концепции.

- Всегда используйте несколько источников при исследовании.

- Придайте тексту уникальную структуру.

- Используйте свой неповторимый стиль.

- Используйте свои собственные рассуждения. Объясняйте вещи так, как вы их понимаете.

Заключение

Хотя дублированный контент может снизить рейтинг поиска, уникальный контент может его улучшить. Фактически, это необходимо для высокого ранжирования в органических результатах поиска. Такие компании, как Textbroker, предоставляют уникальные услуги по написанию контента, чтобы помочь компаниям создавать высококачественный контент, оптимизированный для поиска.

Избегайте дублирования содержимого | Центр поиска Google | Разработчики Google

Дублированный контент обычно относится к основным блокам контента внутри или между доменами. которые либо полностью соответствуют другому контенту, либо в значительной степени похожи. В основном это не обманчивое происхождение. Примеры не вредоносного дублированного контента могут включать:

- Дискуссионные форумы, которые могут создавать как обычные, так и урезанные страницы, ориентированные на мобильные устройства

- Товары в интернет-магазине, которые отображаются или связаны по нескольким отдельным URL-адресам

- Версии веб-страниц только для печати

Если ваш сайт содержит несколько страниц с практически идентичным содержанием, существует ряд способы указать предпочтительный URL для Google.(Это называется «канонизацией».) Больше информации о канонизация.

Однако в некоторых случаях контент намеренно дублируется между доменами в попытке манипулировать рейтингом в поисковых системах или получать больше трафика. Подобные обманчивые практики могут приводит к ухудшению пользовательского опыта, когда посетитель видит практически тот же контент повторяется в наборе результатов поиска.

Google изо всех сил пытается индексировать и показывать страницы с четкой информацией.Эта фильтрация означает,

например, если на вашем сайте есть «обычная» и «печатная» версии каждой статьи, и

ни один из них не заблокирован с помощью noindex тег, мы выберем один из них для включения в список. В тех редких случаях, когда Google считает, что

дублированный контент может быть показан с намерением манипулировать нашим рейтингом и обманывать наших пользователей,

мы также внесем соответствующие корректировки в индексирование и ранжирование задействованных сайтов. В виде

в результате может пострадать рейтинг сайта или он может быть полностью удален из

Индекс Google, и в этом случае он больше не будет отображаться в результатах поиска.

Есть несколько шагов, которые вы можете предпринять для упреждающего решения проблем с дублирующимся контентом и обеспечения чтобы посетители видели то, что вы им хотите.

- Используйте 301s : Если вы реструктурировали свой сайт, используйте 301 редирект («RedirectPermanent») в вашем файле .htaccess, чтобы правильно перенаправлять пользователей, робота Google и других пауков. (В Apache, вы можете сделать это с помощью файла .htaccess; в IIS это можно сделать через административную приставка.)

- Будьте последовательны : Старайтесь, чтобы ваши внутренние ссылки были последовательными. Например,

не ссылайтесь на

http://www.example.com/page/иhttp://www.example.com/pageиhttp://www.example.com/page/index.htm. - Используйте домены верхнего уровня : чтобы помочь нам обслуживать наиболее подходящую версию

document, по возможности используйте домены верхнего уровня для обработки контента для конкретной страны. Были

с большей вероятностью будет знать, что

http: // www.example.deсодержит контент, ориентированный на Германию, например, чемhttp://www.example.com/deилиhttp://de.example.com. - Тщательно распространяйте информацию : если вы распространяете свой контент на других сайтах, Google

всегда будет показывать версию, которая, по нашему мнению, наиболее подходит для пользователей в каждом заданном поиске,

который может быть или не быть той версией, которую вы предпочитаете. Однако полезно убедиться, что каждый

сайт, на котором синдицируется ваш контент, содержит обратную ссылку на вашу исходную статью.Ты

также можете попросить тех, кто использует ваш синдицированный материал, использовать

noindexтег, чтобы поисковые системы не индексировали свою версию содержания. - Минимизировать повторение шаблонов : Например, вместо включения длинный текст об авторских правах внизу каждой страницы, включая очень краткое изложение, а затем ссылка на страницу с более подробной информацией. Кроме того, вы можете использовать Параметр Инструмент обработки, чтобы указать, как вы хотите, чтобы Google обрабатывал параметры URL.

- Избегайте публикации заглушек : пользователям не нравится видеть «пустые» страницы, поэтому избегайте

заполнители там, где это возможно. Например, не публикуйте страницы, для которых у вас еще нет

реальный контент. Если вы действительно создаете страницы-заполнители, используйте

noindexтег, чтобы заблокировать индексирование этих страниц. - Изучите свою систему управления контентом : Убедитесь, что вы знакомы с как контент отображается на вашем веб-сайте.Блоги, форумы и связанные с ними системы часто показывают один и тот же контент в нескольких форматах. Например, запись в блоге может появиться на домашней странице блог, на странице архива и на странице других записей с таким же ярлыком.

- Свернуть похожее содержимое : Если у вас много похожих страниц, рассмотрите возможность расширения каждой страницы или объединения страниц в одну. Например, если у вас есть сайт о путешествиях с отдельными страницами для двух городов, но с одинаковой информацией на обеих страницах, вы можете либо объединить страницы об обоих городах в одну, либо развернуть каждый страница, содержащая уникальный контент о каждом городе.

Google не рекомендует блокировать доступ сканеров к дублированному контенту на вашем веб-сайте,

будь то файл robots.txt или другие методы. Если поисковые системы не могут сканировать страницы с

дублированный контент, они не могут автоматически определить, что эти URL-адреса указывают на один и тот же контент

и поэтому им придется рассматривать их как отдельные уникальные страницы. Лучшее решение

позволяет поисковым системам сканировать эти URL-адреса, но помечать их как дубликаты с помощью rel = "canonical" элемент ссылки, инструмент обработки параметров URL или 301 редирект.В случаях, когда дублирующийся контент приводит к тому, что мы сканируем слишком большую часть вашего веб-сайта, вы также можете

настроить сканирование

настройку скорости в Search Console.

Дублированный контент на сайте не является основанием для действий на этом сайте, если только не выяснится, что Цель дублированного контента — вводить в заблуждение и манипулировать результатами поиска. Если ваш сайт страдает от проблем с дублированием контента, и вы не следуете перечисленным советам выше, мы хорошо поработали над выбором версии контента, который будет отображаться в наших результатах поиска.

Однако, если наш обзор показал, что вы использовали обман, и ваш сайт был удален из результатов поиска, внимательно просмотрите свой сайт. Если ваш сайт был удален из результатов поиска, просмотрите наш веб-мастер Рекомендации для получения дополнительной информации. После внесения изменений и уверенности в том, что ваш сайт больше не нарушает наши правила, отправьте ваш сайт на пересмотр.

В редких случаях наш алгоритм может выбрать URL-адрес внешнего сайта, на котором размещается ваш контент без вашего разрешения.Если вы считаете, что другой сайт копирует ваш контент в нарушение закона об авторском праве вы можете обратиться к хозяину сайта с просьбой об удалении. В Кроме того, вы можете попросить Google удалить страницу, нарушающую авторские права, из результатов поиска, подача запроса в соответствии с Законом о защите авторских прав в цифровую эпоху.

Как бороться с дублирующимся контентом (включая проблемы, созданные вашей CMS)

Вы когда-нибудь беспокоились о дублировании контента?

Это может быть что угодно: какой-нибудь шаблонный текст на вашем веб-сайте.Или описание продукта на своей веб-странице электронной коммерции, которое вы позаимствовали у первоначального продавца. Или, может быть, цитата, которую вы скопировали из любимого сообщения в блоге или авторитетного источника в вашей нише.

Как бы вы ни старались предложить 100% уникальный контент, у вас ничего не получится.

Дублированный контент входит в пятерку основных проблем SEO, с которыми сталкиваются сайты, особенно сейчас, когда Google применил свое Panda Update.

Это правда: вы НЕ МОЖЕТЕ удалить все экземпляры дублированного контента на своих веб-страницах, даже если вы используете параметр rel canonical tag url.

Мэтт Каттс из Google заявил, что дублированный контент постоянно встречается в сети, от сообщений в блогах до веб-страниц и социальных сетей. Каттс заявил,

25-30% Интернета — это дублированный контент .

И Google это понимает.

Таким образом, не существует наказания GOOGLE ДУБЛИКАЦИОННОГО КОНТЕНТА.

Да, вы правильно прочитали.

Google не наказывает веб-сайты, использующие дублированный контент.То, что Google преследует сайты с X% дублированного контента, — это еще один миф SEO.

Теперь вы, вероятно, задаетесь вопросом: если Google не наказывает веб-сайты с дублированным содержанием, в чем вся суета вокруг ? Зачем нужны относительные канонические теги и управление контентом, чтобы у вас не было дубликатов?

Хотя Google не наказывает сайты за дублированный контент, он не поощряет его. Давайте посмотрим, почему Google не одобряет дублирование контента и их Panda Update, а затем рассмотрим различные способы решения проблем с дублированием контента на вашем сайте.От параметров URL до канонических тегов и идентификаторов сеансов — есть много способов уменьшить проблемы с дублированием контента.

Прежде чем мы начнем, давайте посмотрим, как Google определяет повторяющийся контент.

Что такое дублированный контентВот определение дублированного содержания в Google:

Дублированный контент обычно относится к основным блокам контента внутри или между доменами, которые либо полностью соответствуют другому контенту, либо в значительной степени похожи.

Как вы можете понять из определения Google, Google выделяет два типа дублированного контента: первый тип встречается в одном домене, а другой — в нескольких доменах.

Вот несколько примеров, которые помогут понять дублированный контент и разные типы.

Экземпляры дублированного контента в одном доменеКак вы понимаете, дублированный контент такого типа встречается на вашем сайте электронной коммерции, в сообщениях в блогах или на веб-сайте.

Думайте о таком повторяющемся содержимом как об одном и том же содержимом, которое появляется на разных веб-страницах вашего сайта.

Может быть:

- Этот контент присутствует на вашем сайте в разных местах (URL).

- Или, возможно, он доступен разными способами (что приводит к другим параметрам URL). Например, это могут быть те же сообщения, которые отображаются при поиске по различным категориям и тегам на вашем сайте.

Давайте рассмотрим несколько примеров повторяющегося содержания различных типов на одном и том же сайте.

Содержание базовой плиты:Проще говоря, шаблонный контент доступен в разных разделах или веб-страницах вашего сайта.

Энн Смарти классифицирует содержимое Boilerplate как:

- (по всему сайту) глобальная навигация (главная, о нас и т. Д.)

- Определенные специальные области, особенно если они содержат ссылки (блогролл, навигационная панель)

- Разметка (javascript, идентификатор CC / имена классов, такие как верхний и нижний колонтитулы)

Если вы посмотрите на стандартный сайт, у него обычно есть верхний колонтитул, нижний колонтитул и боковая панель.В дополнение к этим элементам большинство CMS позволяют вам показывать ваши самые последние сообщения или самые популярные сообщения на вашей домашней странице.

Когда поисковые роботы просканируют ваш сайт, они поймут, что этот контент присутствует на вашем сайте несколько раз, и поэтому это действительно дублированный контент.

Но этот тип дублированного контента не вредит вашему SEO . Боты поисковых систем достаточно сложны, чтобы понимать, что намерение, стоящее за этим дублированием контента, не является злонамеренным.Итак, вы в безопасности.

Несовместимые структуры URL:Посмотрите на следующие URL-адреса —

www.yoursite.com/

yoursite.com

http://yoursite.com

http://yoursite.com/

https://www.yoursite.com

https://yoursite.com

Вам они кажутся одинаковыми?

Да, вы правы, целевой URL такой же. Итак, для вас они означают одно и то же. К сожалению, боты поисковых систем воспринимают их как разные URL-адреса.

Но когда боты поисковых систем сталкиваются с одним и тем же контентом на двух разных URL-адресах : http://yoursite.com и https://yoursite.com , они рассматривают это как дублированный контент.

Эта проблема относится и к параметрам URL, сгенерированным также для целей отслеживания:

http://yoursite.com/?utm_source=newsletter4&utm_medium=email&utm_campaign=holidays

Параметры URLс отслеживанием также могут вызывать проблемы с дублированием контента.

Локализованные домены:Предположим, вы обслуживаете разные страны и создали локализованные домены для каждой обслуживаемой страны.

Например, у вас может быть версия вашего сайта .de для Германии и версия .au для Австралии.

Естественно, что содержание обоих сайтов будет частично совпадать. Если вы не переведете свой контент для домена .de, поисковые системы обнаружат, что ваш контент дублируется на обоих сайтах.

В таких случаях, когда поисковик ищет вашу компанию, Google покажет любой из этих двух URL.

Google часто видит статус поисковика. Предположим, что поисковик находился в Германии. По умолчанию Google показывает только ваш домен .de. Однако Google может ошибаться.

Экземпляры дублированного контента на разных доменах Скопировано:Копирование содержания с сайта (без разрешения) является неправильным, и Google так считает. Если вы не предлагаете ничего, кроме дублированного контента, ваш сайт будет в опасности, особенно сейчас, когда идет обновление Panda Update.Google может вообще не показывать его в результатах поиска или сбрасывать ваш веб-сайт с первых нескольких страниц результатов.

Курирование контента:Курирование контента — это процесс поиска историй и создания сообщений в блогах, релевантных вашим читателям. Эти истории могут быть откуда угодно в Интернете — от веб-страниц до социальных сетей.

Поскольку сообщение о курировании контента составляет список фрагментов контента со всего Интернета, естественно, что сообщение содержит дублированный контент (даже если это просто дублированные заголовки).В большинстве сообщений в блогах также используются выдержки и цитаты.

Опять же, Google не считает это СПАМом.

Пока вы предоставляете некоторую информацию, свежий взгляд или объясняете вещи в своем собственном стиле, Google не будет рассматривать это дублирование контента как злонамеренное, освобождая вас от беспокойства о необходимости добавлять относительные канонические теги, идентификаторы сеанса и т. Д. .

Синдикация контента:Синдикация контента становится все более популярной тактикой управления контентом.Курата обнаружил, что идеальный комплекс контент-маркетинга включает в себя 10% синдицированного контента.

По словам Search Engine Land, « синдикация контента — это процесс продвижения вашего блога, сайта или видеоконтента на сторонние сайты в виде полной статьи, фрагмента, ссылки или эскиза. ”

Сайты, которые объединяют контент, предлагают его контент для публикации на нескольких сайтах. Это означает, что существует несколько копий любого синдицированного сообщения.Это также верно и в отношении социальных сетей.

Если вы знакомы с публикацией Хаффингтона, то знаете, что она допускает распространение контента. Каждый день он публикует истории со всего Интернета и переиздает их с разрешения.

Buffer также объединяет контент. Их содержание переиздается на таких сайтах, как Huffington Post, Fast Company, Inc. и других.

На следующем снимке экрана показан трафик, который такой синдицированный контент приносит на их сайт.

Хотя эти случаи считаются дублированным контентом, Google не наказывает их.

Лучший способ синдицировать контент — это попросить переиздающие сайты объявить вас оригинальным создателем контента, а также дать обратную ссылку на ваш сайт с соответствующим текстом привязки, т. Е. На исходный фрагмент контента.

Очистка содержимого:Очистка контента всегда является серой зоной, когда вы обсуждаете проблемы с дублированным контентом.

Википедия определяет парсинг веб-страниц (или парсинг контента) как:

Веб-скрапинг (сбор веб-данных или извлечение веб-данных) — это программный компьютерный метод извлечения информации с сайтов.

Интересно, что даже Google собирает данные, чтобы сразу предложить их в первой поисковой выдаче.

Итак, неудивительно, что твит Мэтта Катта,

Если вы видите, что URL-адрес парсера превосходит исходный источник контента в Google, сообщите нам об этом…

создавал довольно много шума.

Дэн Баркер ответил этим твитом:

@mattcutts Мне кажется, я заметил одного, Мэтт. Обратите внимание на сходство в тексте содержания:

Как видите.Google извлекает контент из лучших результатов и показывает его прямо в поисковой выдаче. Это, без сомнения, списание контента.

Таким образом, не во всех случаях отказываться от скрапинга как злоупотребления служебным положением.

Однако, если вы пойдете немного глубже, вы увидите, что Google не приемлет сайты-парсеры контента, как указано в их Panda Update.

Теперь, когда у вас есть разумное представление о том, что считается дублированным содержанием, давайте рассмотрим случаи, которые не являются случаями дублирования содержания, но веб-мастера часто беспокоятся о них.

Что не считается повторяющимся содержанием Переведено содержание:Переведенное содержимое НЕ ЯВЛЯЕТСЯ ДУБЛИРОВАННЫМ содержимым. Если у вас есть сайт, вы локализовали его для разных стран и перевели основной контент на местные языки, вы не столкнетесь с проблемами дублирования контента.

Но этот пример не так прост. Если вы используете для перевода какое-либо программное обеспечение, инструменты для веб-мастеров или даже переводчик Google, качество перевода не будет идеальным.

И, когда перевод не имеет естественного смысла и не требует индивидуальной проверки, Google может рассматривать контент как спам или дублированный контент.

Такой контент может быть легко идентифицирован как созданный с помощью программного обеспечения и может поднимать флажки для Google.

Лучший способ избежать этой проблемы — привлечь к работе переводчика-человека. Или сделайте достойную работу с хорошим программным обеспечением, а затем передайте его на рассмотрение профессиональному переводчику.

Просматривая переведенный контент, вы убедитесь, что качество контента на высшем уровне, и Google не сочтет его дублирующимся.

Но, если по какой-то причине вы не можете сделать ни одно из двух, вам следует заблокировать программно переведенный контент от просмотра ботами с помощью robots.txt. (Я покажу вам, как это сделать в следующих разделах.)

Мобильный контент сайта:Если у вас нет адаптивного сайта, возможно, вы разработали отдельную мобильную версию для своего основного сайта.

Итак, у вас будут разные URL, обслуживающие одно и то же содержание, например:

http: ваш сайт.com — Веб-версия

http.m.yoursite.com — Мобильная версия

Наличие одного и того же контента в версиях веб-сайта и мобильной версии сайта не считается дублированным контентом. Кроме того, вы должны знать, что у Google есть разные поисковые боты, которые сканируют мобильные сайты, поэтому вам не нужно беспокоиться об этом случае.

Google может выявлять экземпляры дублированного контента, созданного со злым умыслом. Вы никогда не подвергаетесь риску, если не пытаетесь обмануть систему. Но вам все равно следует избегать случаев дублирования контента, поскольку они влияют на ваш SEO.

Вот как дублированный контент может повлиять на SEO:

Проблемы, вызванные дублированием содержимого Проблема № 1 — Снижение популярности ссылкиКогда вы не устанавливаете единообразную структуру URL-адресов для своего сайта, вы в конечном итоге создаете и распространяете различные версии ссылок на свой сайт, когда начинаете построение ссылок.

Чтобы лучше понять это, представьте, что вы создали эпический ресурс, который произвел тонну входящих ссылок и трафика из множества идентификаторов сеансов.

Тем не менее, вы не видите, что авторитет страницы этого первоисточника повысился так, как вы ожидали.

Почему авторитет страницы не вырос, несмотря на все ссылки и тягу?

Возможно, это не так, потому что разные сайты с обратными ссылками ссылались на ресурс, используя разные версии URL ресурса.

Нравится:

http://www.yoursite.com/resource

http://yoursite.com/resource

http://yoursite.com/resource

и так далее…

Вы видите, как непонимание управления дублированным контентом разрушило ваши шансы на создание страницы с более высоким авторитетом?

Все потому, что поисковые системы не могли интерпретировать, что все URL-адреса указывают на одно и то же целевое местоположение.

Проблема № 2 — Отображение недружественных URL-адресовКогда Google встречает два идентичных или существенно похожих ресурса в сети, он предпочитает показать один из них поисковику. В большинстве случаев Google выберет наиболее подходящую версию вашего контента. Но не каждый раз это получается правильно.

Может случиться так, что для определенного поискового запроса Google может показать не очень красивую версию URL вашего сайта.

Например, если пользователь искал вашу компанию в Интернете, какой из следующих параметров URL-адреса вы хотели бы показать посетителю:

http: // ваш сайт.com

или http://yoursite.com/overview.html

Думаю, вам будет интересно показать первый вариант.

Но Google может просто показать второй.

Если бы вы в первую очередь избегали дублирования контента, не было бы этой путаницы, и пользователь увидел бы только лучшую и наиболее брендированную версию вашего URL.

Проблема № 3 — Отключение ресурсов сканера поисковой системыЕсли вы понимаете, как работают сканеры, вы знаете, что Google отправляет своих поисковых мета-роботов для сканирования вашего сайта в зависимости от частоты публикации свежего контента.

Теперь представьте, что сканеры Google посещают ваш сайт и просматривают пять URL-адресов только для того, чтобы обнаружить, что все они предлагают одинаковый контент.

Когда поисковые роботы обнаруживают и индексируют один и тот же контент в разных местах вашего сайта, вы теряете циклы сканирования. Понимая дублированный контент, поисковые роботы не будут сканировать ваш новый контент.

В противном случае эти циклы обходчика могли бы использоваться для обхода и индексации любого недавно опубликованного контента, который вы могли добавить на свой сайт.Это не только приведет к потере ресурсов сканера, но и нанесет ущерб вашему SEO.

Как Google обрабатывает дублированный контентКогда Google находит идентичные экземпляры контента, он решает показать один из них. Выбор ресурса для отображения в результатах поиска будет зависеть от поискового запроса.

Если на вашем сайте такое же содержание и вы также предлагаете его печатную версию, Google рассмотрит, заинтересован ли поисковик в печатной версии. Если это так, будет получена и представлена только печатная версия контента.

Вы могли заметить сообщения в поисковой выдаче о том, что другие похожие результаты не были показаны. Это происходит, когда Google выбирает одну из нескольких копий аналогичного контента на разных веб-страницах.

Дублированный контент не всегда рассматривается как СПАМ. Это становится проблемой только тогда, когда целью является злоупотребление, обман и манипулирование рейтингом в поисковых системах.

Google серьезно относится к дублированному контенту и может даже заблокировать ваш сайт, если вы попытаетесь обмануть поисковую систему, используя дублированный контент.

Политика Google в отношении дублированного содержания гласит: