Robots txt создать: Создание Robots.txt

Создать robots.txt онлайн

Чтобы активировать PRO версию программы достаточно только нажать и поделиться страницей через социальные сети выше.

Robots.txt является обыкновенным текстовым файлом, располагающимся в корне вашего сайта, просмотреть и отредактировать его можно используя любой текстовый редактор. В данном файлике записаны инструкции, которыми должны руководствоваться поисковые машины (роботы). Собственно, отсюда и пошло название этого документа. Инструкции эти указывают поисковику, что подлежит индексированию, а что трогать не нужно. Наверное, каждый вебмастер хотел бы, чтобы созданный им сайт как можно быстрее был проиндексирован поисковой системой, причем чтобы этот процесс прошел правильно и без ошибок. Поэтому, нужно понимать, что без грамотно составленного файла robots.txt это маловероятно, следовательно, нужно позаботиться о его создании. Конечно же вы можете самостоятельно написать данный файл, к тому же примеров в сети очень много. Но, намного правильнее и быстрее будет воспользоваться нашим инструментомЕсть ли какие-то отличия Robots.txt для Яндекса в сравнении с файлами для других роботов?

На самом деле каждая поисковая машина использует разные методы индексирования, и вообще работают они по-разному. Каждый поисковик имеет свои методики ранжирования, присвоения сайтам определенного места в своем списке. Однако, практически все они одинаково индексируют и понимают файл Robots.txt. Практика свидетельствует, что один файл Robots.txt подходит абсолютно ко всем поисковым системам и с ним не возникает никаких проблем.Есть ли возможность проверить существующий файл Robots.txt?

Если вы сами писали данный файл, или использовали другой генератор, и сомневаетесь в его работоспособности, то можете проверить его с помощью специального сервиса на нашем сайте. Если в ходе такой проверки обнаружатся те или иные проблемы, то вы с легкостью сможете сгенерировать новый файлик воспользовавшись нашим инструментом. Специалисты всегда рекомендуют проверять самодельные файлы Robots.txt с помощью уже проверенных генераторов, чтобы избежать возможных проблем в будущем.Создать Robots.txt онлайн — автоматическая генерация

Онлайн-генератор Robots.txt — поля заполняйте последовательно:

Откройте текстовый редактор, вставьте в него полученный результат и сохраните файл под именем robots.txt

После этого разместите файл в корневой директории вашего сайта. Файл должен быть доступен по ссылке http://ваш-сайт.com/robots.txt

Пояснения к атрибутам для файла Robots.txt

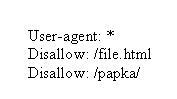

Директива «User-agent» — указывает для бота какой поисковой системы действуют расположенные ниже предписания. Файл Robots.txt можно создавать как с едиными для всех поисковых роботов указаниями, так и с отдельными предписаниями для каждого бота.

Директива «Disallow»

— данная директива указывает какие каталоги и фалы запрещено индексировать поисковикам. Если вы создаете отдельные предписания для каждого поискового бота, то для каждого такого предписания создаются отдельные правила «Disallow». Этой директивой можно запретить индексировать сайт полностью (Disallow: /) или запрещать индексирование отдельных каталогов. В случае запрета индексации отдельных директорий количество предписаний «Disallow» может быть неограниченным.Директива «Host» определяет главное зеркало сайта. Сайт может быть доступен по 2-м адресам: «с WWW» и «без WWW». Если файл Robots.txt отсутствует на сервере или в нем не заполнена запись «Host», роботы поисковых систем определяют главное зеркало для сайта по своему усмотрению, но если вы хотите сделать это самостоятельно вам следует указать это правило в директиве «Host».

Директива «Sitemap» указывает по какому пути находится файл Sitemap.xml (карта сайта). Этот файл существенно облегчает и ускоряет индексацию сайта роботами поисковых систем. Особенно важен файл Sitemap.xml для сайтов с большим количеством страниц и сложной структурой (высокий уровень вложенности).

Совет SEO-специалиста: Файл Robots.txt очень важен при продвижении сайта, т.к. он указывает поисковым системам Ваши пожелания по индексации/запрету_индексации разделов Вашего сайта. Поисковики не гарантируют соблюдение предписаний в robots.txt, но учитывают их при индексации. Для сайтов, созданных на популярных CMS, обычно есть готовые варианты файлов robots.txt, но если Вы делали доработки функционала, то может потребоваться его ручная корректировка.

Как составить robots.txt самостоятельно

Как правильно составить robots.txt и зачем он нужен, как закрыть индексацию через robots.txt и бесплатно проверить robots.txt с помощью онлайн-инструментов.

Как поисковики сканируют страницу

Роботы-краулеры Яндекса и Google посещают страницы сайта, оценивают содержимое, добавляют новые ресурсы и информацию о страницах в индексную базу поисковика. Боты посещают страницы регулярно, чтобы переносить в базу обновления контента, отмечать появление новых ссылок и их доступность.

Зачем нужно сканирование:

- Собрать данные для построения индекса — информацию о новых страницах и обновлениях на старых.

- Сравнить URL в индексе и в списке для сканирования.

- Убрать из очереди дублирующиеся URL, чтобы не скачивать их дважды.

Боты смотрят не все страницы сайта. Количество ограничено краулинговым бюджетом, который складывается из количества URL, которое может просканировать бот-краулер. Бюджета на объемный сайт может не хватить. Есть риск, что краулинговый бюджет уйдет на сканирование неважных или «мусорных» страниц, а чтобы такого не произошло, веб-мастеры направляют краулеров с помощью файла robots.txt.

Боты переходят на сайт и находят в корневом каталоге файл robots.txt, анализируют доступ к страницам и переходят к карте сайта — Sitemap, чтобы сократить время сканирования, не обращаясь к закрытым ссылкам. После изучения файла боты идут на главную страницу и оттуда переходят в глубину сайта.

Какие страницы краулер просканирует быстрее:

- Находятся ближе к главной.

Чем меньше кликов с главной ведет до страницы, тем она важнее и тем вероятнее ее посетит краулер. Количество переходов от главной до текущей страницы называется Click Distance from Index (DFI). - Имеют много ссылок.

Если многие ссылаются на страницу, значит она полезная и имеет хорошую репутацию. Нормальным считается около 11-20 ссылок на страницу, перелинковка между своими материалами тоже считается. - Быстро загружаются.

Проверьте скорость загрузки инструментом, если она медленная — оптимизируйте код верхней части и уменьшите вес страницы.

Все посещения ботов-краулеров не фиксируют такие инструменты, как Google Analytics, но поведение ботов можно отследить в лог-файлах. Некоторые SEO-проблемы крупных сайтов можно решить с помощью анализа лог-файлов который также поможет увидеть проблемы со ссылками и распределение краулингового бюджета.

Посмотреть на сайт глазами поискового бота

Robots.txt для Яндекса и Google

Веб-мастеры могут управлять поведением ботов-краулеров на сайте с помощью файла robots.txt. Robots.txt — это текстовый файл для роботов поисковых систем с указаниями по индексированию. В нем написано какие страницы и файлы на сайте нельзя сканировать, что позволяет ботам уменьшить количество запросов к серверу и не тратить время на неинформативные, одинаковые и неважные страницы.

В robots.txt можно открыть или закрыть доступ ко всем файлам или отдельно прописать, какие файлы можно сканировать, а какие нет.

Требования к robots.txt:

- файл называется «robots.txt«, название написано только строчными буквами, «Robots.TXT» и другие вариации не поддерживаются;

- располагается только в корневом каталоге — https://site.com/robots.txt, в подкаталоге быть не может;

- на сайте в единственном экземпляре;

- имеет формат .txt;

- весит до 32 КБ;

- в ответ на запрос отдает HTTP-код со статусом 200 ОК;

- каждый префикс URL на отдельной строке;

- содержит только латиницу.

Если домен на кириллице, для robots.txt переведите все кириллические ссылки в Punycode с помощью любого Punycode-конвертера: «сайт.рф» — «xn--80aswg.xn--p1ai».

Robots.txt действует для HTTP, HTTPS и FTP, имеет кодировку UTF-8 или ASCII и направлен только в отношении хоста, протокола и номера порта, где находится.

Его можно добавлять к адресам с субдоменами — http://web.site.com/robots.txt или нестандартными портами — http://site.com:8181/robots.txt. Если у сайта несколько поддоменов, поместите файл в корневой каталог каждого из них.

Как исключить страницы из индексации с помощью robots.txt

В файле robots.txt можно запретить ботам индексацию некоторого контента.

Яндекс поддерживает стандарт исключений для роботов (Robots Exclusion Protocol). Веб-мастер может скрыть содержимое от индексирования ботами Яндекса, указав директиву «disallow». Тогда при очередном посещении сайта робот загрузит файл robots.txt, увидит запрет и проигнорирует страницу. Другой вариант убрать страницу из индекса — прописать в HTML-коде мета-тег «noindex» или «none».

Google предупреждает, что robots.txt не предусмотрен для блокировки показа страниц в результатах выдачи. Он позволяет запретить индексирование только некоторых типов контента: медиафайлов, неинформативных изображений, скриптов или стилей. Исключить страницу из выдачи Google можно с помощью пароля на сервере или элементов HTML — «noindex» или атрибута «rel» со значением «nofollow».

Если на этом или другом сайте есть ссылка на страницу, то она может оказаться в индексе, даже если к ней закрыт доступ в файле robots.txt.

Закройте доступ к странице паролем или «nofollow» , если не хотите, чтобы она попала в выдачу Google. Если этого не сделать, ссылка попадет в результаты но будет выглядеть так:

Такой вид ссылки означает, что страница доступна пользователям, но бот не может составить описание, потому что доступ к ней заблокирован в robots.txt.

Содержимое файла robots.txt — это указания, а не команды. Большинство поисковых ботов, включая Googlebot, воспринимают файл, но некоторые системы могут его проигнорировать.

Если нет доступа к robots.txt

Если вы не имеете доступа к robots.txt и не знаете, доступна ли страница в Google или Яндекс, введите ее URL в строку поиска.

На некоторых сторонних платформах управлять файлом robots.txt нельзя. К примеру, сервис Wix автоматически создает robots.txt для каждого проекта на платформе. Вы сможете посмотреть файл, если добавите в конец домена «/robots.txt».

В файле будут элементы, которые относятся к структуре сайтов на этой платформе, к примеру «noflashhtml» и «backhtml». Они не индексируются и никак не влияют на SEO.

Если нужно удалить из выдачи какие-то из страниц ресурса на Wix, используйте «noindex».

Как составить robots.txt правильно

Файл можно составить в любом текстовом редакторе и сохранить в формате txt. В нем нужно прописать инструкцию для роботов: указание, каким роботам реагировать, и разрешение или запрет на сканирование файлов.

Инструкции отделяют друг от друга переносом строки.

Символы robots.txt

«*» — означает любую последовательность символов в файле.

«$» — ограничивает действия «*», представляет конец строки.

«/» — показывает, что закрывают для сканирования.

«/catalog/» — закрывают раздел каталога;

«/catalog» — закрывают все ссылки, которые начинаются с «/catalog».

«#» — используют для комментариев, боты игнорируют текст с этим символом.

User-agent: * Disallow: /catalog/ #запрещаем сканировать каталог

Директивы robots.txt

Директивы, которые распознают все краулеры:

User-agent

На первой строчке прописывают правило User-agent — указание того, какой робот должен реагировать на рекомендации. Если запрещающего правила нет, считается, что доступ к файлам открыт.

Для разного типа контента поисковики используют разных ботов:

- Google: основной поисковый бот называется Googlebot, есть Googlebot News для новостей, отдельно Googlebot Images, Googlebot Video и другие;

- Яндекс: основной бот называется YandexBot, есть YandexDirect для РСЯ, YandexImages, YandexCalendar, YandexNews, YandexMedia для мультимедиа, YandexMarket для Яндекс.Маркета и другие.

Для отдельных ботов можно указать свою директиву, если есть необходимость в рекомендациях по типу контента.

User-agent: * — правило для всех поисковых роботов;

User-agent: Googlebot — только для основного поискового бота Google;

User-agent: YandexBot — только для основного бота Яндекса;

User-agent: Yandex — для всех ботов Яндекса. Если любой из ботов Яндекса обнаружит эту строку, то другие правила User-agent: * учитывать не будет.

Sitemap

Указывает ссылку на карту сайта — файл со структурой сайта, в котором перечислены страницы для индексации:

User-agent: * Sitemap: http://site.com/sitemap.xml

Некоторые веб-мастеры не делают карты сайтов, это не обязательное требование, но лучше составить Sitemap — этот файл краулеры воспринимают как структуру страниц, которые не можно, а нужно индексировать.

Disallow

Правило показывает, какую информацию ботам сканировать не нужно.

Если вы еще работаете над сайтом и не хотите, чтобы он появился в незавершенном виде, можно закрыть от сканирования весь сайт:

User-agent: * Disallow: /

После окончания работы над сайтом не забудьте снять блокировку.

Разрешить всем ботам сканировать весь сайт:

User-agent: * Disallow:

Для этой цели можно оставить robots.txt пустым.

Чтобы запретить одному боту сканировать, нужно только прописать запрет с упоминанием конкретного бота. Для остальных разрешение не нужно, оно идет по умолчанию:

Пользователь-агент: BadBot Disallow: /

Чтобы разрешить одному боту сканировать сайт, нужно прописать разрешение для одного и запрет для остальных:

User-agent: Googlebot Disallow: User-agent: * Disallow: /

Запретить ботам сканировать страницу:

User-agent: * Disallow: /page.html

Запретить сканировать конкретную папку с файлами:

User-agent: * Disallow: /name/

Запретить сканировать все файлы, которые заканчиваются на «.pdf»:

User-agent: * Disallow: /*.pdf$

Запретить сканировать раздел http://site.com/about/:

User-agent: * Disallow: /about/

Запись формата «Disallow: /about» без закрывающего «/» запретит доступ и к разделу

http://site.com/about/, к файлу http://site.com/about.php и к другим ссылкам, которые начинаются с «/about».

Если нужно запретить доступ к нескольким разделам или папкам, для каждого нужна отдельная строка с Disallow:

User-agent: * Disallow: /about Disallow: /info Disallow: /album1

Allow

Директива определяет те пути, которые доступны для указанных поисковых ботов. По сути, это Disallow-наоборот — директива, разрешающая сканирование. Для роботов действует правило: что не запрещено, то разрешено, но иногда нужно разрешить доступ к какому-то файлу и закрыть остальную информацию.

Разрешено сканировать все, что начинается с «/catalog», а все остальное запрещено:

User-agent: * Allow: /catalog Disallow: /

Сканировать файл «photo.html» разрешено, а всю остальную информацию в каталоге /album1/ запрещено:

User-agent: * Allow: /album1/photo.html Disallow: /album1/

Заблокировать доступ к каталогам «site.com/catalog1/» и «site.com/catalog2/» но разрешить к «catalog2/subcatalog1/»:

User-agent: * Disallow: /catalog1/ Disallow: /catalog2/ Allow: /catalog2/subcatalog1/

Бывает, что для страницы оказываются справедливыми несколько правил. Тогда робот будет отсортирует список от меньшего к большему по длине префикса URL и будет следовать последнему правилу в списке.

Директивы, которые распознают боты Яндекса:

Clean-param

Некоторые страницы дублируются с разными GET-параметрами или UTM-метками, которые не влияют на содержимое. К примеру, если в каталоге товаров использовали сортировку или разные id.

Чтобы отследить, с какого ресурса делали запрос страницы с книгой book_id=123, используют ref:

«www.site. com/some_dir/get_book.pl?ref=site_1& book_id=123″

«www.site. com/some_dir/get_book.pl?ref=site_2& book_id=123″

«www.site. com/some_dir/get_book.pl?ref=site_3& book_id=123″

Страница с книгой одна и та же, содержимое не меняется. Чтобы бот не сканировал все варианты таких страниц с разными параметрами, используют правило Clean-param:

User-agent: Yandex Disallow: Clean-param: ref/some_dir/get_book.pl

Робот Яндекса сведет все адреса страницы к одному виду:

«www.example. com/some_dir/get_book.pl? book_id=123″

Для адресов вида:

«www.example2. com/index.php? page=1&sid=2564126ebdec301c607e5df»

«www.example2. com/index.php? page=1&sid=974017dcd170d6c4a5d76ae»

robots.txt будет содержать:

User-agent: Yandex Disallow: Clean-param: sid/index.php

Для адресов вида

«www.example1. com/forum/showthread.php? s=681498b9648949605&t=8243″

«www.example1. com/forum/showthread.php? s=1e71c4427317a117a&t=8243″

robots.txt будет содержать:

User-agent: Yandex Disallow: Clean-param: s/forum/showthread.php

Если переходных параметров несколько:

«www.example1.com/forum_old/showthread.php?s=681498605&t=8243&ref=1311″

«www.example1.com/forum_new/showthread.php?s=1e71c417a&t=8243&ref=9896″

robots.txt будет содержать:

User-agent: Yandex Disallow: Clean-param: s&ref/forum*/showthread.php

Host

Правило показывает, какое зеркало учитывать при индексации. URL нужно писать без «http://» и без закрывающего слэша «/».

User-agent: Yandex Disallow: /about Host: www.site.com

Сейчас эту директиву уже не используют, если в ваших robots.txt она есть, можно удалять. Вместо нее нужно на всех не главных зеркалах сайта поставить 301 редирект.

Crawl-delay

Раньше частая загрузка страниц нагружала сервер, поэтому для ботов устанавливали Crawl-delay — время ожидания робота в секундах между загрузками. Эту директиву можно не использовать, мощным серверам она не требуется.

Время ожидания — 4 секунды:

User-agent: * Allow: /album1 Disallow: / Crawl-delay: 4

Только латиница

Напомним, что все кириллические ссылки нужно перевести в Punycode с помощью любого конвертера.

Неправильно:

User-agent: Yandex Disallow: /каталог

Правильно:

User-agent: Yandex Disallow: /xn--/-8sbam6aiv3a

Пример robots.txt

Запись означает, что правило справедливо для всех роботов: запрещено сканировать ссылки из корзины, из встроенного поиска и админки, карта сайта находится по ссылке http://site.com/sitemap, ref не меняет содержание страницы get_book:

User-agent: * Disallow: /bin/ Disallow: /search/ Disallow: /admin/ Sitemap: http://site.com/sitemap Clean-param: ref/some_dir/get_book.pl

Составить robots.txt бесплатно поможет

инструмент для генерации robots.txt от PR-CY, он позволит закрыть или открыть весь сайт для ботов, указать путь к карте сайта, настроить ограничение на посещение страниц, закрыть доступ некоторым роботам и установить задержку:

Для проверки файла robots.txt на ошибки у поисковиков есть собственные инструменты:

Инструмент проверки файла robots.txt от Google позволит проверить, как бот видит конкретный URL. В поле нужно ввести проверяемый URL, а инструмент покажет, доступна ли ссылка.

Инструмент проверки от Яндекса покажет, правильно ли заполнен файл. Нужно указать сайт, для которого создан robots.txt, и перенести его содержимое в поле.

Файл robots.txt не подходит для блокировки доступа к приватным файлам, но направляет краулеров к карте сайта и дает рекомендации для быстрого сканирования важных материалов ресурса.

Как создать файл robots.txt для WordPress. 4 способа

Всем, привет! Сегодня небольшой пост — как автоматически создать файл robots.txt для WordPress? Друзья, вы можете создать правильный robots.txt для WordPress в пару кликов, прочитав данное руководство. Создание правильного файла robots.txt для WordPress очень важно. Благодаря ему поисковые системы будут знать, какие страницы индексировать и показывать в поиске. То есть, результаты поиска будут именно такими, как вам нужно, без дублирования страниц WordPress.

robots.txt для сайта WordPress

robots.txt для сайта WordPressЧитайте, дамы и господа — WordPress robots.txt: лучшие примеры для SEO.

Файл robots.txt для WordPress

WordPress robots.txt где лежит/находится? По умолчанию WordPress автоматически создает виртуальный файл robots.txt для вашего сайта. Таким образом, даже если вы ни чего не делали, на вашем сайте ВордПресс уже должен быть файл robots.txt. Вы можете проверить, так ли это, добавив /robots.txt в конец вашего доменного имени. Например, так https://ваш сайт/robots.txt

Виртуальный файл robots.txt в WordPress

Виртуальный файл robots.txt в WordPressПоскольку этот файл является виртуальным, вы не можете его редактировать. Однако, если вы хотите отредактировать свой файл robots.txt WordPress как надо, вам необходимо создать физический файл на вашем хостинге. Создайте свой правильный robots.txt для WordPress, который вы сможете легко редактировать по мере необходимости.

Как создать файл robots.txt для WordPress

Robots.txt — это текстовый файл, который содержит параметры индексирования сайта для роботов поисковых систем.

Файл robots.txt сообщает поисковым роботам, какие страницы или файлы на вашем сайте можно или нельзя обрабатывать.

Яндекс и Google

Для начала напомню вам, создать (и редактировать) файл robots.txt для WordPress можно вручную и с помощью плагина Yoast SEO

Создать файл robots.txt

Создать файл robots.txtДрузья, имейте ввиду, что Yoast SEO устанавливает свои правила по умолчанию, которые перекрывают правила существующего виртуального файла robots.txt ВордПресс:

Редактирование robots.txt в плагине Yoast SEO

Редактирование robots.txt в плагине Yoast SEOЧто должно быть в правильно составленного robots.txt? Идеального файла не существует. Например, сайт Yoast SEO использует такой robots.txt для WordPress:

User-agent: *И всё. Для большинства сайтов WordPress лучший пример. Вот даже скриншот сделал у Yoast SEO:

Правильный robots.txt на сайте yoast.com

Правильный robots.txt на сайте yoast.comЧто это значит? Директива говорит что, все поисковые роботы могут свободно сканировать этот сайт без ограничений. Этого хватит для правильной индексации сайта WP. А наша SEO специалисты рекомендуют почти тоже самое. Пример, правильно составленного robots.txt для WordPress сайта:

User-agent: *

Disallow:

Sitemap: https://mysite.ru/sitemap.xmlДанная запись в файле роботс делает доступным для индексирования полностью сайт для роботов всех известных поисковиков. Здесь, также прописан путь к карте сайта XML.

Создать и редактировать файл также можно при помощи All in One SEO Pack прямо из интерфейса SEO плагина. Модуль robots.txt в SEO-пакете Все в одном позволяет вам настроить файл robots.txt для вашего сайта, который переопределит файл robots.txt по умолчанию, который создает WordPress:

Применение плагина All in One SEO Pack

Применение плагина All in One SEO PackВы сможете управлять своим файлом Robots.txt, в разделе All in One SEO Pack — Robots.txt. Сам официальный сайт плагина использует вот такой роботс:

Пример файла Robots

Пример файла RobotsПравила по умолчанию, которые отображаются в поле Создать файл Robots.txt (показано на снимке экрана выше), требуют, чтобы роботы не сканировали ваши основные файлы WordPress. Для поисковых систем нет необходимости обращаться к этим файлам напрямую, потому что они не содержат какого-либо релевантного контента сайта.

А если вы не используете данные SEO модули, то предлагаю вам воспользоваться специальным плагином — Robots.txt Editor.

Плагин Robots.txt Editor

Плагин Robots.txt для WordPress — создание и редактирование файла robots.txt для сайта ВордПресс. Очень простой, лёгкий и эффективный плагин.

WordPress плагин Robots.txt Editor

WordPress плагин Robots.txt EditorПлагин Robots.txt Editor (редактор) позволяет создать и редактировать файл robots.txt на вашем сайте WordPress.

Плагин Robots.txt возможности

- Работает в сети сайтов Multisite на поддоменах;

- Пример правильного файла robots.txt для WordPress;

- Не требует дополнительных настроек;

- Абсолютно бесплатный.

Как использовать? Установите плагин robots.txt стандартным способом. То есть, из админки. Плагины — Добавить новый. Введите в окно поиска его название — Robots.txt Editor:

Добавить плагин Robots.txt Editor

Добавить плагин Robots.txt EditorУстановили и сразу активировали. Всё, готово. Теперь смотрим, что получилось. Заходим, Настройки — Чтение и видим результат. Автоматически созданный правильный файл robots.txt для WordPress со ссылкой на ваш файл Sitemap. Пример, правильный robots.txt для сайта ВордПресс:

Созданный файл robots.txt WordPress

Созданный файл robots.txt WordPressЕстественно, вы можете его легко отредактировать под свои нужды. А также просмотреть, нажав соответствующею ссылку — Просмотр robots.txt.

Как создать robots.txt вручную

Если вы не захотите использовать плагины, которые предлагают функцию robots.txt, вы все равно можете создать и управлять своим файлом robots.txt на своём хостинге. Как создать файл robots.txt самостоятельно?

В текстовом редакторе создайте файл с именем robots в формате txt и заполните его:

Создать файл с именем robots.txt

Создать файл с именем robots.txtФайл должен иметь имя robots.txt и никакое другое больше. Сохраните данный файл локально на компьютере. А затем, загрузите созданный файл в корневую директорию вашего сайта.

Корневая папка (корневая директория/корневой каталог/корень документа) — это основная папка, в которой хранятся все файлы сайта. Обычно, это папка public_html (там где находятся файлы — .htaccess, wp-config.php и другие). Именно в эту папку загружается файл robots.txt:

Загрузите файл в корневую папку вашего сайта

Загрузите файл в корневую папку вашего сайта Чтобы проверить, получилось ли у вас положить файл в нужное место, перейдите по адресу: https://ваш_сайт.ru/robots.txt

Теперь, когда ваш файл robots.txt создан и загружен на сайт, вы можете проверить его на ошибки.

Проверка вашего файла robots.txt

Вы можете проверить файл robots.txt WordPress в Google Search Console и Яндекс.Вебмастер, чтобы убедиться, что он правильно составлен.

Например, проверка файла robots.txt WordPress в Яндекса.Вебмастер. В блоке Результаты анализа robots.txt перечислены директивы, которые будет учитывать робот при индексировании сайта.

Анализ robots.txt в Яндекс.Вебмастер

Анализ robots.txt в Яндекс.ВебмастерЕсли будет найдена ошибка, информация об этом будет показана вам.

В заключение

Для некоторых сайтов WordPress нет необходимости срочно изменять стандартный виртуальный файл robots.txt (по умолчанию). Но, если вам нужен физический файл robots.txt, то используйте плагины Robots.txt Editor, All in One SEO Pack или Yoast SEO. С ними можно легко редактировать файл прямо из панели инструментов WordPress, чтобы добавить свои собственные правила.

До новых встреч, друзья и я надеюсь, что вам понравилось это маленькое руководство. И не стесняйтесь, обязательно оставьте комментарий, если у вас возникнут дополнительные вопросы по использованию файла robots.txt на сайте WordPress.

Правильный robots txt для WordPress сайта – инструкция на 2019-2020 год без плагинов

Для чего нужен robots.txt

Robots.txt создан для регулирования поведения поисковых роботов на сайтах, а именно куда им заходить можно и брать в поиск, а куда нельзя. Лет 10 назад сила данного файла была велика, по его правилам работали все поисковые системы, но сейчас он скорее как рекомендация, чем правило.

Но пока не отменили, вебмастера должны делать его и настраивать правильно исходя из структуры и иерархии сайтов. Отдельная тема это WordPress, потому что CMS содержит множество элементов, которые не нужно сканировать и отдавать в индекс. Разберемся как правильно составить robots.txt

Где лежит файл robots в WordPress

На любом из ресурсов robots.txt должен лежать в корневой папке. В случае с вордпресс, там где находится папка wp-admin и ей подобные.

Расположение на сервере

Расположение на сервереЕсли не создавался и не загружался администратором сайта, то по умолчанию на сервере не найти. Стандартная сборка WordPress не предусматривает наличие такого объекта.

Как создать правильный robots txt

Создать правильный robots txt задача не трудная, сложнее прописать в нем правильные директивы. Сначала создадим документ, открываем программу блокнот и нажимаем сохранить как.

Сохраняем документ

Сохраняем документВ следующем окне задаем название robots, оставляем расширение txt, кодировку ANSI и нажимаем сохранить. Объект появится в папке куда произошло сохранение. Пока документ пустой и ничего не содержит в себе, давайте разберемся какие именно директивы он может поддерживать.

При желании можете сразу скачать его на сервер в корень через программу FileZilla.

Сохранение роботса

Сохранение роботсаНастройка команд

Выделю четыре основные команды:

- User-agent: показывает правила для разных поисковых роботов, либо для всех, либо для отдельных

- Disalow: запрещает доступ

- Allow: разрешаем доступ

- Sitemap: адрес до XML карты

Устаревшие и ненужные конфигурации:

- Host: указывает главное зеркало, стало не нужным, потому что поиск сам определит правильный вариант

- Crawl-delay: ограничивает время на пребывание робота на странице, сейчас сервера мощные и беспокоится о производительности не нужно

- Clean-param: ограничивает загрузку дублирующегося контента, прописать можно, но толку не будет, поисковик проиндексирует все, что есть на сайте и возьмет по–максимому страниц

Рабочий пример инструкций для WordPress

Дело в том что поисковой робот не любит запрещающие директивы, и все равно возьмет в оборот, что ему нужно. Запрет на индексацию должен быть объектов, которые 100% не должны быть в поиске и в базе Яндекса и Гугла. Данный рабочий пример кода помещаем в robots txt.

User-agent: *

Disallow: /wp-

Disallow: /tag/

Disallow: */trackback

Disallow: */page

Disallow: /author/*

Disallow: /template.html

Disallow: /readme.html

Disallow: *?replytocom

Allow: */uploads

Allow: *.js

Allow: *.css

Allow: *.png

Allow: *.gif

Allow: *.jpg

Sitemap: https://ваш домен/sitemap.xmlРазберемся с текстом и посмотрим что именно мы разрешили, а что запретили:

- User-agent, поставили знак *, тем самым сообщив что все поисковые машины должны подчиняться правилам

- Блок с Disallow запрещает к индексу все технические страницы и дубли. обратите внимание что я заблокировал папки начинающиеся на wp-

- Блок Allow разрешает сканировать скрипты, картинки и css файлы, это необходимо для правильного представления проекта в поиске иначе вы получите портянку без оформления

- Sitemap: показывает путь до XML карты сайта, обязательно нужно ее сделать, а так же заменить надпись”ваш домен”

Остальные директивы рекомендую не вносить, после сохранения и внесения правок, загружаем стандартный robots txt в корень WordPress. Для проверки наличия открываем такой адрес https://your-domain/robots.txt, заменяем домен на свой, должно отобразится так.

Адрес в строке запроса

Адрес в строке запросаКак проверить работу robots.txt

Стандартный способ проверить через сервис yandex webmaster. Для лучшего анализа нужно зарегистрировать и установить на сайт сервис. Вверху видим загрузившийся robots, нажимаем проверить.

Проверка документа в yandex

Проверка документа в yandexНиже появится блок с ошибками, если их нет то переходим к следующему шагу, если неверно отображается команда, то исправляем и снова проверяем.

Отсутствие ошибок в валидаторе

Отсутствие ошибок в валидатореПроверим правильно ли Яндекс обрабатывает команды, спускаемся чуть ниже, введем два запрещенных и разрешенных адреса, не забываем нажать проверить. На снимке видим что инструкция сработала, красным помечено что вход запрещен, а зеленой галочкой, что индексирование записей разрешена.

Проверка папок и страниц в яндексе

Проверка папок и страниц в яндексеПроверили, все срабатывает, перейдем к следующему способу это настройка robots с помощью плагинов. Если процесс не понятен, то смотрите наше видео.

Плагин–генератор Virtual Robots.txt

Если не хочется связываться с FTP подключением, то приходит на помощь один отличный WordPress плагин–генератор называется Virtual Robots.txt. Устанавливаем стандартно из админки вордпресс поиском или загрузкой архива, выглядит так.

Как выглядит Virtual Robots.txt

Как выглядит Virtual Robots.txtПереходим в админку Настройки > Virtual Robots.txt, видим знакомую конфигурацию, но нам нужно ее заменить, на нашу из статьи. Копируем и вставляем, не забываем сохранять.

Настройка Virtual Robots.txt

Настройка Virtual Robots.txtРоботс автоматически создастся и станет доступен по тому же адресу. При желании проверить есть он в файлах WordPress – ничего не увидим, потому что документ виртуальный и редактировать можно только из плагина, но Yandex и Google он будет виден.

Добавить с помощью Yoast SEO

Знаменитый плагин Yoast SEO предоставляет возможность добавить и изменить robots.txt из панели WordPress. Причем созданный файл появляется на сервере (а не виртуально) и находится в корне сайта, то есть после удаления или деактивации роботс остается. Переходим в Инструменты > Редактор.

Yoast SEO редактор файлов

Yoast SEO редактор файловЕсли robots есть, то отобразится на странице, если нет есть кнопка “создать”, нажимаем на нее.

Кнопка создания robots

Кнопка создания robotsВыйдет текстовая область, записываем, имеющийся текст из универсальной конфигурации и сохраняем. Можно проверить по FTP соединению документ появится.

Изменить модулем в All in One SEO

Старый плагин All in One SEO умеет изменять robots txt, чтобы активировать возможность переходим в раздел модули и находим одноименный пункт, нажимаем Activate.

Модули в All In one Seo

Модули в All In one SeoВ меню All in One SEO появится новый раздел, заходим, видим функционал конструктора.

Работа в модуле AIOS

Работа в модуле AIOS- Записываем имя агента, в нашем случае * или оставляем пустым

- Разрешаем или запрещаем индексацию

- Директория или страница куда не нужно идти

- Результат

Модуль не удобный, создать по такому принципу валидный и корректный robots.txt трудно. Лучше используйте другие инструменты.

Правильная настройка для плагина WooCommerce

Чтобы сделать правильную настройку для плагина интернет магазина на WordPress WooCommerce, добавьте эти строки к остальным:

Disallow: /cart/

Disallow: /checkout/

Disallow: /*add-to-cart=*

Disallow: /my-account/

Делаем аналогичные действия и загружаем на сервер через FTP или плагином.

Итог

Подведем итог что нужно сделать чтобы на сайте WordPress был корректный файл для поисковиков:

- Создаем вручную или с помощью плагина файл

- Записываем в него инструкции из статьи

- Загружаем на сервер

- Проверяем в валидаторе Yandex

- Не пользуйтесь генераторами robots txt в интернете, пошевелите немного руками

Совершенствуйте свои блоги на WordPress, продвигайтесь и правильно настраивайте все параметры, а мы в этом поможем, успехов!

Пожалуйста, оцените материал: Мне нравится15Не нравитсяКак создать файл robots.txt для сайта

Здравствуйте, уважаемые читатели. Не так давно я написал статью о создании карты сайта. Карта сайта, значительно упрощает индексацию вашего блога. Карта сайта должна быть в обязательном порядке у каждого сайта и блога. Но также на каждом сайте и блоге должен быть файл robots.txt. Файл robots.txt содержит свод инструкций для поисковых роботов. Можно сказать, — правила поведения поисковых роботов на вашем блоге. А также в данном файле содержится путь к карте сайта вашего блога. И, по сути, при правильно составленном файле robots.txt поисковый робот не тратит драгоценное время на поиск карты сайта и индексацию не нужных файлов.

Что же из себя представляет файл robots.txt?

robots.txt – это текстовый файл, может быть создан в обычном «блокноте», расположенный в корне вашего блога, содержащий инструкции для поисковых роботов.

Эти инструкции ограничивают поисковых роботов от беспорядочной индексации всех файлов вашего бога, и нацеливают на индексацию именно тех страниц, которым следует попасть в поисковую выдачу.

С помощью данного файла, вы можете запретить индексацию файлов движка WordPress. Или, скажем, секретного раздела вашего блога. Вы можете указать путь к карте Вашего блога и главное зеркало вашего блога. Здесь я имею ввиду, ваше доменное имя с www и без www.

Индексация сайта с robots.txt и без

Работа robots.txt

Данный скриншот, наглядно показывает, как файл robots.txt запрещает индексацию определённых папок на сайте. Без файла, роботу доступно всё на вашем сайте.

Основные директивы файла robots.txt

Для того чтобы разобраться с инструкциями, которые содержит файл robots.txt нужно разобраться с основными командами (директивы).

User-agent – данная команда обозначает доступ роботам к вашему сайту. Используя эту директиву можно создать инструкции индивидуально под каждого робота.

Пример:

User-agent: Yandex – правила для робота Яндекс

User-agent: * — правила для всех роботов

Disallow и Allow – директивы запрета и разрешения. С помощью директивы Disallow запрещается индексация а с помощью Allow разрешается.

Пример запрета:

User-agent: *

Disallow: / — запрет ко всему сайта.

User-agent: Yandex

Disallow: /admin – запрет роботу Яндекса к страницам лежащим в папке admin.

Пример разрешения:

User-agent: *

Allow: /photo

Disallow: / — запрет ко всему сайту, кроме страниц находящихся в папке photo.

Примечание! директива Disallow: без параметра разрешает всё, а директива Allow: без параметра запрещает всё. И директивы Allow без Disallow не должно быть.

Sitemap – указывает путь к карте сайта в формате xml.

Пример:

Sitemap: https://1zaicev.ru/sitemap.xml.gz

Sitemap: https://1zaicev.ru/sitemap.xml

Host – директива определяет главное зеркало Вашего блога. Считается, что данная директива прописывается только для роботов Яндекса. Данную директиву следует указывать в самом конце файла robots.txt.

Пример:

User-agent: Yandex

Disallow: /wp-includes

Host: 1zaicev.ru

Примечание! адрес главного зеркала указывается без указания протокола передачи гипертекста (http://).

Как создать robots.txt

Теперь, когда мы познакомились с основными командами файла robots.txt можно приступать к созданию нашего файла. Для того чтобы создать свой файл robots.txt с вашими индивидуальными настройками, вам необходимо знать структуру вашего блога.

Мы рассмотрим создание стандартного (универсального) файла robots.txt для блога на WordPress. Вы всегда сможете дополнить его своими настройками.

Итак, приступаем. Нам понадобится обычный «блокнот», который есть в каждой операционной системе Windows. Или TextEdit в MacOS.

Открываем новый документ и вставляем в него вот эти команды:

User-agent: * Disallow: Sitemap: https://1zaicev.ru/sitemap.xml.gz Sitemap: https://1zaicev.ru/sitemap.xml User-agent: Yandex Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /xmlrpc.php Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /wp-content/languages Disallow: /category/*/* Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: /tag/ Disallow: /feed/ Disallow: */*/feed/*/ Disallow: */feed Disallow: */*/feed Disallow: /?feed= Disallow: /*?* Disallow: /?s= Host: 1zaicev.ru

Не забудьте заменить параметры директив Sitemap и Host на свои.

Важно! при написании команд, допускается лишь один пробел. Между директивой и параметром. Ни в коем случае не делайте пробелов после параметра или просто где попало.

Пример: Disallow:<пробел>/feed/<Enter>

Данный пример файла robots.txt универсален и подходит под любой блог на WordPress с ЧПУ адресами url. О том что такое ЧПУ читайте здесь. Если же Вы не настраивали ЧПУ, рекомендую из предложенного файла удалить Disallow: /*?* Disallow: /?s=

Теперь нужно сохранить файл с именем robots.txt.

Сохранение robots.txt

Загрузка файла robots.txt на сервер

Лучшим способом для такого рода манипуляций является FTP соединение. О том как настроить FTP соединение для TotolCommander читайте здесь. Или же Вы можете использовать файловый менеджер на Вашем хостинге.

Я воспользуюсь FTP соединением на TotolCommander.

Сеть > Соединится с FTP сервером.

FTP-соединение

Выбрать нужное соединение и нажимаем кнопку «Соединиться».

Выбор FTP-соединения

Открываем корень блога и копируем наш файл robots.txt, нажав клавишу F5.

Копирование robots.txt на сервер

Вот теперь Ваш файл robots.txt будет исполнять надлежащие ему функции. Но я всё же рекомендую провести анализ robots.txt, чтобы удостоверится в отсутствии ошибок.

Анализ robots.txt

Для этого Вам потребуется войти в кабинет вебмастера Яндекс или Google. Рассмотрим примере Яндекс. Здесь можно провести анализ даже не подтверждая прав на сайт. Вам достаточно иметь почтовый ящик на Яндекс.

Открываем кабинет Яндекс.вебмастер.

Яндекс.вебмастер

На главной странице кабинета вебмастер, открываем ссылку «Проверить robots.txt».

Проверка robots.txt

Для анализа потребуется ввести url адрес вашего блога и нажать кнопку «Загрузить robots.txt с сайта». Как только файл будет загружен нажимаем кнопку «Проверить».

Анализ robots.txt

Отсутствие предупреждающих записей, свидетельствует о правильности создания файла robots.txt.

Теперь следует проверить ссылки Ваших материалов, дабы убедится, что Вы не запретили индексацию чего то нужного.

Для этого нажимаем на ссылку «Список URL добавить». Вводим ссылки Ваших материалов. И нажимаем кнопку «Проверить»

Добавление url

Ниже будет представлен результат. Где ясно и понятно какие материалы разрешены для показа поисковым роботам, а какие запрещены.

Результат анализа файла robots.txt

Здесь же вы можете вносить изменения в robots.txt и экспериментировать до получения нужного вам результата. Но помните, файл расположенный на вашем блоге при этом не меняется. Для этого вам потребуется полученный здесь результат скопировать в блокнот, сохранить как robots.txt и скопировать на Вас блог.

Кстати, если вам интересно как выглядит файл robots.txt на чьём-то блоге, вы может с лёгкостью его посмотреть. Для этого к адресу сайта нужно просто добавить /robots.txt

Пример:

https://1zaicev.ru/robots.txt

Вот теперь ваш robots.txt готов. И помните не откладывайте в долгий ящик создание файла robots.txt, от этого будет зависеть индексация вашего блога.

Если же вы хотите создать правильный robots.txt и при этом быть уверенным, что в индекс поисковых систем попадут только нужные страницы, то это можно сделать и автоматически с помощью плагина Clearfy.

На этом у меня всё. Всем желаю успехов. Если будут вопросы или дополнения пишите в комментариях.

До скорой встречи.

С уважением, Максим Зайцев.

Правильный файл robots.txt под Яндекс и Google для WordPress, Joomla, uCoz

Далеко не все современные вебмастеры умеют работать с HTML-кодом. Многие даже не знают, как должны выглядеть функции, прописанные в ключевых файлах CMS. Внутренности вашего ресурса, такие как файл robots.txt, являются интеллектуальной собственностью, в которой владелец должен быть, как рыба в воде. Тонкая настройка сайта позволяет повысить его поисковые рейтинги, вывести в топ и успешно собирать трафик.

Файл robots.txt — один из основных элементов подгонки ресурса под требования поисковых систем. Он содержит техническую информацию и ограничивает доступ к ряду страниц поисковым роботам. Ведь далеко не каждая написанная страница должна непременно оказаться в выдаче. Раньше для создания файла robots txt был необходим доступ через FTP. Равитие CMS открыло возможность получить к нему доступ прямо через панель управления.

Для чего нужен файл robots.txt

Этот файл содержит ряд рекомендаций, адресованных поисковым ботам. Он ограничивает их доступ к некоторым частям сайта. Из-за размещения этого файла в корневом каталоге, боты никак не смогут его пропустить. В результате, попадая на ваш ресурс, они сначала читают правила его обработки, а уже только после этого начинают проверку.

Таким образом, файл указывает поисковым роботам, какие директории сайта разрешены для индексирования, и какие этому процессу не подлежат.

Учитывая, что на процесс ранжирования наличие файла напрямую не влияет, много сайтов не содержат robots.txt. Но путь полного доступа нельзя считать техически правильным. Рассмотрим преимущества robots.txt, которые он дает ресурсу.

Можно запретить индексирование ресурса целиком или частично, ограничить круг поисковых роботов, которые будут иметь право на проведение индексирования. Приказывая robots.txt запретить все, вы сможете полностью изолировать ресурс на время ремонта или реконструкции.

Кроме того, файл роботс ограничивает доступ на ресурс всевозможных спам-роботов. Их основная цель — сканирование сайта на наличие электронных адресов, которые потом будут использоваться для рассылки спама. Не будем останавливаться на том, к чему это может привести — и так понятно.

Кроме того, файл роботс ограничивает доступ на ресурс всевозможных спам-роботов. Их основная цель — сканирование сайта на наличие электронных адресов, которые потом будут использоваться для рассылки спама. Не будем останавливаться на том, к чему это может привести — и так понятно.

От индексирования можно скрыть разделы сайта, предназначенные не для поисковых машин, а для определенного круга пользователей, разделы, содержащие приватную и прочую подобную информацию.

Как создать правильный robots.txt

Правильный robots легко написать вручную, не прибегая к помощи различных конструкторов. Процесс сводится к прописыванию нужных директив в обычном файле блокнота, который, после внесения всех данных, сохраняется под названием «robots». Вам остаётся только закачать его в корневую директорию собственного ресурса. Для одного сайта нужен только один такой файл. В нем можно прописать инструкции для ботов всех нужных поисковых систем. То есть, делать отдельный файл под каждый поисковик не понадобится. Полноценный robots.txt пример может выглядеть так:

Теперь поговорим о том, что должно находиться внутри robots.txt. Обязательно употребление двух директив: User-agent и Disallow. Первая определяет, какому боту адресовано данное послание. Вторая показывает, какую страницу или директорию ресурса запрещено индексировать.

Чтобы задать одинаковые правила для всех ботов, можно в директиве User-agent вместо названия прописать символ: * (звездочку).

Файл robots.txt в таком случае будет выглядеть следующим образом:

Как можно догадаться, /file.html — это название конкретного файла, индексация которого запрещена. /papka/ — название директории, на содержимое которой не будет распространятся индексация.

Как можно догадаться, /file.html — это название конкретного файла, индексация которого запрещена. /papka/ — название директории, на содержимое которой не будет распространятся индексация.

Если нужно снять ограничения и разрешить индексацию всех страниц, файл следует изменить так:

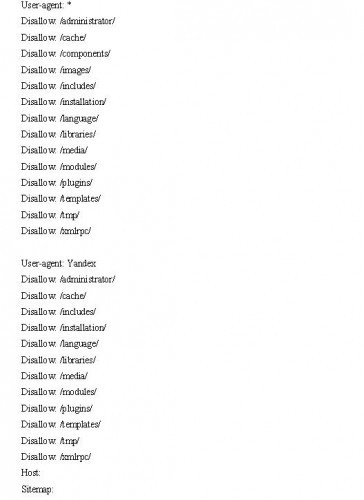

Особенности настройки robots.txt для Яндекс и Google

Особенности настройки robots.txt для Яндекс и Google

Файл robots.txt для Яндекса раньше должен был содержать обязательную директиву host. Это позволяло избежать проблем с индексированием зеркала ресурса или иных дублей его страниц.

Host — директива, которую понимал только бот Яндекса. Поэтому, при создании файла robots.txt одновременно для Яндекса, Гугла и других поисковых систем, следовало разделить директивы.

Host — директива, которую понимал только бот Яндекса. Поэтому, при создании файла robots.txt одновременно для Яндекса, Гугла и других поисковых систем, следовало разделить директивы.

Безвременная кончина этой директивы произошла в марте 2018. Так что больше её использовать не нужно.

Безвременная кончина этой директивы произошла в марте 2018. Так что больше её использовать не нужно.

Создание файла robots.txt Google ничем не отличается от процесса, описанного выше. В директиве User-agent нужно прописать название бота поисковика: Googlebot, Googlebot-Image (для ограничения индексаций изображений),Googlebot-Mobile (для версий сайтов, рассчитанных на мобильные приложения) и т.п.

Желательно указать в файле путь к карте сайта — директива robots.txt sitemap. Благодаря этому робот будет быстрее ориентироваться на страницах ресурса, что значительно ускорит процесс индексации.

Кстати, разработчики Гугл неоднократно напоминали веб-мастерам, что файл robots.txt не должен превышать по размерам 500 Кб. Это непременно приведет к ошибкам при индексации. Если создавать файл вручную, то «достичь» такого размера, конечно, нереально. Но вот некоторые CMS, автоматически формирующие содержание robots.txt, могут значительно его перегрузить.

Простое создание файла для любого поисковика

Если вы боитесь заниматься тонкой настройкой самостоятельно, её можно провести автоматически. Существуют конструкторы, собирающие подобные файлы без вашего участия. Они подходят людям, которые только начинают своё становление в качестве вебмастеров.

Как видно на изображении, настройка конструктора начинается с введения адреса сайта. Далее вы выбираете поисковые системы, с которыми планируете работать. Если вам не важна выдача той или иной поисковой системы, то нет необходимости создавать под неё настройки. Теперь переходите к указанию папок и файлов, доступ к которым планируете ограничить. В данном примере вы сможете указать адрес карты и зеркала вашего ресурса.

Robots.txt generator будет заполнять форму по мере наполнения конструктора. Всё, что в дальнейшем от вас потребуется — это скопировать полученный текст в txt-файл. Не забудьте присвоить ему название robots.

Как проверить эффективность файла robots.txt

Для того, чтобы проанализировать действие файла в Яндексе, следует перейти на соответствующую страницу в разделе Яндекс.Вебмастер. В диалоговом окне укажите имя сайта и нажмите кнопку «загрузить».

Система проанализирует файл robots.txt проверка покажет, будет ли поисковый робот обходить страницы, запрещенные к индексации. Если возникли проблемы, директивы можно отредактировать и проверить прямо в диалоговом окне. Правда после этого вам придётся скопировать отредактированный текст и вставить в свой файл robots.txt в корневом каталоге.

Аналогичную услугу предоставляет сервис «Инструменты для веб-мастеров» от поисковика Google.

Создание robots.txt для WordPress , Joomla и Ucoz

Различные CMS, получившие широкую популярность на просторах Рунета, предлагают пользователям свои версии файлов robots.txt. Некоторые из них не имеют таких файлов вовсе. Зачастую эти файлы либо слишком универсальны и не учитывают особенностей ресурса пользователя, либо имеют ряд существенных недостатков.

Опытный специалист может вручную исправить положение (при недостатке знаний так лучше не делать). Если вы боитесь копаться во внутренностях сайта, воспользуйтесь услугами коллег. Подобные манипуляции, при знании дела, занимают всего пару минут времени. Например, robots.txt WordPress может выглядеть таким образом:

Файл robots.txt для Ucoz предоставляется автоматически. Он имеет оптимальные настройки. Единственный его недостаток — система создаст файл, спустя примерно месяц, после конструирования ресурса. Если неохота ждать, можно написать файл самостоятельно. Выглядеть он будет так:

Файл robots.txt для Ucoz предоставляется автоматически. Он имеет оптимальные настройки. Единственный его недостаток — система создаст файл, спустя примерно месяц, после конструирования ресурса. Если неохота ждать, можно написать файл самостоятельно. Выглядеть он будет так:

Joomla позволяет нескольким URL ссылаться на одну и ту же страницу. Поисковые системы примут такие настройки за дублирование контента. Избежать этого поможет установка robots.txt для Joomla следующего содержания:

Joomla позволяет нескольким URL ссылаться на одну и ту же страницу. Поисковые системы примут такие настройки за дублирование контента. Избежать этого поможет установка robots.txt для Joomla следующего содержания:

В последних двух строчках, как несложно догадаться, нужно прописать данные собственного ресурса.

Заключение

Есть ряд навыков, обязательных для освоения любым вебмастером. И самостоятельная настройка и ведение сайта — один из них. Начинающие сайтостроители могут таких дров наломать во время отладки ресурса, что потом не разгребёшь. Если вы не хотите терять потенциальную аудиторию и позиции в выдаче из-за структуры сайта, подходите к процессу её настройка основательно и ответственно.

Как оптимизировать ваш Robots.txt для SEO в WordPress (Руководство для начинающих)

Недавно один из наших читателей попросил нас дать советы о том, как оптимизировать файл robots.txt для улучшения SEO. Файл Robots.txt сообщает поисковым системам, как сканировать ваш сайт, что делает его невероятно мощным инструментом SEO. В этой статье мы покажем вам, как создать идеальный файл robots.txt для SEO.

Что такое файл robots.txt?

Robots.txt — это текстовый файл, который владельцы веб-сайтов могут создать, чтобы сообщить роботам поисковых систем, как сканировать и индексировать страницы на своем сайте.

Обычно он хранится в корневом каталоге, также известном как основная папка вашего веб-сайта. Базовый формат файла robots.txt выглядит так:

Пользовательский агент: [имя пользовательского агента] Disallow: [строка URL не сканироваться] Пользовательский агент: [имя пользовательского агента] Разрешить: [строка URL для сканирования] Карта сайта: [URL-адрес вашего XML-файла Sitemap]

У вас может быть несколько строк инструкций, чтобы разрешить или запретить определенные URL-адреса и добавить несколько карт сайта.Если вы не запрещаете URL-адрес, роботы поисковых систем предполагают, что им разрешено сканировать его.

Вот как может выглядеть файл примера robots.txt:

Пользовательский агент: * Разрешить: / wp-content / uploads / Запретить: / wp-content / plugins / Запретить: / wp-admin / Карта сайта: https://example.com/sitemap_index.xml

В приведенном выше примере robots.txt мы разрешили поисковым системам сканировать и индексировать файлы в нашей папке загрузки WordPress.

После этого мы запретили поисковым роботам сканировать и индексировать плагины и папки администратора WordPress.

Наконец, мы предоставили URL-адрес нашей XML-карты сайта.

Вам нужен файл Robots.txt для вашего сайта WordPress?

Если у вас нет файла robots.txt, поисковые системы все равно будут сканировать и индексировать ваш сайт. Однако вы не сможете указать поисковым системам, какие страницы или папки им не следует сканировать.

Это не окажет большого влияния, когда вы впервые создаете блог и у вас мало контента.

Однако по мере того, как ваш веб-сайт растет и у вас появляется много контента, вы, вероятно, захотите лучше контролировать то, как ваш веб-сайт сканируется и индексируется.

Вот почему.

У поисковых роботов есть квота сканирования для каждого веб-сайта.

Это означает, что они просматривают определенное количество страниц во время сеанса сканирования. Если они не завершат сканирование всех страниц вашего сайта, они вернутся и возобновят сканирование в следующем сеансе.

Это может снизить скорость индексации вашего сайта.

Вы можете исправить это, запретив поисковым роботам пытаться сканировать ненужные страницы, такие как ваши административные страницы WordPress, файлы плагинов и папки тем.

Запрещая ненужные страницы, вы сохраняете квоту сканирования. Это помогает поисковым системам сканировать еще больше страниц на вашем сайте и индексировать их как можно быстрее.

Еще одна веская причина использовать файл robots.txt — это когда вы хотите, чтобы поисковые системы не индексировали сообщение или страницу на вашем веб-сайте.

Это не самый безопасный способ скрыть контент от широкой публики, но он поможет вам предотвратить их появление в результатах поиска.

Что делают идеальные роботы.txt должен выглядеть как файл?

Многие популярные блоги используют очень простой файл robots.txt. Их содержание может отличаться в зависимости от потребностей конкретного сайта:

Пользовательский агент: * Запретить: Карта сайта: http://www.example.com/post-sitemap.xml Карта сайта: http://www.example.com/page-sitemap.xml

Этот файл robots.txt позволяет всем ботам индексировать весь контент и предоставляет им ссылку на XML-карту сайта веб-сайта.

Для сайтов WordPress мы рекомендуем следующие правила в файле robots.txt файл:

Пользовательский агент: * Разрешить: / wp-content / uploads / Запретить: / wp-content / plugins / Запретить: / wp-admin / Запретить: /readme.html Запретить: / ссылаться / Карта сайта: http://www.example.com/post-sitemap.xml Карта сайта: http://www.example.com/page-sitemap.xml

Указывает поисковым роботам индексировать все изображения и файлы WordPress. Он запрещает поисковым роботам индексировать файлы плагинов WordPress, область администрирования WordPress, файл readme WordPress и партнерские ссылки.

Добавляя карты сайта в файл robots.txt, вы упрощаете роботам Google поиск всех страниц на вашем сайте.

Теперь, когда вы знаете, как выглядит идеальный файл robots.txt, давайте посмотрим, как создать файл robots.txt в WordPress.

Как создать файл Robots.txt в WordPress?

Есть два способа создать файл robots.txt в WordPress. Вы можете выбрать наиболее подходящий для вас метод.

Метод 1. Редактирование роботов.txt с помощью Yoast SEO

Если вы используете плагин Yoast SEO, он поставляется с генератором файлов robots.txt.

Вы можете использовать его для создания и редактирования файла robots.txt прямо из админки WordPress.

Просто перейдите на страницу SEO »Инструменты в админке WordPress и щелкните ссылку Редактор файлов.

На следующей странице Yoast SEO покажет существующий файл robots.txt.

Если у вас нет файла robots.txt, то Yoast SEO сгенерирует для вас файл robots.txt.

По умолчанию генератор файлов robots.txt Yoast SEO добавляет в файл robots.txt следующие правила:

Пользовательский агент: * Запретить: /

важно, удалить этот текст, потому что он блокирует сканирование вашего сайта всеми поисковыми системами.

После удаления текста по умолчанию вы можете продолжить и добавить свои собственные правила robots.txt. Мы рекомендуем использовать идеальных роботов.txt, который мы использовали выше.

Когда вы закончите, не забудьте нажать кнопку «Сохранить файл robots.txt», чтобы сохранить изменения.

Метод 2. Отредактируйте файл Robots.txt вручную с помощью FTP

Для этого метода вам нужно будет использовать FTP-клиент для редактирования файла robots.txt.

Просто подключитесь к своей учетной записи хостинга WordPress с помощью FTP-клиента.

Попав внутрь, вы сможете увидеть файл robots.txt в корневой папке вашего веб-сайта.

Если вы его не видите, скорее всего, у вас нет robots.txt файл. В этом случае вы можете просто создать его.

Robots.txt — это простой текстовый файл, что означает, что вы можете загрузить его на свой компьютер и отредактировать с помощью любого текстового редактора, такого как Блокнот или TextEdit.

После сохранения изменений вы можете загрузить их обратно в корневую папку вашего сайта.

Как проверить файл Robots.txt?

После создания файла robots.txt всегда полезно протестировать его с помощью инструмента тестирования robots.txt.

Существует множество инструментов для тестирования robots.txt, но мы рекомендуем использовать тот, который находится в консоли поиска Google.

Просто войдите в свою учетную запись Google Search Console, а затем переключитесь на старый сайт поисковой консоли Google.

Вы перейдете к старому интерфейсу Google Search Console. Отсюда вам нужно запустить тестер robots.txt, расположенный в меню «Сканирование».

Инструмент автоматически загрузит роботов с вашего сайта.txt и выделите ошибки и предупреждения, если они были обнаружены.

Последние мысли

Цель оптимизации файла robots.txt — запретить поисковым системам сканировать страницы, которые не являются общедоступными. Например, страницы в папке wp-plugins или страницы в папке администратора WordPress.

Среди экспертов по SEO распространен миф о том, что блокировка категорий, тегов и архивных страниц WordPress улучшит скорость сканирования и приведет к более быстрой индексации и повышению рейтинга.

Это неправда. Это также противоречит рекомендациям Google для веб-мастеров.

Мы рекомендуем использовать указанный выше формат robots.txt для создания файла robots.txt для своего веб-сайта.

Мы надеемся, что эта статья помогла вам узнать, как оптимизировать файл robots.txt WordPress для SEO. Вы также можете увидеть наше полное руководство по WordPress SEO и лучшие инструменты WordPress SEO для развития вашего сайта.

Если вам понравилась эта статья, то подпишитесь на наш канал YouTube для видеоуроков по WordPress.Вы также можете найти нас в Twitter и Facebook.

.Генератор Robots.txt

Инструменты SEO

Инструменты, которые помогут вам создать и продвигать свой веб-сайт.

Расширения FirefoxВеб-инструменты Если вам нужна обратная связь или у вас есть какие-либо животрепещущие вопросы, задавайте их на форуме сообщества, чтобы мы могли их решить.

Обзор

Обзор содержания сайта.Включает карту сайта, глоссарий и контрольный список для быстрого старта.

SEO

Содержит информацию о ключевых словах, SEO на странице, построении ссылок и социальном взаимодействии.

КПП

Советы по покупке трафика в поисковых системах.

Отслеживание

Узнайте, как отслеживать свой успех с помощью обычных объявлений SEO и PPC. Включает информацию о веб-аналитике.

Доверие

Создание заслуживающего доверия веб-сайта — это основа того, чтобы быть достойным ссылок и продавать клиентам.

Монетизация

Узнайте, как зарабатывать деньги на своих веб-сайтах.

Аудио и видео

Ссылки на полезную аудио и видео информацию. Мы будем создавать новые SEO-видео каждый месяц.

Интервью

Эксклюзивные интервью только для участников.

Скидки

купонов и предложений, которые помогут вам сэкономить деньги на продвижении ваших сайтов.

Карта сайта

Просмотрите все наши учебные модули, на которые есть ссылки на одной странице.

Хотите проверить файл robots.txt?

Получите конкурентное преимущество сегодня

Ваши ведущие конкуренты годами инвестируют в свою маркетинговую стратегию.

Теперь вы можете точно знать, где они ранжируются, выбирать лучшие ключевые слова и отслеживать новые возможности по мере их появления.

Изучите рейтинг своих конкурентов в Google и Bing сегодня с помощью SEMrush.

Введите конкурирующий URL-адрес ниже, чтобы быстро получить бесплатный доступ к их истории эффективности обычного и платного поиска.

Посмотрите, где они занимают место, и побейте их!

- Исчерпывающие данные о конкуренции: исследований эффективности в обычном поиске, AdWords, объявлениях Bing, видео, медийных объявлениях и многом другом.

- Сравните по каналам: используйте чью-то стратегию AdWords, чтобы стимулировать рост вашего SEO, или используйте их стратегию SEO, чтобы инвестировать в платный поиск.

- Глобальный охват: Отслеживает результаты Google по более чем 120 миллионам ключевых слов на многих языках на 28 рынках.

- Исторические данные о производительности: восходит к прошлому десятилетию, до появления Panda и Penguin, так что вы можете искать исторические штрафы и другие потенциальные проблемы с рейтингом.

- Без риска: Бесплатная пробная версия и низкая ежемесячная плата.

Ваши конкуренты, исследуют ваш сайт

Об авторе